خبراء MIT يدعون إلى تعزيز حوكمة وتنظيم الذكاء الاصطناعي

Most people like

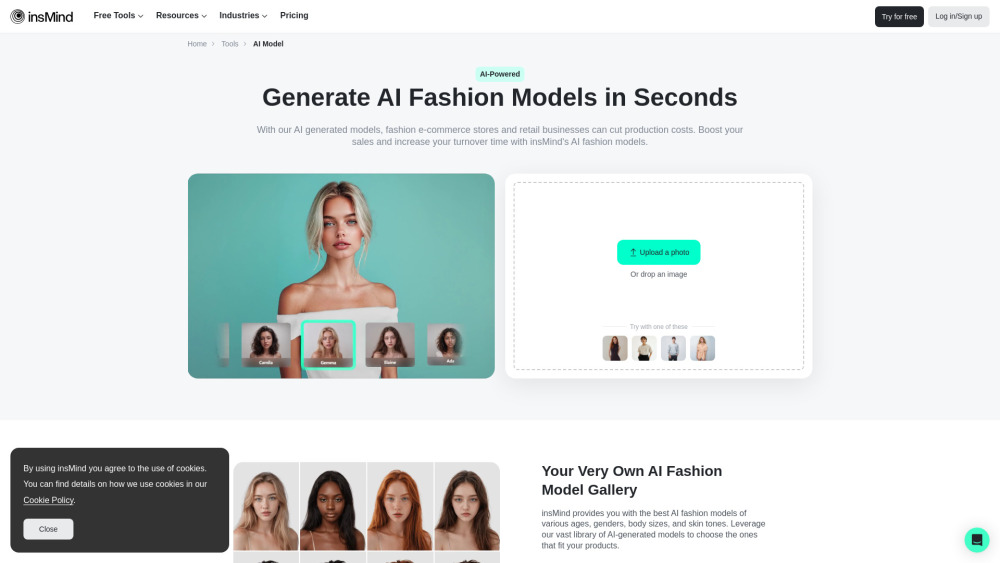

رفع جودة تصوير منتجاتك مع نماذج الأزياء التي تنتجها الذكاء الصناعي من insMind. اختر من مجموعة متنوعة من النماذج الذكائية، التي تضم أجناسًا وألوان بشرة وألوان شعر وأحجام أجسام مختلفة. حول صورك المنزلية إلى صور مدهشة وحيوية لنماذج باستخدام ميزة استبدال الوجوه السهلة الاستخدام. مثالي لتعزيز جاذبية علامتك التجارية!

حوّل صوتك: أفضل مُحوّل صوت للعب والبث المباشر

اكتشف مُحوّل الصوت المثالي لتحسين تجربتك في اللعب والبث المباشر. سواء كنت ترغب في تسلية جمهورك، أو إضافة طبقة من anonymity، أو مجرد الاستمتاع، فإن مُحوّل الصوت الأعلى تصنيفًا لدينا يعزز أدائك ويبقي تفاعلاتك مشوقة. مع مجموعة متنوعة من المؤثرات القابلة للتخصيص وميزات سهلة الاستخدام، يمكنك إنشاء أصوات فريدة تناسب أسلوب لعبك أو شخصيتك في البث. استكشف الاحتمالات اللامتناهية وارتق بمحتواك إلى المستوى التالي!

ميتوالأداة فعالة مصممة لتبسيط تحرير بيانات جداولك الإلكترونية مع توليد كود بايثون بسهولة. سواء كنت تسعى لزيادة الإنتاجية أو تبسيط التعامل مع البيانات، توفر ميتو واجهة مستخدم بديهية تجعل البرمجة في متناول الجميع. عزز قدرات جدول البيانات الخاص بك وحوّل سير عمل بياناتك مع ميتو اليوم!

اكتشف برنامج تحرير الصور المدعوم بالذكاء الاصطناعي الذي يغير تمامًا تجربتك في التصوير الفوتوغرافي. مع ميزات متقدمة وأدوات بديهية، يعزز هذا البرنامج القوي صورك إلى مستوى احترافي، مما يجعل من السهل أكثر من أي وقت مضى تحسين، وإعادة لمس، وتحويل صورك بكل سهولة. مثالي للمصورين من جميع مستويات المهارة، يجمع بين الذكاء الاصطناعي والمرونة الإبداعية لتحقيق رؤيتك.

Find AI tools in YBX

Related Articles

Refresh Articles