مؤسس OpenAI إيليا سوتسكيڤر يُطلق شركة ناشئة لمواجهة تحديات الذكاء الفائق الآمن

Most people like

نقدّم لكم Labnote، المنصّة الرائدة التي تحدث ثورة في تجربة البحث للعلماء. من خلال تقديم ملاحظات مختبر منظمة واستغلال تقنيات التعلم الآلي المتقدمة، يعزّز Labnote الإنتاجية ويسرّع من كافة مراحل عملية البحث.

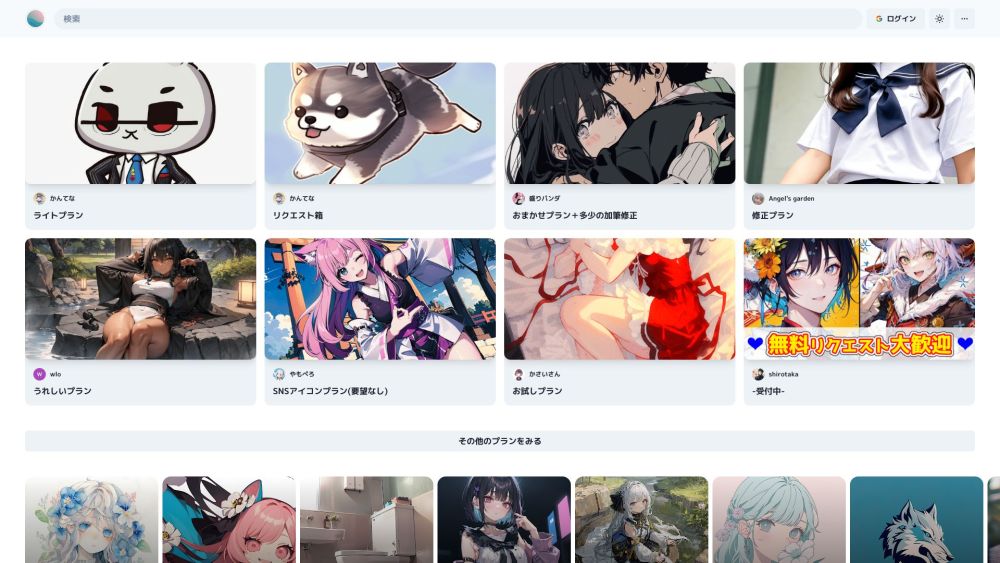

اكتشف برومبتون، منصة مبتكرة لرسم الصور بالذكاء الاصطناعي تقدم مجموعة متنوعة من خدمات التصميم المخصصة لاحتياجاتك الإبداعية.

Find AI tools in YBX

Related Articles

Refresh Articles