مايكروسوفت: لماذا لا يمكن للذكاء الاصطناعي استبدال الخبرة البشرية في مكان العمل

Most people like

في زمن تصبح فيه التفاعلات السلسة من الأمور الأساسية، تبرز منصة الذكاء الاصطناعي الصوتي في الوقت الحقيقي كحل ثوري. هذه التكنولوجيا المبتكرة تحول طريقة تواصلنا من خلال الاستفادة من الذكاء الاصطناعي المتقدم لتسهيل معالجة الصوت الفورية. سواء كان ذلك للخدمات العملاء، الاجتماعات الافتراضية، أو الاستخدام الشخصي، تعزز هذه المنصة كفاءة ووضوح الاتصال، مما يجعلها أداة لا تقدر بثمن في عالمنا الرقمي المتزايد. عِش تجربة مستقبل تفاعل الصوت بقوة الذكاء الاصطناعي الفوري.

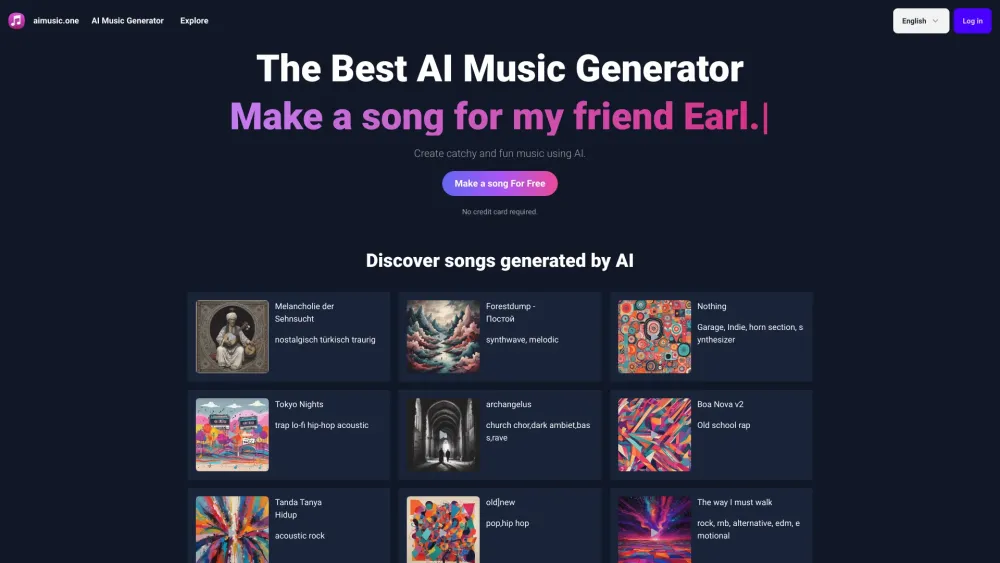

اكتشف عالم الموسيقى الفريدة التي تولدها الذكاء الاصطناعي. استكشف كيف يمكن للذكاء الاصطناعي أن ينشئ مؤلفات أصلية ساحرة تدفع حدود صناعة الموسيقى التقليدية. اغمر نفسك في مشهد صوتي مبتكر حيث يلتقي الإبداع التكنولوجي بالفن، وافتح آفاق إبداعك بفضل قوة الذكاء الاصطناعي في إنتاج الموسيقى.

Find AI tools in YBX

Related Articles

Refresh Articles