ChatGPT Supera el Test de Turing: un Hito en las Capacidades de Comunicación Humana de la IA

Most people like

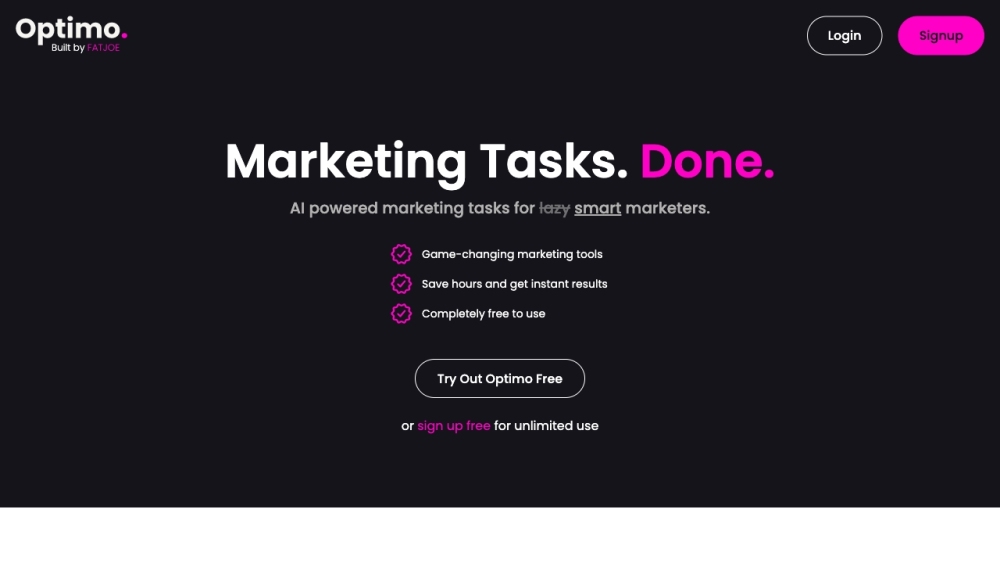

Optimo optimiza las tareas de marketing, permitiendo a los mercadólogos ahorrar tiempo y obtener resultados inmediatos sin esfuerzo.

Imagga es una potente API diseñada para ofrecer soluciones avanzadas de reconocimiento de imágenes, lo que permite una etiquetado fluido, una categorización efectiva, capacidades de búsqueda eficientes y robustas características de moderación.

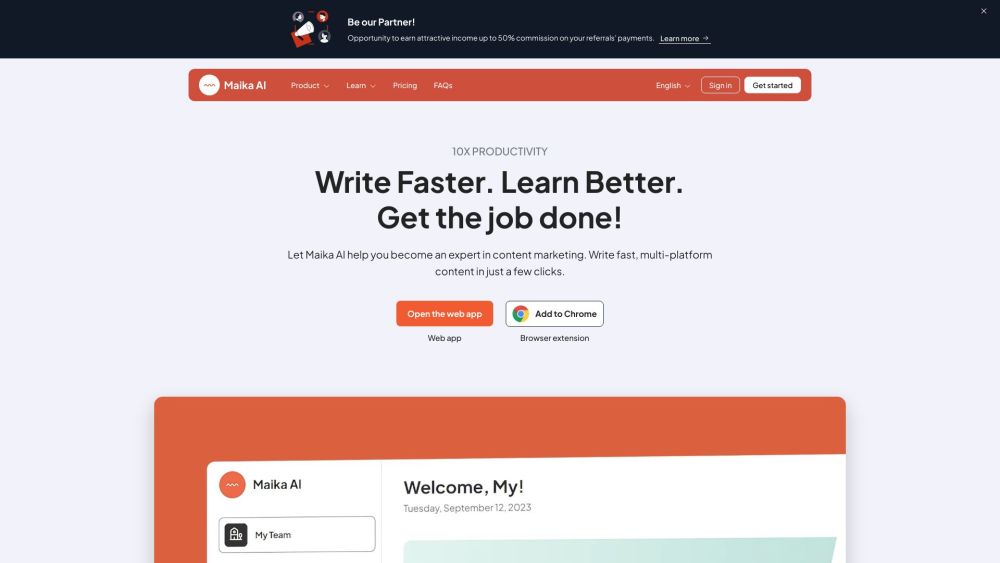

Descubre la herramienta definitiva de creación de contenido impulsada por IA, diseñada específicamente para marketers y creadores de contenido. Mejora tu estrategia de contenido, optimiza tu flujo de trabajo y conecta de manera efectiva con tu audiencia utilizando tecnología de inteligencia artificial de vanguardia. ¡Desbloquea tu potencial creativo y eleva tus campañas de marketing hoy mismo!

Find AI tools in YBX

Related Articles

Refresh Articles