Comprendiendo la IA Sombra y sus Retos para los Departamentos de TI

La IA sombra se está convirtiendo en un desafío significativo para los departamentos de TI encargados de implementar y gestionar servicios de IA generativa. Alarmantemente, el 45% de las empresas carece de una política formal sobre el uso de la IA generativa, lo que las hace vulnerables a riesgos.

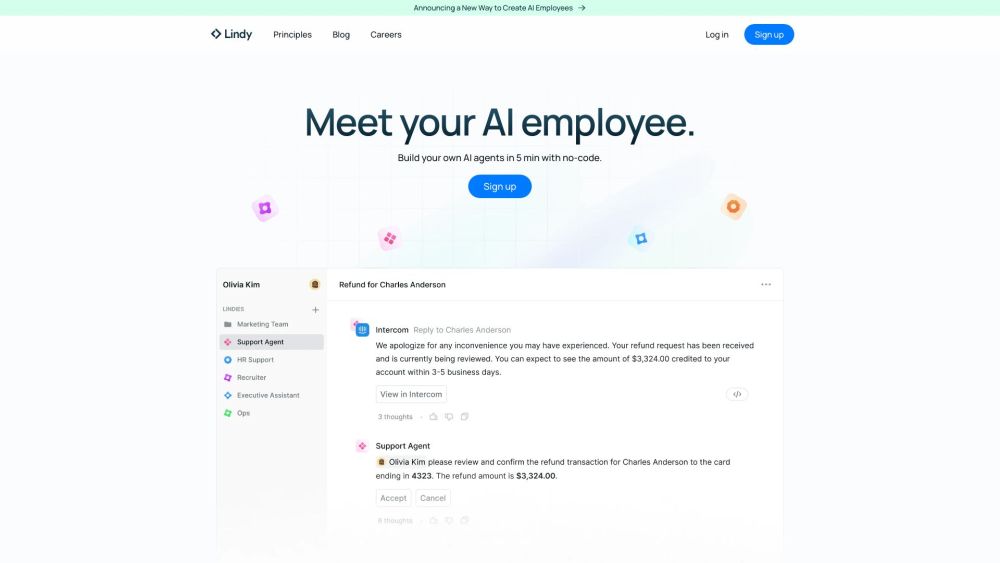

Con la proliferación de modelos de lenguaje de gran tamaño (LLMs) y su creciente accesibilidad, el personal de TI puede acceder fácilmente a LLMs y GPU como servicio a través de varios proveedores de nube pública o API especializadas. Esta accesibilidad ha facilitado que los trabajadores del conocimiento creen sus propios asistentes digitales mediante interfaces amigables en laptops o dispositivos móviles.

El Auge de la IA Sombra

El estado actual de la IA sombra refleja la aparición de aplicaciones SaaS y servicios de nube pública, donde los líderes de TI enfrentaban a unidades de negocio y desarrolladores que adquirían software sin aprobación. Los departamentos de TI a menudo respondían restringiendo la TI sombra o estableciendo acuerdos incómodos con los empleados que preferían sus aplicaciones elegidas.

Paralelamente, el consumo en la nube se disparó, provocando costos excesivos debido a errores de configuración y sobreaprovisionamiento. A medida que la TI comenzó a evaluar inversiones en función del valor comercial, el enfoque se trasladó a la optimización del gasto en la nube.

Reequilibrar las cargas de trabajo de TI se volvió esencial a medida que las organizaciones se dieron cuenta de que muchas aplicaciones podrían tener un mejor rendimiento en locales o en entornos de nube alternativos. Con algunos proveedores de nube reconsiderando las tarifas de salida de datos, los líderes de TI están repensando sus estrategias. Aunque la nube pública es un excelente entorno para pruebas rápidas de aplicaciones y escalado, también aumenta la susceptibilidad a cargas de trabajo no autorizadas.

Navegando la Gobernanza de la IA

La democratización de las capacidades de IA presenta un dilema de gobernanza para los líderes de TI. A pesar de los desafíos, los CEO están ansiosos por adoptar servicios de IA generativa, haciendo que la cancelación sea poco factible.

En cambio, los líderes de TI deben encontrar un equilibrio entre apoyar las iniciativas de los empleados en IA generativa e implementar una gobernanza responsable que respete las limitaciones presupuestarias.

Identificando Casos de Uso Ideales para IA

Para lograr esto, los líderes de TI deben colaborar con los ejecutivos de negocio para identificar los casos de uso óptimos para la IA generativa. Este proceso requerirá compromisos de ambas partes, con TI restringiendo opciones de servicio y estandarizando herramientas. Cada caso de uso debe evaluarse en términos de costo-efectividad y rendimiento, ya sea en entornos locales o alojados. Algunas aplicaciones pueden rendir mejor en configuraciones de nube pública, pero muchas prosperarán en locales, beneficiándose de una supervisión y seguridad mejoradas.

Implementar un LLM en locales también puede generar ahorros. Un estudio reciente de Enterprise Strategy Group (ESG) reveló que realizar inferencias con un LLM de código abierto utilizando generación aumentada por recuperación (RAG) en locales es a menudo más económico que utilizar recursos de nube pública o servicios basados en API.

En las pruebas de ESG, encontraron que:

- Una instancia del modelo Mistral 7B de código abierto, comparada con Amazon Web Services (AWS) EC2, fue un 38% a 48% más rentable, con ahorros que crecían con el aumento de usuarios.

- Comparando una instancia de Meta Llama 2 con 70 mil millones de parámetros contra AWS EC2, mostró una ventaja de costo del 69% al 75%.

- Probar Llama 2 (70B parámetros) contra GPT-4 Turbo de OpenAI para 50,000 usuarios empresariales indicó que era un 81% a 88% más rentable.

Si bien implementar servicios de IA generativa en locales no eliminará la IA sombra, puede ayudar a mitigar su impacto. Monitorear modelos internamente facilita que los equipos de TI aborden problemas derivados de resultados inesperados, enfatizando la importancia de alinear las iniciativas de IA con los datos organizacionales.

Colaborando para el Éxito

Las organizaciones probablemente operarán cargas de trabajo de IA generativa en diversos entornos, incluidas nubes públicas y privadas y ubicaciones en el borde. Decidir dónde implementar LLMs puede ser complejo, y socios de confianza como Dell Technologies pueden ofrecer un apoyo crítico en este camino, proporcionando servidores optimizados para IA, dispositivos modernos y servicios profesionales.

La IA sombra presenta desafíos significativos, pero con la estrategia y las asociaciones adecuadas, las empresas pueden establecer un marco responsable de IA generativa. El socio adecuado puede iluminar el camino a seguir.

Descubre más sobre las soluciones de IA de Dell.