El exlíder de Superalignamiento de OpenAI critica a la empresa: ‘Se han descuidado la cultura y los procesos de seguridad’.

Most people like

Presentamos un modelo de lenguaje de vanguardia que crea textos indistinguibles de los escritos por humanos. Esta tecnología avanzada potencia la creación de contenido, ofreciendo material escrito de alta calidad y envolvente con facilidad.

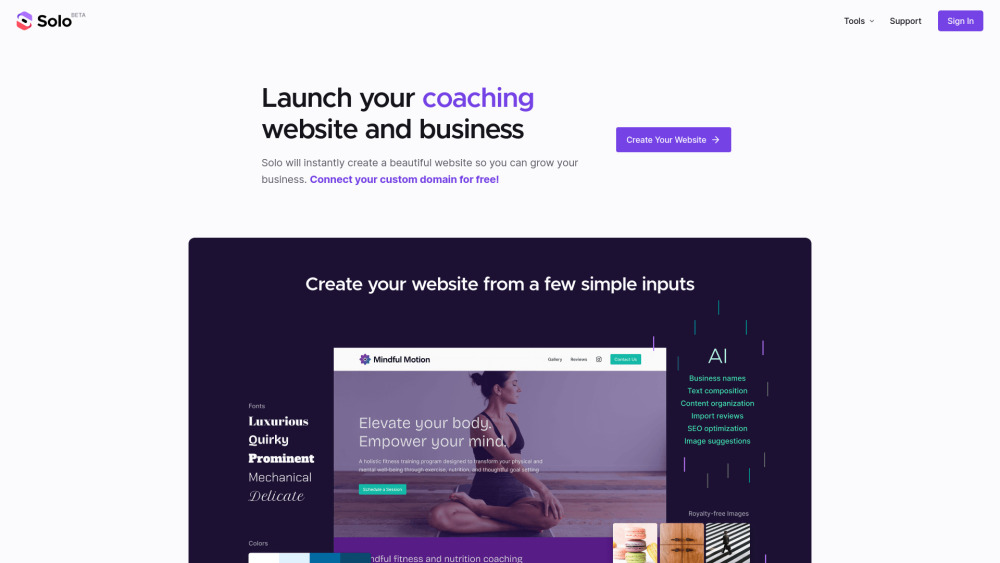

En el panorama digital actual, contar con una presencia en línea impactante es crucial para empresas de todos los tamaños. Un creador de sitios web basado en IA simplifica el proceso de construir un sitio profesional, permitiendo a emprendedores y empresas crear páginas deslumbrantes sin esfuerzo. Al aprovechar la tecnología avanzada, estas herramientas ofrecen plantillas personalizables e interfaces intuitivas, capacitando a los usuarios para establecer su identidad de marca y mejorar la interacción con los clientes. Descubre cómo un creador de sitios web de IA puede transformar tu estrategia empresarial y potenciar el éxito en línea.

En el vertiginoso panorama digital actual, la inteligencia artificial conversacional está a la vanguardia de la innovación tecnológica. Esta rama de la inteligencia artificial se centra en crear sistemas capaces de mantener diálogos similares a los humanos, mejorando la experiencia del usuario en diversas plataformas. Desde chatbots hasta asistentes virtuales, el desarrollo y análisis de la IA conversacional desempeñan un papel crucial en la transformación de nuestra interacción con la tecnología. Acompáñanos mientras exploramos los últimos avances y conocimientos en este emocionante campo, descubriendo el potencial que la IA conversacional tiene para negocios y usuarios por igual.

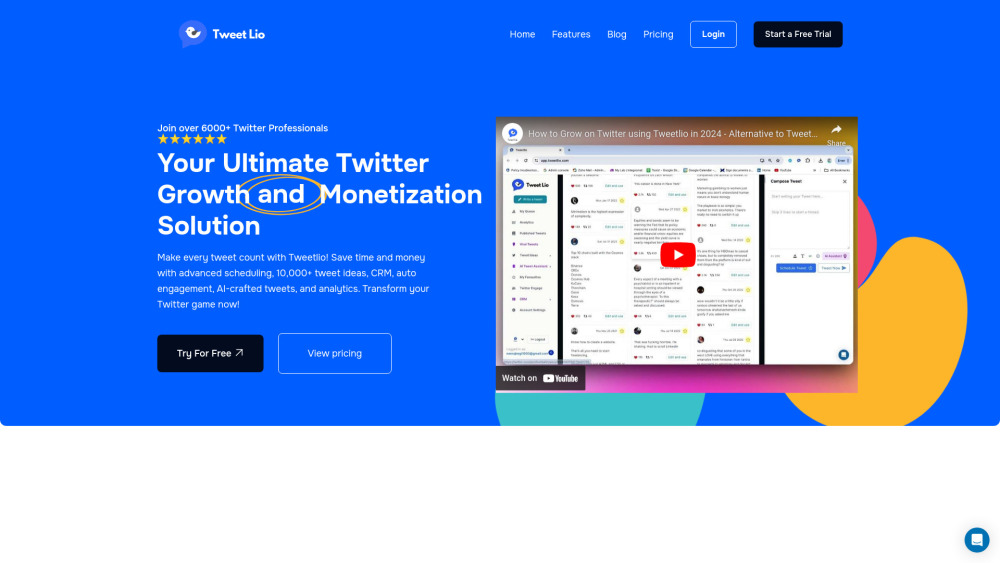

Descubre la herramienta de IA definitiva diseñada para simplificar la programación de tus publicaciones en Twitter y aumentar el compromiso. Perfecta para individuos y empresas, esta solución innovadora no solo organiza tus publicaciones, sino que también las optimiza para lograr la máxima interacción. Experimenta una forma más inteligente de conectar en Twitter y eleva tu presencia en línea.

Find AI tools in YBX

Related Articles

Refresh Articles