Estudio de OpenAI Revela el Impacto Inesperado de la IA en el Futuro del Desarrollo de Amenazas Biológicas

Most people like

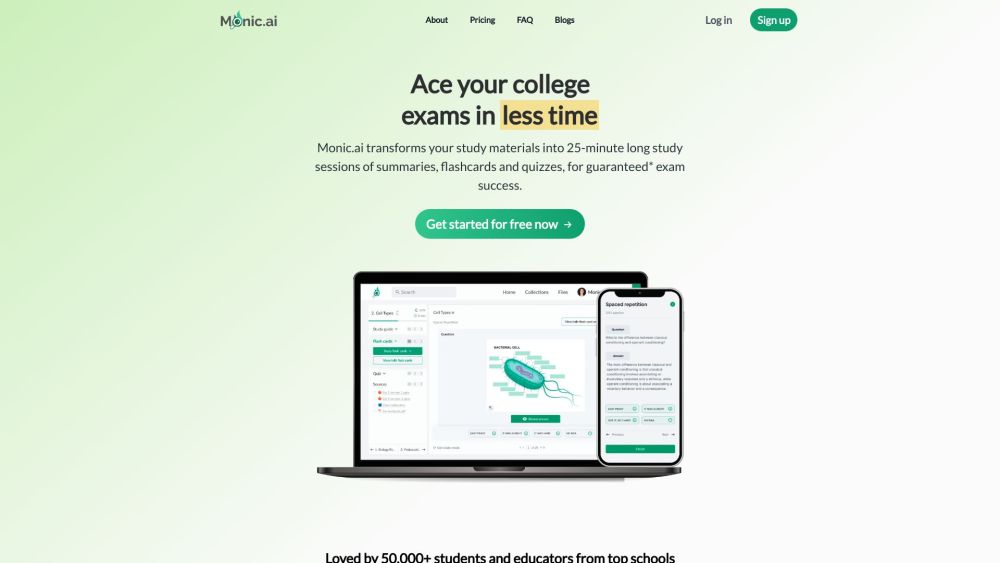

Desbloquea el poder de GPT-4 para crear contenido educativo atractivo y evaluaciones. Sumérgete en un mundo donde la inteligencia artificial enriquece las experiencias educativas, proporcionando materiales personalizados que mejoran los resultados de aprendizaje. Ya seas un educador en busca de recursos innovadores o un estudiante que busca evaluaciones personalizadas, GPT-4 ofrece una solución dinámica para revolucionar tu enfoque hacia la educación.

Eleva tu contenido visual transformando videos y mejorando imágenes con el poder de la tecnología de IA.

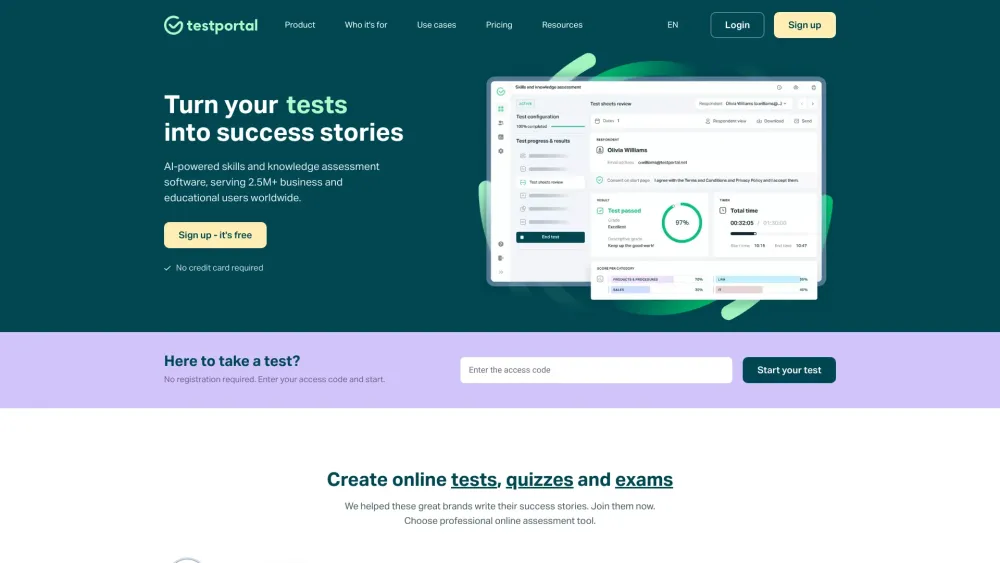

Descubre una plataforma de evaluación en línea innovadora, diseñada para crear pruebas, cuestionarios y exámenes de manera sencilla. Mejora tu experiencia educativa y simplifica los procesos de evaluación con nuestras herramientas intuitivas, adaptadas para educadores y formadores por igual.

En el contexto digital en rápida evolución de hoy, la IA educativa efectiva está transformando cómo aprendemos y enseñamos. Al aprovechar algoritmos avanzados e información basada en datos, las soluciones impulsadas por IA mejoran las experiencias de aprendizaje personalizadas, aumentan la participación estudiantil y optimizan los procesos administrativos. Este artículo explora el profundo impacto de la IA educativa en la educación moderna, destacando sus beneficios y su potencial para revolucionar el entorno de aprendizaje. Acompáñanos mientras profundizamos en el futuro de la tecnología educativa y su papel en el fomento de una mejor educación para todos.

Find AI tools in YBX

Related Articles

Refresh Articles