Una carta abierta publicada el martes por más de una docena de empleados actuales y anteriores de OpenAI, DeepMind de Google y Anthropic destaca los “serios riesgos” asociados con el desarrollo acelerado de la tecnología de inteligencia artificial (IA) ante la ausencia de un marco de supervisión eficaz. Los investigadores advierten que una IA no regulada podría agravar desigualdades existentes, manipular información, difundir desinformación y potencialmente provocar la pérdida de control sobre sistemas de IA autónoma, con graves consecuencias para la humanidad.

Los firmantes afirman que estos riesgos pueden ser “adecuadamente mitigados” mediante la colaboración entre la comunidad científica, los legisladores y el público. Sin embargo, expresan su preocupación de que “las empresas de IA tienen fuertes incentivos financieros para evitar una supervisión efectiva” y no pueden ser confiables para guiar el desarrollo responsable de tecnologías poderosas.

Desde el lanzamiento de ChatGPT en noviembre de 2022, la IA generativa ha transformado rápidamente el panorama tecnológico, con grandes proveedores de nube como Google Cloud, Amazon AWS, Oracle y Microsoft Azure liderando el camino en lo que se proyecta como un mercado de billones de dólares para 2032. Un estudio reciente de McKinsey reveló que, hasta marzo de 2024, casi el 75% de las organizaciones encuestadas han integrado la IA en sus operaciones. Además, la encuesta anual Work Index de Microsoft encontró que tres cuartas partes de los trabajadores de oficina ya utilizan herramientas de IA en sus trabajos.

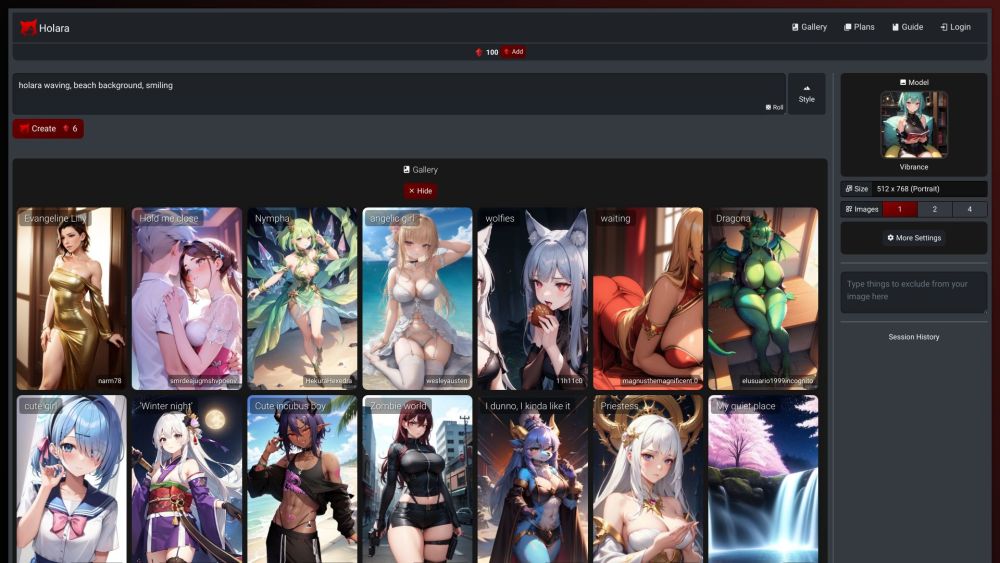

Sin embargo, como señaló Daniel Kokotajlo, ex empleado de OpenAI, en una conversación con The Washington Post, algunas empresas han adoptado una mentalidad de “moverse rápido y romper cosas”, que es inadecuada para una tecnología que es tanto poderosa como poco entendida. Startups de IA como OpenAI y Stable Diffusion han enfrentado desafíos con las leyes de derechos de autor en EE. UU., mientras que varios chatbots de acceso público han sido manipulados para generar discursos de odio, teorías de conspiración y desinformación.

Los empleados preocupados por la IA argumentan que estas empresas poseen “información no pública sustancial” sobre las capacidades y limitaciones de sus productos, incluidos los riesgos potenciales de daño y la efectividad de sus medidas de seguridad. Enfatizan que solo una fracción de esta información está disponible para entidades gubernamentales a través de “débiles obligaciones de compartir”, dejando al público en gran medida desinformado.

“Con una supervisión gubernamental insuficiente sobre estas corporaciones, los empleados actuales y anteriores representan una de las pocas vías para exigirles rendición de cuentas al público”, afirmó el grupo. Criticaron la dependencia de la industria tecnológica en acuerdos de confidencialidad y la inadecuada aplicación de las protecciones existentes para denunciantes. La carta insta a las empresas de IA a eliminar los acuerdos de no desprestigio, establecer un proceso anónimo de reporte para que las preocupaciones de los empleados sean atendidas por la dirección de la empresa y los reguladores, y garantizar que los denunciantes públicos no enfrenten represalias si los canales internos fracasan.