GPT-4o: Descubre las Nuevas Funciones de la Última Actualización de ChatGPT y su Fecha de Lanzamiento

Most people like

YesChat.ai aprovecha las poderosas capacidades de GPT-4V, DALL-E 3 y Claude 2 para mejorar sus avanzadas características de chatbot de IA.

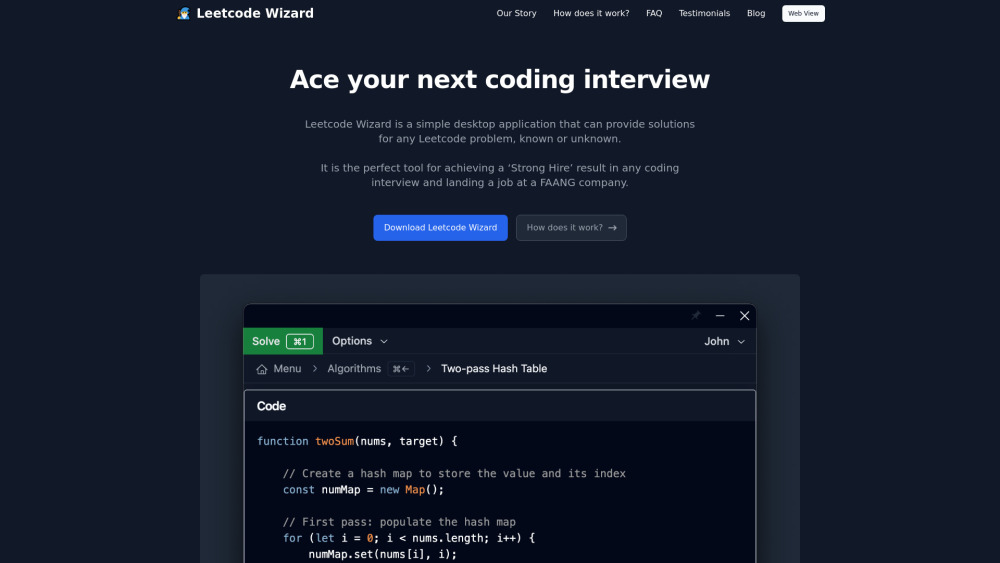

Descubre una poderosa aplicación de escritorio diseñada para abordar los desafíos de codificación de Leetcode con facilidad. Nuestro software innovador ofrece soluciones personalizadas y análisis, ayudándote a mejorar tus habilidades de programación y aumentar tu confianza en el código.

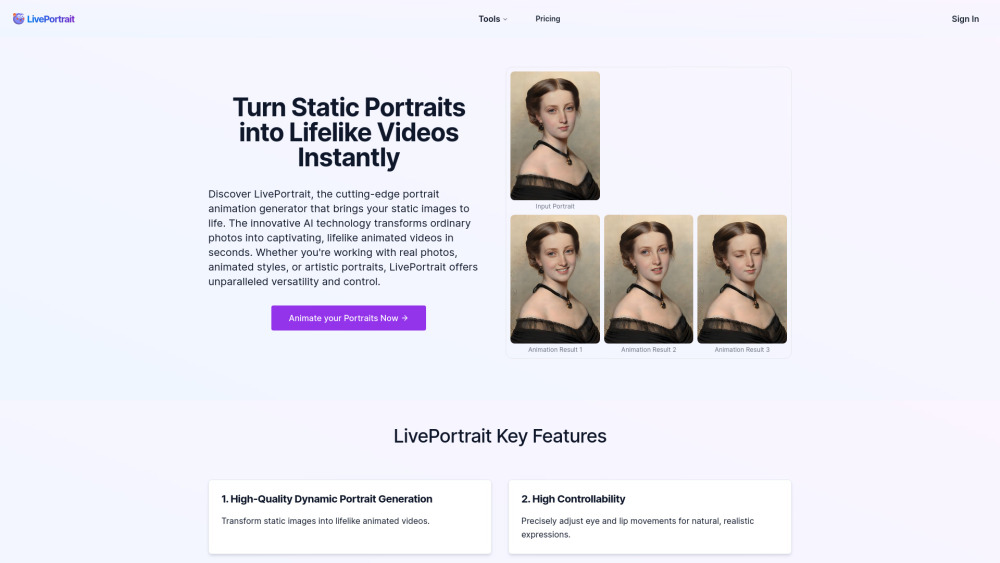

En el vertiginoso panorama digital actual, el generador de animaciones de retratos con IA se destaca como una herramienta revolucionaria. Esta tecnología innovadora permite a los usuarios dar vida a imágenes fijas, creando animaciones dinámicas que capturan la esencia de las emociones y expresiones del sujeto. Ya sea para proyectos personales, contenido en redes sociales o presentaciones profesionales, aprovechar el poder de la animación de retratos impulsada por IA puede elevar tu narrativa visual y tu interacción. Descubre cómo esta herramienta de vanguardia puede revolucionar la forma en que animas retratos, convirtiéndolos en experiencias animadas cautivadoras que resuenan con el público.

Presentamos un sistema de interfaz generativa potenciado por IA, diseñado para revolucionar la experiencia del usuario. Esta tecnología innovadora aprovecha el poder de la inteligencia artificial para crear interfaces dinámicas y reactivas que se adaptan a las necesidades y preferencias individuales. Descubre cómo nuestro enfoque generativo mejora la eficiencia del diseño y eleva la calidad de la interacción.

Find AI tools in YBX

Related Articles

Refresh Articles