Google Presenta Veo: Un Impresionante Nuevo Modelo de Video Generativo de IA para Competir con Sora de OpenAI

Most people like

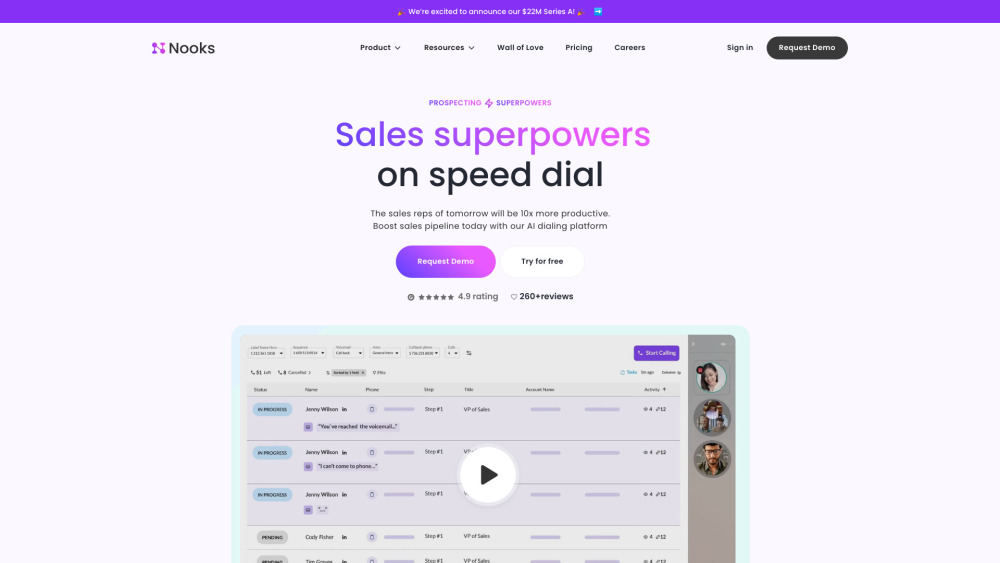

En el acelerado entorno empresarial actual, maximizar la productividad de ventas es esencial para el éxito. Una plataforma de productividad de ventas impulsada por inteligencia artificial aprovecha la tecnología avanzada para optimizar los procesos de ventas, mejorar el rendimiento del equipo y fomentar el crecimiento de ingresos. Al automatizar tareas repetitivas, ofrecer valiosos insights y facilitar un mejor compromiso con los clientes, esta solución innovadora permite a los equipos de ventas concentrarse en lo que mejor saben hacer: cerrar negocios. Acompáñanos a explorar cómo integrar la IA en tu estrategia de ventas puede transformar tu enfoque hacia la productividad y aportar resultados medibles.

En el vertiginoso panorama digital actual, la inteligencia artificial conversacional está a la vanguardia de la innovación tecnológica. Esta rama de la inteligencia artificial se centra en crear sistemas capaces de mantener diálogos similares a los humanos, mejorando la experiencia del usuario en diversas plataformas. Desde chatbots hasta asistentes virtuales, el desarrollo y análisis de la IA conversacional desempeñan un papel crucial en la transformación de nuestra interacción con la tecnología. Acompáñanos mientras exploramos los últimos avances y conocimientos en este emocionante campo, descubriendo el potencial que la IA conversacional tiene para negocios y usuarios por igual.

Presentamos una plataforma de primer nivel para la obtención de licencias de sincronización musical, muestreo, remasterización, remezcla y reinterpretación innovadora. Explora infinitas posibilidades creativas y eleva tus proyectos musicales con nuestras herramientas integrales diseñadas para artistas, productores y creadores de contenido.

Find AI tools in YBX

Related Articles

Refresh Articles