Google lanza PaliGemma: su primer modelo multimodal de visión y lenguaje abierto para mejorar las capacidades de inteligencia artificial.

Most people like

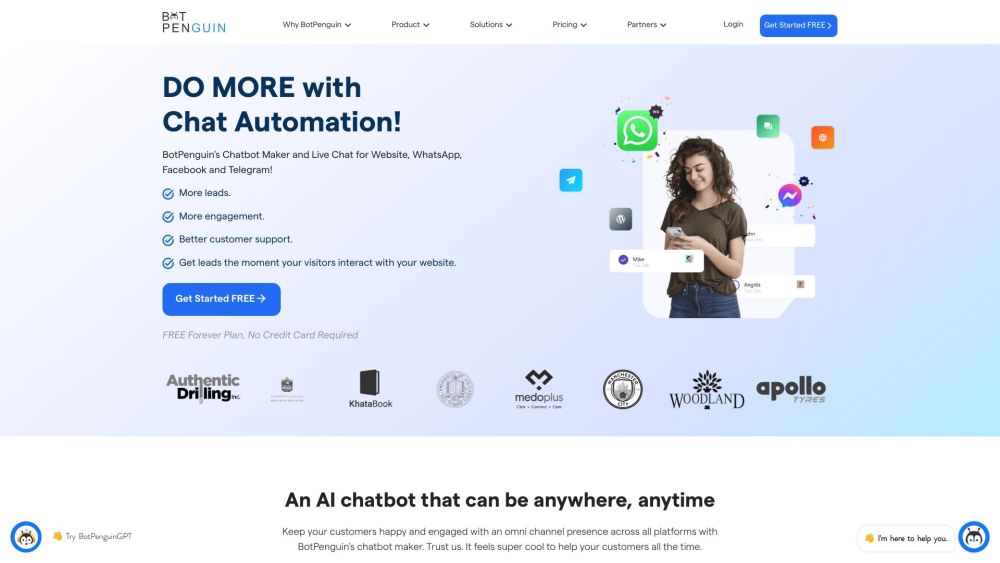

BotPenguin es un innovador chatbot de IA diseñado para optimizar el soporte al cliente y mejorar la interacción con los visitantes en las empresas. Al automatizar las interacciones, BotPenguin garantiza que tus clientes reciban asistencia rápida y eficiente, creando una experiencia fluida que aumenta la satisfacción y la retención.

Presentamos Voice-Swap: una herramienta innovadora de IA diseñada para una transformación de voz sin interrupciones. Perfecta para colaboraciones remotas y para ofrecer demostraciones realistas, Voice-Swap permite a los usuarios mejorar sus proyectos con una sorprendente versatilidad de audio.

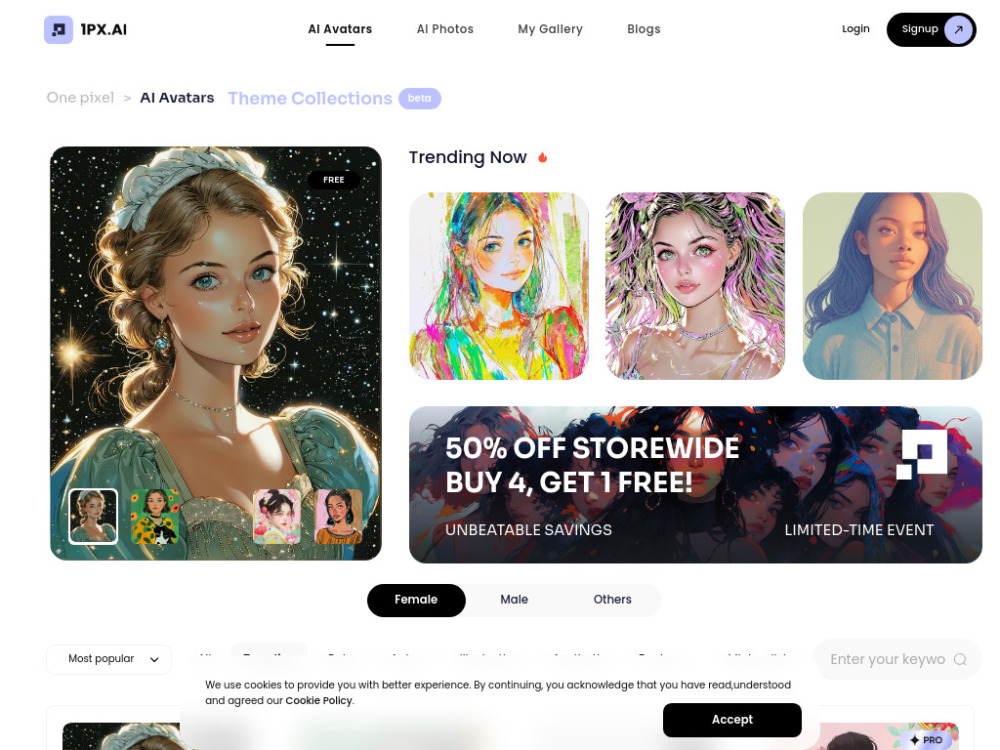

En los últimos años, los generadores de retratos con inteligencia artificial han revolucionado la forma en que creamos y experimentamos imágenes artísticas. Al aprovechar algoritmos avanzados y técnicas de aprendizaje automático, estas herramientas innovadoras pueden producir retratos digitales impactantes en cuestión de segundos. Ya seas un artista en busca de inspiración o simplemente curioso sobre las capacidades de la IA, entender cómo funcionan estos generadores puede abrir nuevas avenidas para la creatividad y la expresión. Esta guía explorará el fascinante mundo de los generadores de retratos con IA, analizando su tecnología, aplicaciones y el futuro del arte digital.

Presentamos un Motor de Respuestas Sin Publicidad: Tu Fuente de Información Clara y Objetiva

En un mundo abrumado por anuncios y distracciones de marketing, encontrar respuestas directas puede ser un desafío. Nuestro Motor de Respuestas Sin Publicidad ofrece una plataforma libre de desorden, brindando información precisa y confiable sin interrupciones ni contenido promocional. Sumérgete en una experiencia donde tu búsqueda de conocimiento es prioritaria, asegurando que obtengas los conocimientos que necesitas, cuando los necesitas. ¡Descubre claridad sin el ruido!

Find AI tools in YBX

Related Articles

Refresh Articles