Google lanza las versiones Flash y Pro de Gemini 1.5, con un límite de 2 millones de tokens para el acceso público.

Most people like

BgRem es una plataforma de IA avanzada diseñada para la creación y edición de imágenes y videos de manera fluida. Ya seas creador de contenido, comercializador o aficionado, BgRem optimiza tu flujo de trabajo, facilitándote la producción de visuales impresionantes con facilidad.

Desbloquea el poder de la IA con nuestro innovador copiloto de contenido, diseñado específicamente para profesionales de marketing y ventas. Al aprovechar algoritmos avanzados y análisis de datos, esta herramienta optimiza tu proceso de creación de contenido, mejora la interacción con la audiencia y aumenta las conversiones. Eleva tus estrategias de marketing y tácticas de ventas con la asistencia de IA de vanguardia que te permite crear mensajes atractivos y conectar con tu público objetivo de manera más eficaz que nunca. ¡Experimenta el futuro de la creación de contenido y observa cómo tu rendimiento se dispara!

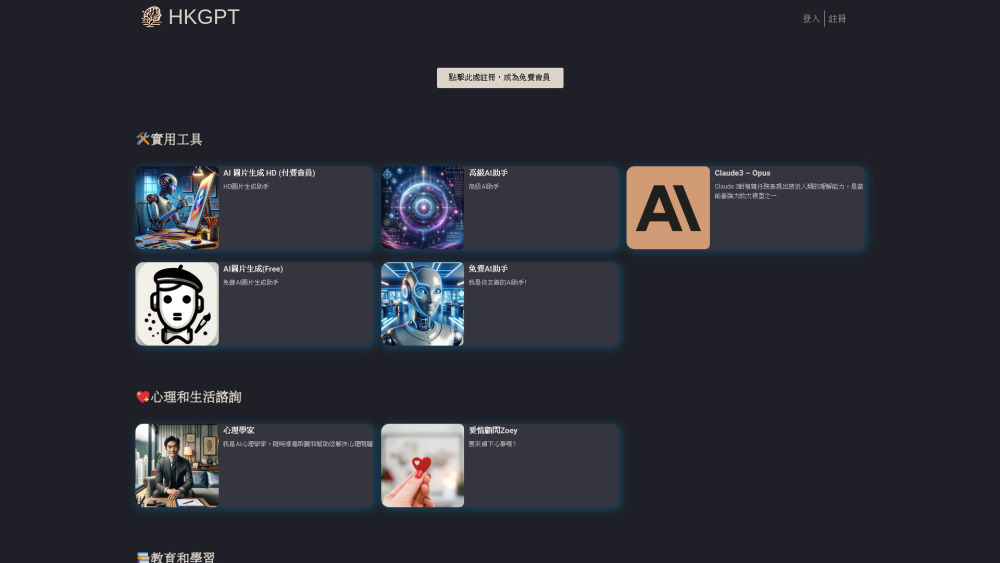

Bienvenido a nuestro completo sitio web de herramientas de IA, diseñado para atender a una amplia gama de industrias. Descubre soluciones innovadoras de inteligencia artificial que mejoran la productividad, optimizan operaciones y fomentan el crecimiento en diversos sectores. Únete a nosotros para explorar cómo la tecnología de IA de vanguardia puede elevar tu negocio a nuevas alturas.

Eleva tus interacciones con clientes mediante chatbots de IA personalizados, diseñados a partir de tus datos únicos. Estos asistentes virtuales inteligentes están creados para mejorar el compromiso y ofrecer experiencias personalizadas, asegurando que tu negocio se destaque en el panorama digital. Descubre el poder de los chatbots de IA específicamente entrenados para satisfacer tus necesidades.

Find AI tools in YBX