Importante Avance en el Proyecto LLaVA++: Mejora de las Capacidades Visuales de los Modelos Phi-3 y Llama-3

Most people like

Crea voces sintéticas realistas en solo segundos. Experimenta el poder de la tecnología de vanguardia que ofrece soluciones de audio realistas adaptadas a tus necesidades.

BotPenguin es un innovador chatbot de IA diseñado para optimizar el soporte al cliente y mejorar la interacción con los visitantes en las empresas. Al automatizar las interacciones, BotPenguin garantiza que tus clientes reciban asistencia rápida y eficiente, creando una experiencia fluida que aumenta la satisfacción y la retención.

En el panorama digital actual, recopilar y analizar datos de sitios web de manera eficiente es fundamental tanto para empresas como para investigadores. Un raspador web impulsado por inteligencia artificial automatiza este proceso, utilizando algoritmos avanzados y técnicas de aprendizaje automático para extraer información relevante de forma rápida y precisa. Esta tecnología innovadora no solo ahorra tiempo, sino que también mejora la calidad de los datos, convirtiéndose en una herramienta invaluable para la toma de decisiones basadas en datos. Ya sea que estés realizando un análisis competitivo, monitoreando tendencias del mercado o recolectando datos de investigación, los raspadores web de IA agilizan el proceso, ofreciendo una solución más inteligente para navegar la vasta extensión de internet.

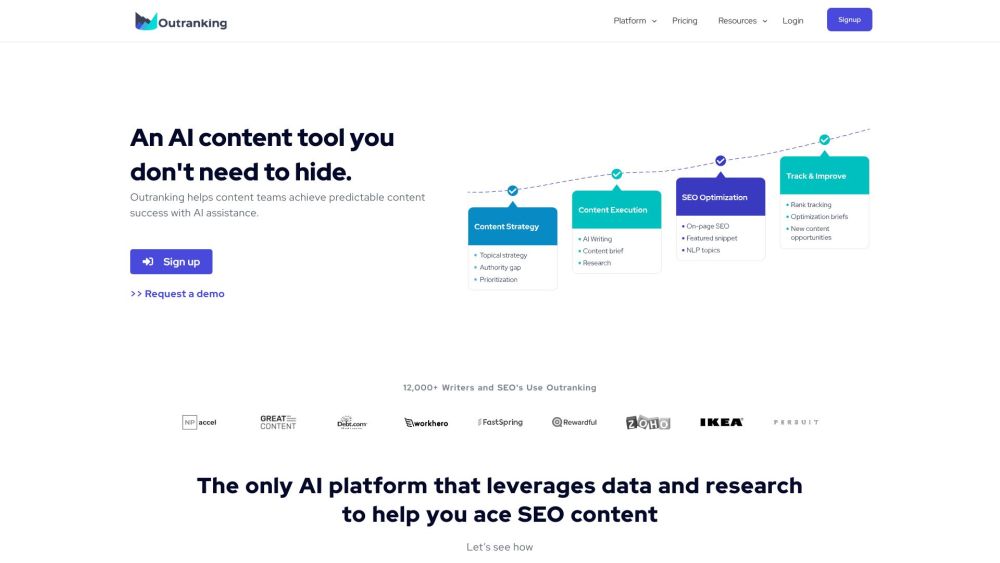

Outranking es un software de SEO avanzado impulsado por inteligencia artificial, diseñado para ayudar a las empresas a crear contenido de alta calidad que impulse el tráfico. Con sus herramientas innovadoras, Outranking simplifica el proceso de creación de contenido mientras mejora la visibilidad y el engagement en los resultados de los motores de búsqueda.

Find AI tools in YBX

Related Articles

Refresh Articles