Manifestantes se Reúnen Frente a la Oficina de OpenAI en Contra del Uso Militar de la IA y el Desarrollo de AGI

Most people like

Descubre las ventajas de los proveedores de la nube que ofrecen alquileres de GPU, ideales para una amplia gama de tareas de computación. Ya sea que necesites mayor potencia de procesamiento para aprendizaje automático, renderización de video o simulaciones complejas, el alquiler de GPU representa una solución flexible y rentable. Explora cómo estos servicios pueden elevar tus proyectos y fomentar la innovación en el panorama impulsado por datos de hoy.

Descubre una interfaz de chat de IA gratuita diseñada para la resolución avanzada de problemas. Esta herramienta innovadora simplifica tu proceso de pensamiento y te ayuda a abordar cuestiones complejas con facilidad. Ya sea que busques soluciones para proyectos personales, desafíos académicos o tareas profesionales, esta interfaz de chat es tu recurso esencial para apoyo eficiente y efectivo. Interactúa con tecnología de vanguardia para mejorar tu toma de decisiones y alcanzar tus objetivos.

Desbloquea el poder de la detección de IA a través de algoritmos de vanguardia. Descubre cómo estas sofisticadas tecnologías pueden mejorar la precisión y la eficiencia en la identificación de contenido generado por inteligencia artificial. Al aprovechar técnicas de última generación, empresas e investigadores pueden garantizar evaluaciones confiables y mejorar los procesos de toma de decisiones. ¡Sumérgete en el mundo de la detección avanzada de IA ahora!

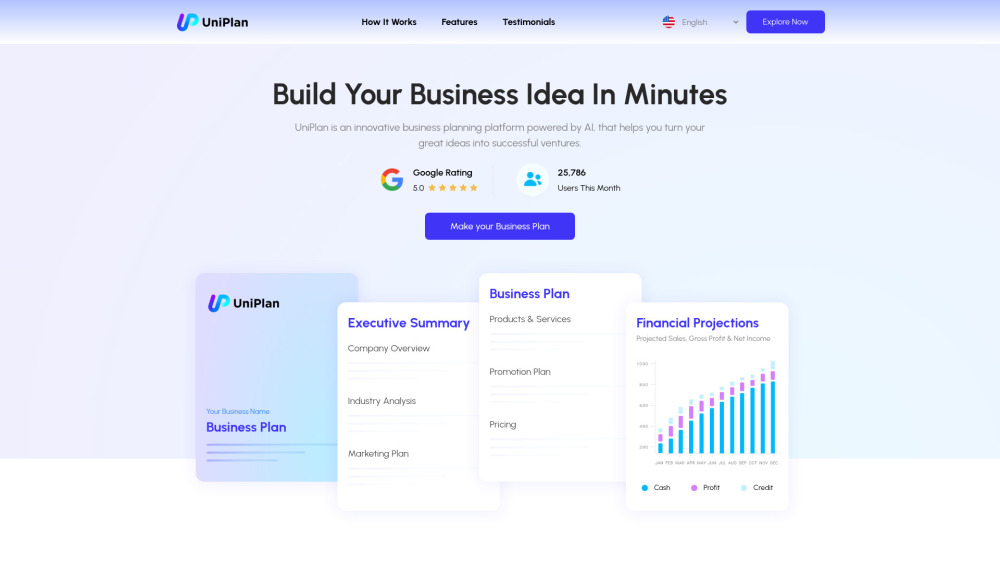

En el competitivo panorama actual, contar con un plan de negocio bien estructurado es crucial para el éxito. Nuestra plataforma impulsada por IA ofrece planes de negocio personalizados que satisfacen tus necesidades y objetivos únicos. Con algoritmos avanzados y conocimientos de expertos, garantizamos que cada plan no solo esté personalizado, sino también alineado estratégicamente con tu visión y demandas del mercado. Experimenta la comodidad y efectividad de nuestras soluciones de planificación personalizadas, diseñadas para emprendedores y empresas de todos los tamaños.

Find AI tools in YBX

Related Articles

Refresh Articles