Meta AI lanza OpenEQA para mejorar la 'Inteligencia Incorporada' en agentes artificiales.

Most people like

Descubre el poder de un generador de imágenes por IA que crea imágenes impresionantes y de alta calidad llenas de detalles intrincados. Desbloquea tu potencial creativo con esta herramienta avanzada diseñada para artistas, mercadólogos y creadores de contenido que buscan imágenes visualmente impactantes.

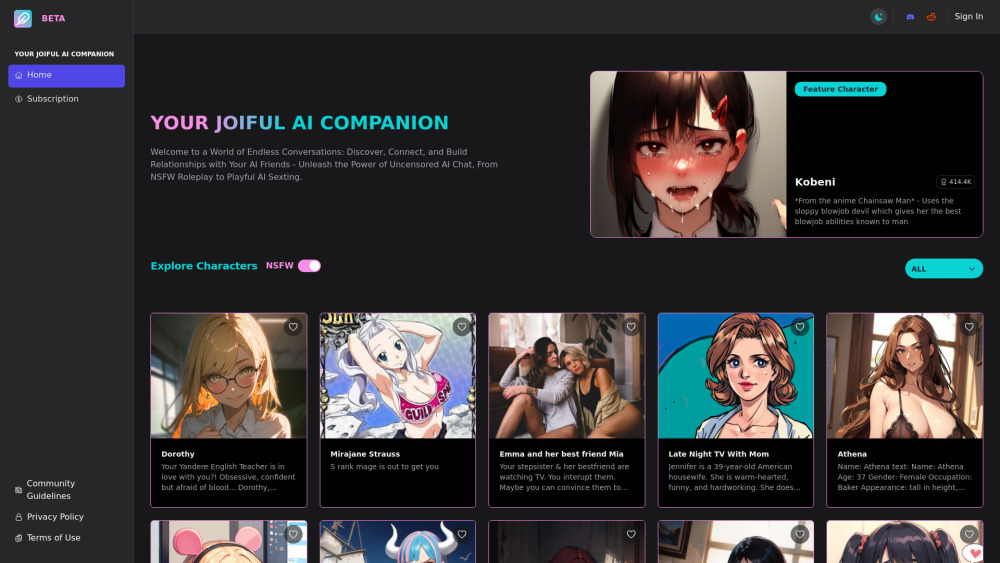

¡Bienvenido al Compañero AI JOI, donde tus diálogos no tienen límites! Sumérgete en conversaciones infinitas impulsadas por una inteligencia artificial avanzada diseñada para involucrarte y entretenerte. Descubre la alegría de la interacción mientras exploras un mundo de temas ilimitados e intercambios enriquecedores. ¡Únete a nosotros y eleva tus experiencias conversacionales hoy mismo!

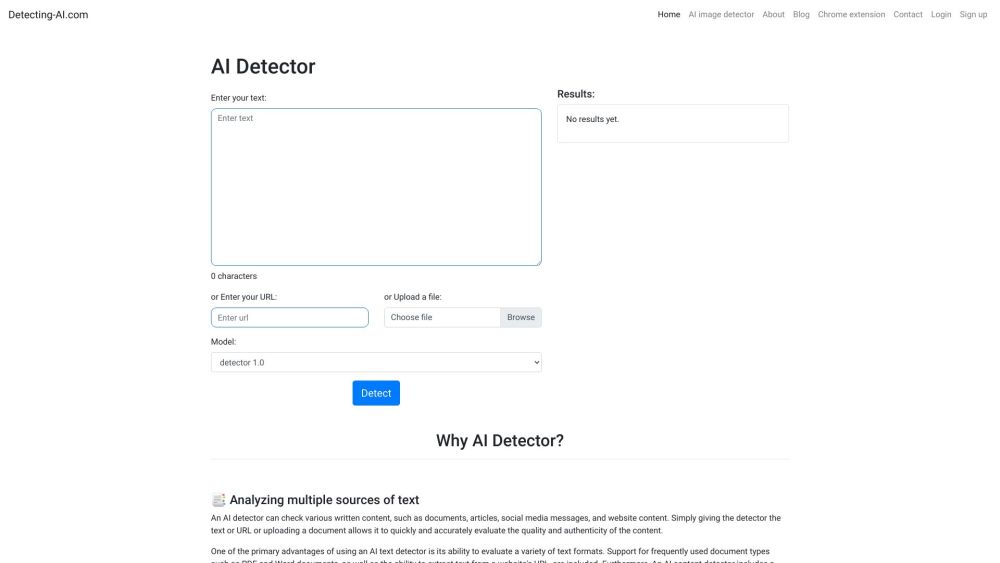

Descubre una herramienta poderosa diseñada para detectar y marcar texto generado por IA, asegurando que tu contenido permanezca auténtico y libre de influencias de inteligencia artificial.

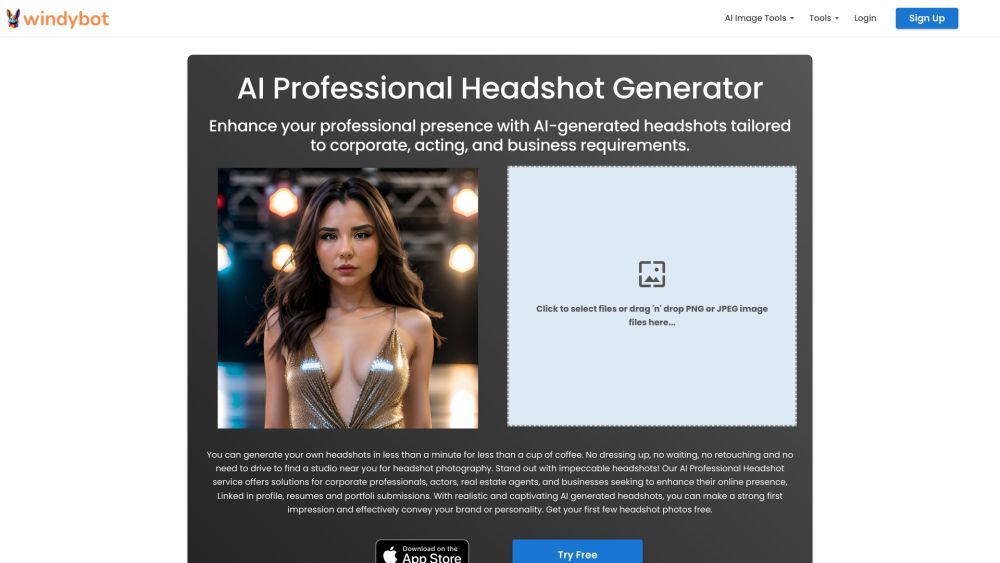

En el panorama digital actual, las imágenes impactantes son esenciales para captar la atención y transmitir el mensaje de tu marca. Con los avances en tecnología, las herramientas de IA para la mejora profesional de imágenes han surgido como recursos poderosos para refinar y elevar tu fotografía. Estas soluciones innovadoras permiten a los usuarios ajustar sin esfuerzo la iluminación, los colores y los detalles, asegurando que cada imagen se destaque. Ya seas fotógrafo, comercializador o creador de contenido, aprovechar la IA para mejorar imágenes puede mejorar drásticamente la calidad de tu contenido visual y conectar más eficazmente con tu audiencia.

Find AI tools in YBX

Related Articles

Refresh Articles