Mistral lanza Codestral Mamba: Acelerando y ampliando la velocidad de generación de código.

Most people like

Desbloquea tu potencial con una plataforma de IA para soluciones de exámenes y tareas sin esfuerzo a través de fotos.

Traduce Llamadas y Notas de Voz Usando tu Propia Voz: Activa una Comunicación Sin Interrupciones

Experimenta el poder de traducir llamadas y notas de voz sin esfuerzo con tu propia voz. Esta herramienta innovadora te permite mantener tu tono y estilo únicos mientras superas las barreras del idioma, haciendo que la comunicación sea más fluida y auténtica. ¡Descubre lo fácil que es mejorar tus interacciones hoy!

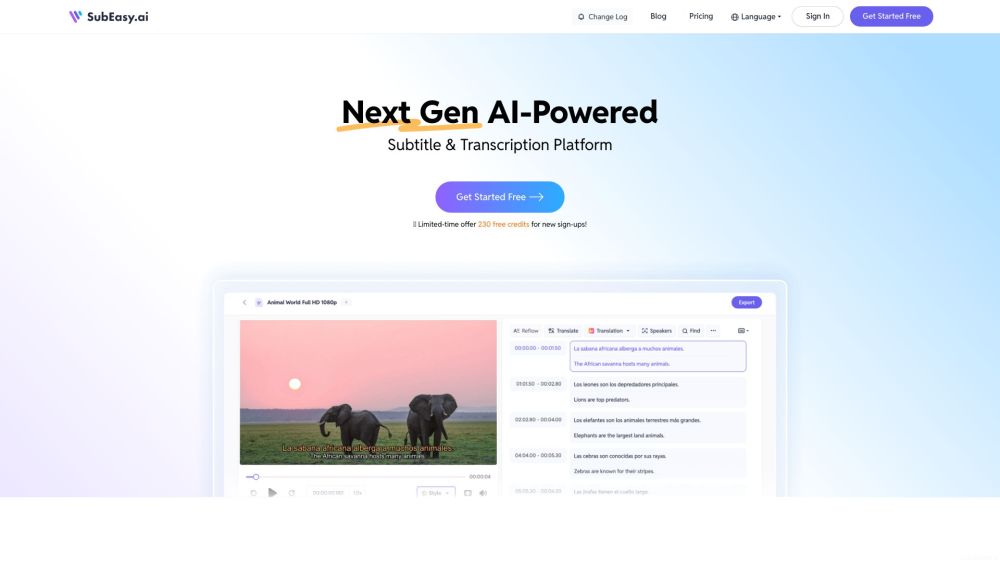

Transcripción y traducción de subtítulos impulsada por IA: Mejora tu contenido con tecnología avanzada

En el panorama digital actual, la comunicación clara y accesible es fundamental. La transcripción y traducción de subtítulos impulsada por IA optimiza tu contenido de video, haciéndolo más atractivo e inclusivo para audiencias globales. Al aprovechar el poder de la inteligencia artificial, puedes asegurar subtítulos precisos y oportunos mientras alcanzas a diversos espectadores sin esfuerzo. Descubre cómo la tecnología de IA puede elevar tu producción de video y ampliar tu alcance de audiencia.

Desbloquea Tu Potencial con Preparación y Retroalimentación para Entrevistas Impulsadas por IA

¿Estás listo para destacar en tu próxima entrevista de trabajo? Nuestra plataforma impulsada por IA ofrece preparación personalizada para entrevistas y retroalimentación valiosa que aumentará tu confianza y mejorará tu rendimiento. Al aprovechar tecnología de vanguardia, te ayudamos a perfeccionar tus respuestas y desarrollar habilidades clave para sobresalir en mercados laborales competitivos. Ya seas un recién graduado o un profesional experimentado, nuestras herramientas te preparan para triunfar en cualquier situación de entrevista. ¡Aumenta tus posibilidades de conseguir el trabajo de tus sueños hoy mismo!

Find AI tools in YBX

Related Articles

Refresh Articles