OpenAI Lanza Capacitación para el Modelo de Nueva Generación — Se Espera que GPT-5 Esté Disponible en Más de 90 Días

Most people like

Descubre Araby.ai, tu fuente principal de herramientas avanzadas de IA en árabe diseñadas para impulsar múltiples industrias. Experimenta el futuro de la tecnología con nuestras soluciones innovadoras adaptadas para usuarios de habla árabe.

En el vertiginoso panorama digital actual, la inteligencia artificial (IA) está redefiniendo nuestra manera de conectar y crear. Al potenciar la intimidad digital, las herramientas de IA fomentan relaciones más profundas y facilitan interacciones significativas en diversas plataformas. Al mismo tiempo, estas innovaciones permiten a los usuarios crear contenido visual impactante que cautiva a las audiencias. Descubre cómo la IA está transformando tanto las conexiones personales como la expresión creativa en el ámbito digital.

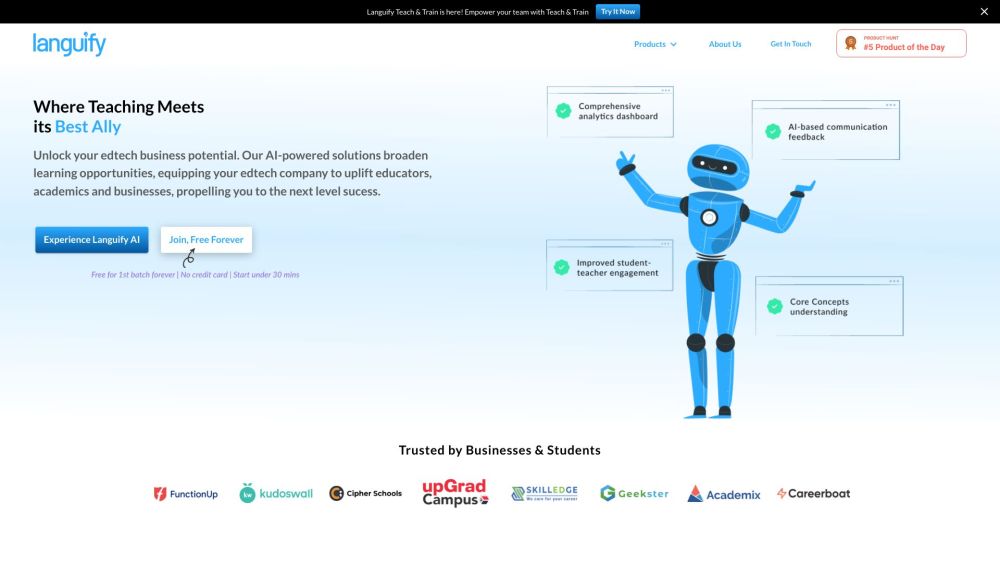

Presentamos un compañero de aprendizaje de IA diseñado para mejorar las interacciones educativas personalizadas. Esta tecnología innovadora adapta la experiencia de aprendizaje a las necesidades individuales, fomentando el compromiso y mejorando los resultados educativos. Ya seas un estudiante que busca apoyo o un educador que desea ofrecer instrucción personalizada, nuestro compañero de aprendizaje de IA está aquí para transformar la forma en que aprendes y enseñas.

Descubre la herramienta de IA definitiva diseñada para crear cómics y manga impresionantes sin esfuerzo. Perfecta para artistas y narradores, esta innovadora plataforma simplifica el proceso de creación de cómics, permitiéndote dar vida a tus visiones creativas con facilidad. Libera tu imaginación y elabora visuales cautivadores que atrapen a los lectores, todo con el poder de la IA al alcance de tu mano.

Find AI tools in YBX