OpenAI y Anthropic colaboran para compartir modelos de inteligencia artificial con el Instituto de Seguridad de IA de EE. UU. con el fin de mejorar la seguridad y la supervisión.

Most people like

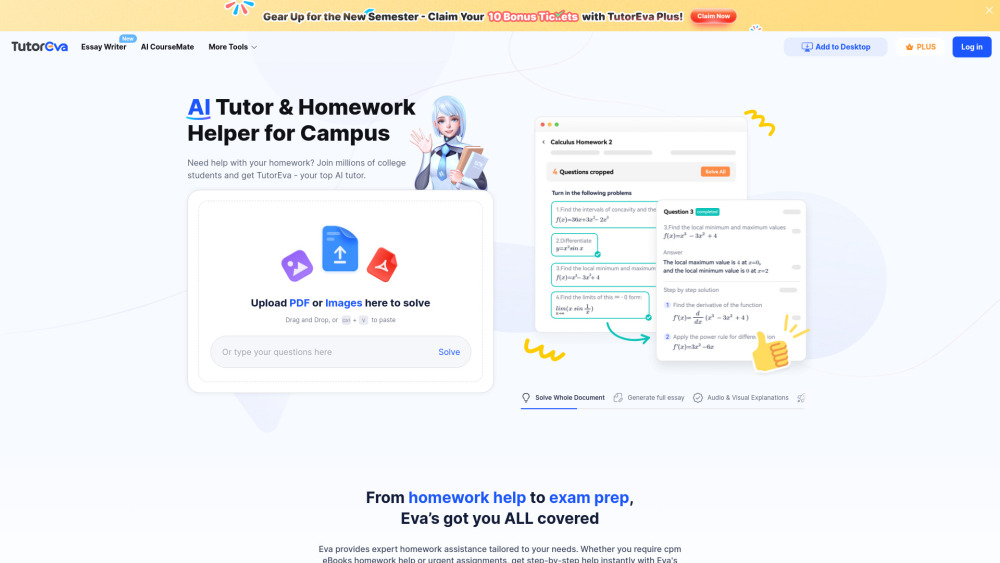

Presentamos el asistente de tareas y tutor de IA diseñado específicamente para materias universitarias. Mejora tu experiencia de aprendizaje con apoyo personalizado que simplifica temas complejos y aumenta tu rendimiento académico. Ya sea que necesites ayuda con escritura, investigación o orientación específica de la materia, nuestra plataforma impulsada por IA está aquí para ayudarte a tener éxito.

Desbloquea el poder de los insights con nuestra herramienta de análisis de texto AI gratuita. Descubre cómo este software innovador puede ayudarte a examinar, interpretar y mejorar tu texto sin esfuerzo para obtener mejores resultados. Ya seas estudiante, profesional o investigador, nuestra herramienta simplifica el proceso de análisis de texto, haciéndolo accesible y fácil de usar para todos. ¡Comienza a transformar tu contenido escrito hoy mismo!

En el mundo visual actual, la demanda de imágenes de alta calidad nunca ha sido tan grande. Presentamos la herramienta de expansión de fotos mediante IA: una tecnología innovadora que mejora y amplía tus imágenes manteniendo un impresionante detalle y claridad. Ya sea que necesites mejorar una foto personal o perfeccionar imágenes para uso profesional, esta herramienta transformadora utiliza algoritmos avanzados de inteligencia artificial para ofrecer resultados impresionantes. Descubre cómo la herramienta de expansión de fotos mediante IA está revolucionando la forma en que creamos y compartimos contenido visual, facilitando más que nunca la elevación de tus imágenes a nuevas alturas.

Find AI tools in YBX

Related Articles

Refresh Articles