RAGChecker de Amazon: Un Revolucionario para la IA, Pero Aún No Disponible

Most people like

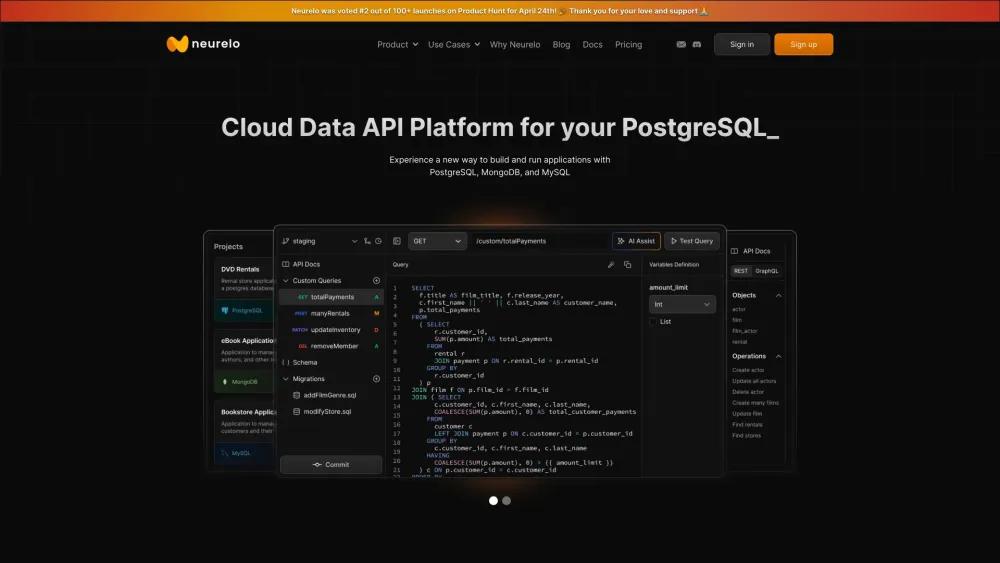

En el mundo actual impulsado por los datos, las API de bases de datos potenciadas por IA están revolucionando la forma en que las empresas interactúan y gestionan su información. Aprovechando la inteligencia artificial, estas API agilizan la recuperación de datos, mejoran la precisión y facilitan procesos de toma de decisiones más inteligentes. Ideales tanto para desarrolladores como para empresas, las API de bases de datos impulsadas por IA no solo optimizan el rendimiento, sino que también fomentan la innovación al permitir que las organizaciones aprovechen todo el potencial de sus datos. Descubre el impacto transformador de las API de bases de datos potenciadas por IA y cómo pueden elevar tus estrategias de gestión de datos.

Presentamos Gamma.AI: una solución avanzada impulsada por inteligencia artificial, diseñada para monitorear las actividades de los empleados y alertarlo de inmediato sobre errores de seguridad. Con su tecnología de vanguardia, Gamma.AI ayuda a proteger su organización al garantizar el cumplimiento y minimizar riesgos.

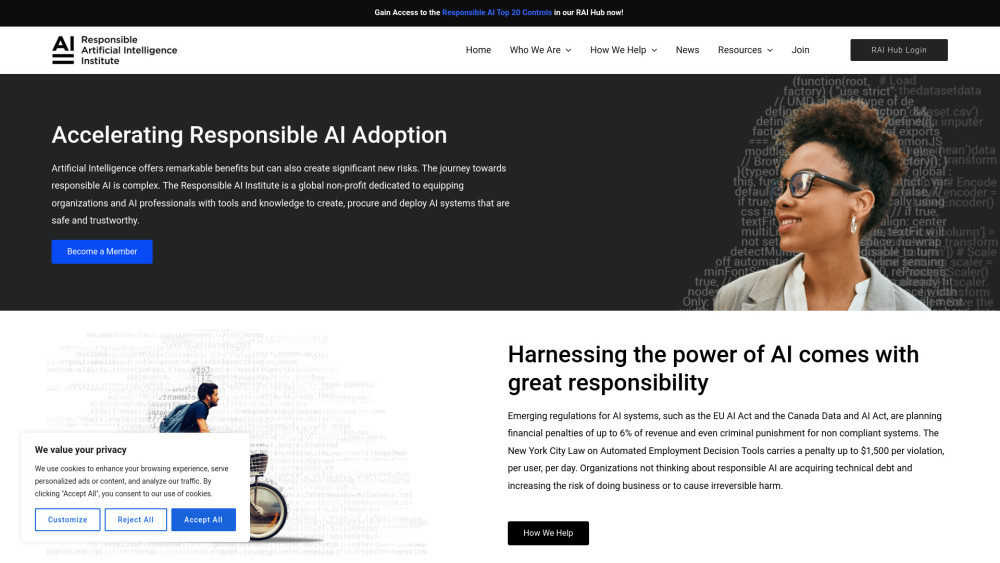

En una era donde la inteligencia artificial está evolucionando rápidamente, garantizar su desarrollo seguro y ético se ha vuelto fundamental. Esta organización global sin fines de lucro se dedica a promover iniciativas y directrices que fomentan prácticas responsables de IA. Al unir a expertos, partes interesadas y defensores de todo el mundo, nuestro objetivo es crear un futuro sostenible donde la IA beneficie a toda la humanidad. Nuestra misión enfatiza la colaboración, la transparencia y la seguridad en la tecnología de IA, estableciendo las bases para soluciones innovadoras que priorizan el bienestar de la sociedad. Únete a nosotros para dar forma a un paisaje de IA responsable para el mañana.

Find AI tools in YBX

Related Articles

Refresh Articles