GPT-4o: 最新のChatGPTアップデートの新機能とリリース日を徹底解説

Most people like

100以上の言語に対応した強力な無料翻訳ツールを発見し、誰もがどこでもコミュニケーションを円滑に行えるようにします。旅行中、学習中、または世界中の友人とつながるとき、このツールを使えば言語の壁を簡単に突破できます。

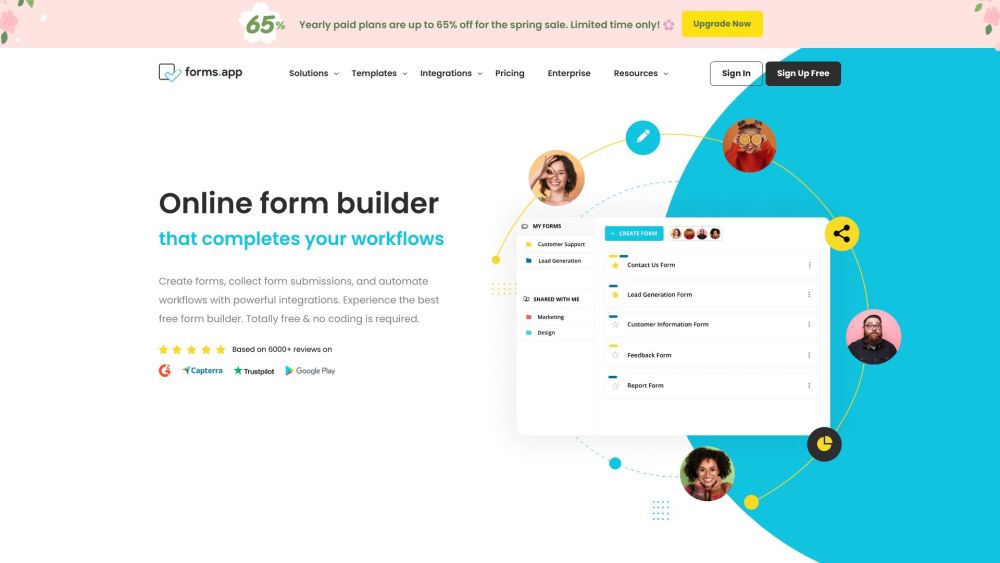

オンラインフォームを手頃な価格で簡単に作成できる効果的なソリューションをお探しですか?これ以上探す必要はありません!本ガイドでは、利用可能な最良の無料オンラインフォームビルダーを探求し、あなたの要件に合った完璧なツールを選ぶお手伝いをします。フィードバックを収集したり、参加者を登録したり、研究のためのデータを集めたりする場合でも、これらの高評価のプラットフォームはあなたのプロセスを合理化し、効率を向上させます。あなたのニーズに完璧に合った理想的なフォームビルダーを見つけるために、ぜひご覧ください!

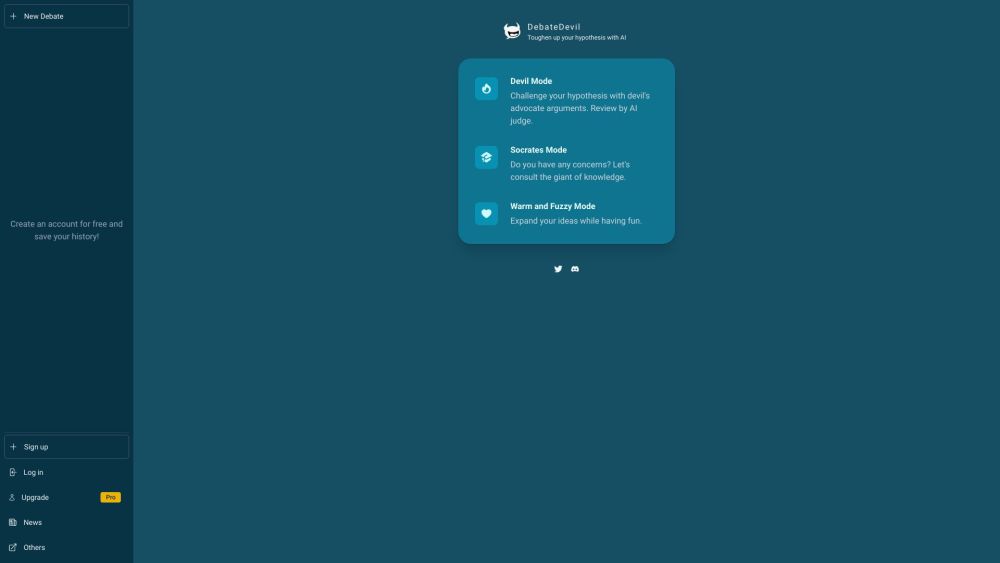

AIチャットボットを活用して、反論を提示したり、鋭い質問を投げかけたり、幅広いアイデアの探求を支援することで、クリティカルシンキングスキルを向上させましょう。これらの知的なツールがどのようにあなたの視点を挑戦し、論理的思考能力を高めるかを体験してください。

Find AI tools in YBX

Related Articles

Refresh Articles