MIT専門家が強化されたAIガバナンスと規制の必要性を訴え

Most people like

あなたの創造的な可能性を引き出す動画制作プラットフォームで、コンテンツを高めるための強力なツールをご利用ください。経験豊富なクリエイターでも、始めたばかりの方でも、使いやすいインターフェースと高度な編集機能により、驚くほど素晴らしい動画を簡単に作成できます。革新者たちのコミュニティに参加し、今日からあなたのビジョンを実現しましょう!

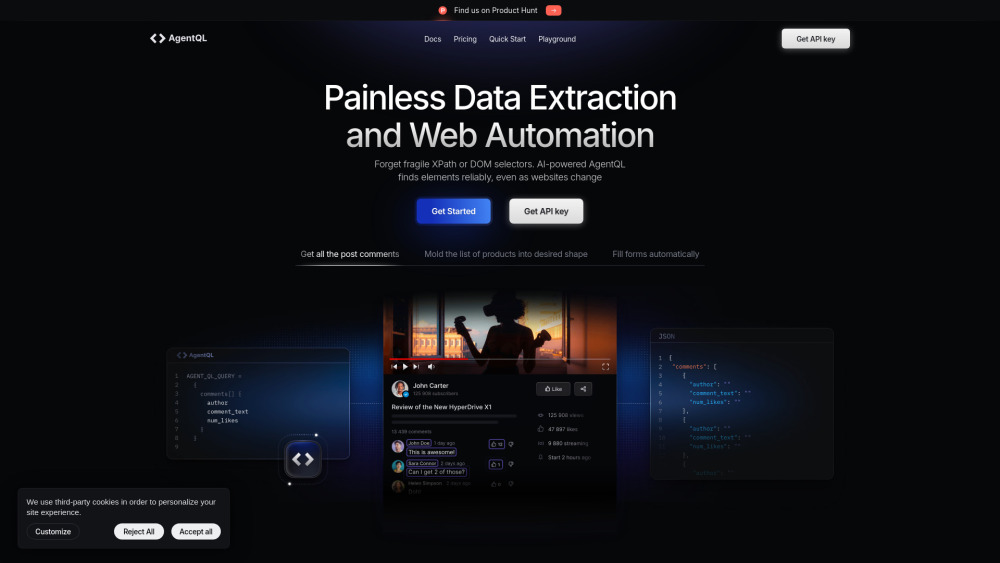

AI駆動のウェブ自動化およびデータ抽出プラットフォームを紹介します。オンラインプロセスの効率化を目的とした最先端のソリューションです。人工知能を活用して様々なウェブサイトからデータを効率的に収集し、企業が繰り返しの作業を自動化し、生産性を向上させることを可能にします。私たちのプラットフォームがどのようにあなたの業務を革新し、ウェブから貴重なインサイトを容易に引き出すことができるか探求してみてください。

Find AI tools in YBX

Related Articles

Refresh Articles