마이크로소프트, Bing에서 복수 및 딥페이크 포르노 근절 위해 Coalition과 파트너십 체결

Most people like

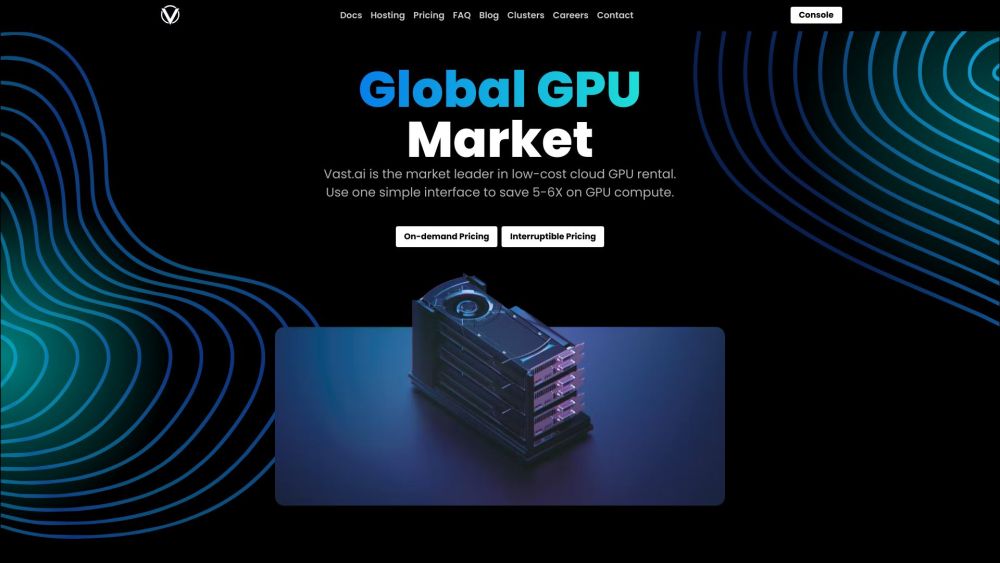

최적의 성능을 위한 저렴한 클라우드 GPU 렌탈 플랫폼

오늘날 디지털 환경에서 고성능 컴퓨팅 자원에 대한 수요가 급증하고 있으며, 클라우드 GPU 렌탈은 기업과 개발자에게 매력적인 선택이 되고 있습니다. 저희 플랫폼은 강력한 GPU 기능에 접근할 수 있는 경제적인 솔루션을 제공하여, 전통적인 하드웨어에서 일반적으로 수반되는 높은 비용 없이 프로젝트를 향상시킬 수 있도록 도와줍니다. 귀하의 특정 요구에 맞춰 설계된 저렴한 클라우드 GPU 렌탈을 통해 원활한 확장성과 유연성을 경험하며 생산성을 높이세요.

한 번의 클릭으로 당신의 아이디어를 매력적인 비주얼 스토리로 변환하세요. 이 강력한 스크립트를 통해 청중을 사로잡고 콘텐츠를 향상시키는 흥미로운 내러티브를 손쉽게 만들어낼 수 있습니다. 복잡한 스토리텔링은 이제 그만—이제 당신의 비전을 즉시 현실로 만들 수 있습니다!

Find AI tools in YBX