Google이 Gemma 2 시리즈를 출시했습니다: 단일 TPU에서 실행 가능한 270억 개 파라미터 모델을 소개합니다.

Most people like

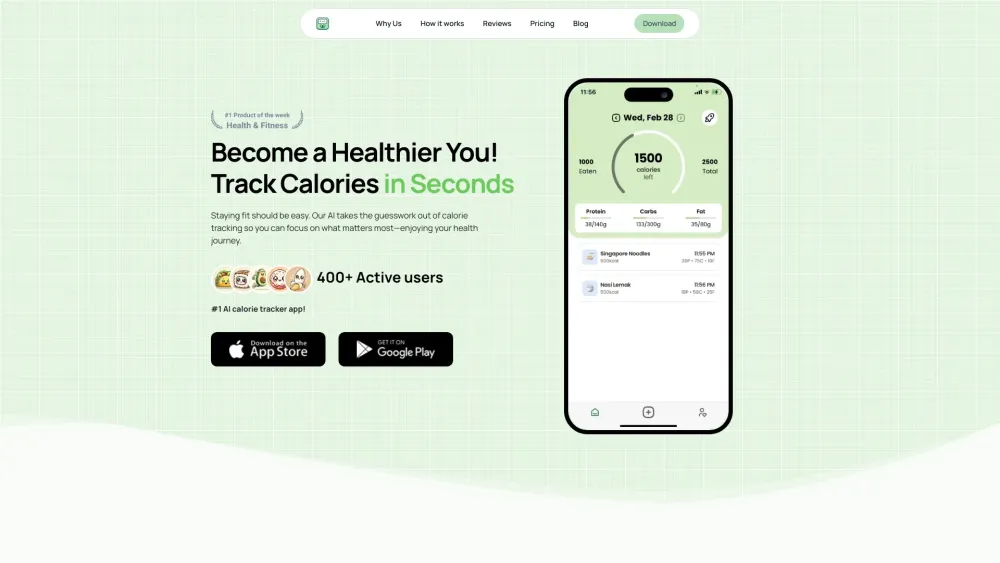

AI로 간편한 칼로리 추적: 건강 여정을 간소화하다

인공지능으로 지원되는 원활한 칼로리 추적의 편리함을 경험해 보세요. 우리의 혁신적인 접근 방식은 당신의 식단 섭취를 손쉽게 모니터링할 수 있게 도와주며, 더 건강한 라이프스타일을 위한 정보에 기반한 선택을 가능하게 합니다. 이 기술을 활용하여 손쉽고 정확하게 피트니스 목표를 달성해 보세요.

온라인 AI 얼굴 바꾸기를 통해 당신의 사진을 간단히 업로드 하고 놀라운 변화를 체험하세요! 최첨단 기술로 얼굴을 손쉽게 바꾸고, 매끄럽게 이미지를 변환해보세요. AI 얼굴 바꾸기의 매혹적인 세계에 빠져들고 몇 번의 클릭만으로 무한한 창의적 가능성을 발견해 보세요.

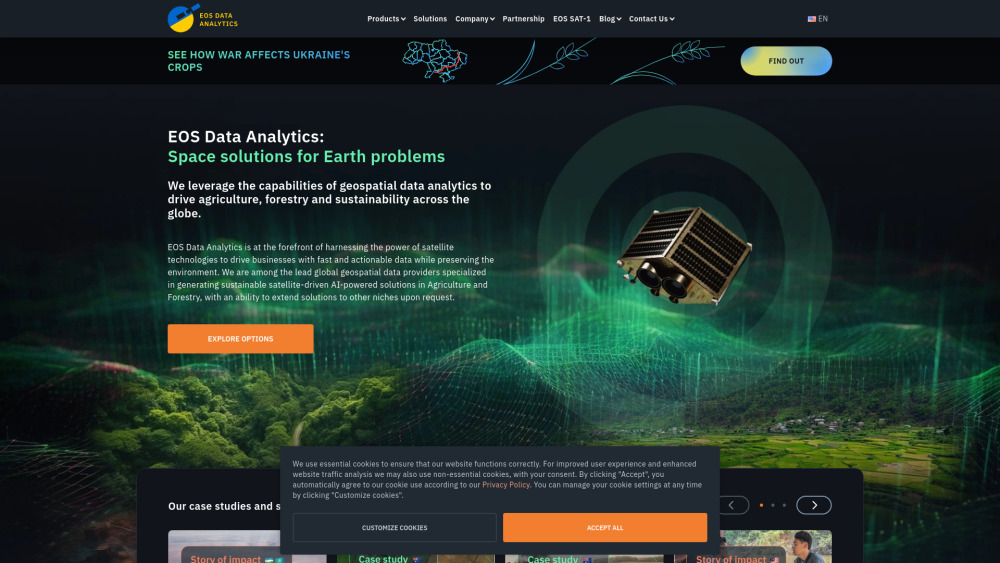

지구 관측의 판도를 혁신하는 우리는 AI 기반 위성 이미지 분석의 글로벌 리더입니다. 우리의 최첨단 기술은 원시 위성 데이터를 의미 있는 통찰로 변환하여 기업과 조직이 정보에 기반한 결정을 내릴 수 있도록 지원합니다. 우리의 혁신적인 솔루션이 지구에 대한 이해를 높이고 자원을 최적화하며 지속 가능한 성장을 이끌 수 있는 방법을 발견해 보십시오.

Find AI tools in YBX

Related Articles

Refresh Articles