생성형 AI 위험 경감을 위한 AI 프레임워크: Applied Intelligence Live! Austin 2023에서의 통찰력

Most people like

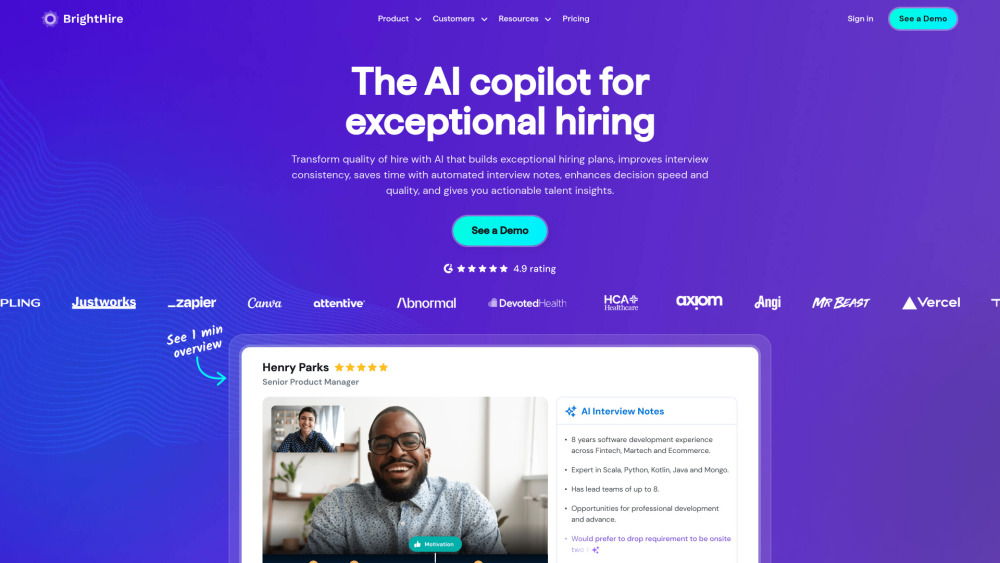

AI 인터뷰 인텔리전스를 활용하여 채용 경험을 혁신하세요. 고급 알고리즘과 데이터 분석을 통합한 이 혁신적인 접근 방식은 후보자 평가를 간소화하고, 의사 결정을 향상시키며, 채용 과정을 가속화합니다. 오늘날 AI 기반 인사이트로 채용 전략을 전환하여 더 나은 인재 확보와 조직 적합성을 이끌어내십시오.

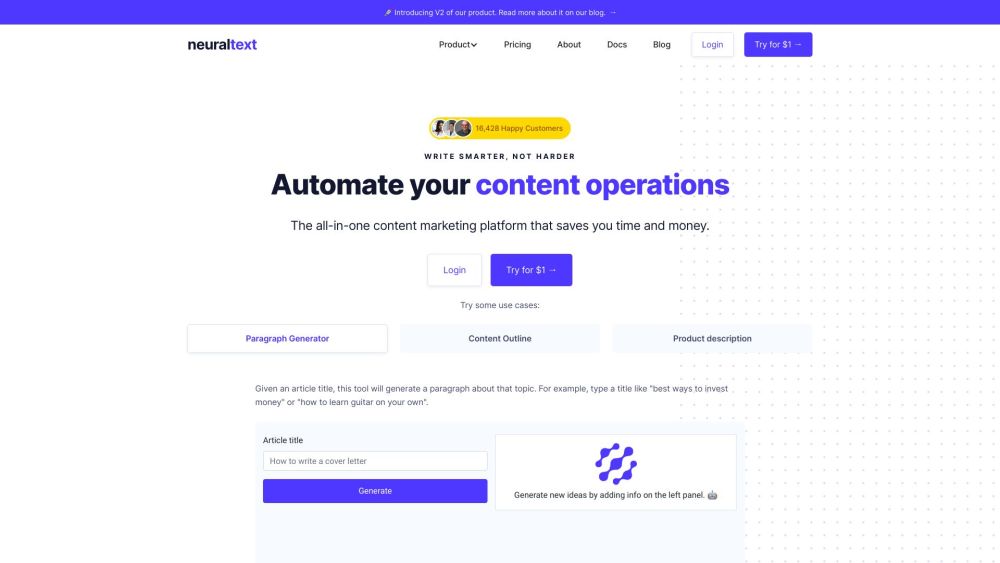

디지털 시대에 고품질 콘텐츠를 생성하는 것은 온라인 가시성과 참여에 필수적입니다. AI 글쓰기 도구와 SEO 도구는 우리가 텍스트를 생산하는 방식을 혁신하고 있으며, 청중과 공감할 수 있는 매력적인 서사를 쉽게 작성할 수 있도록 도와줍니다. 이러한 첨단 기술은 글쓰기 효율성을 높일 뿐만 아니라 검색 엔진에 최적화된 콘텐츠를 생성하여 당신의 작업이 목표 청중에게 도달하도록 보장합니다. AI와 SEO의 힘을 활용함으로써 작가들은 콘텐츠 전략을 향상시키고 검색 순위를 개선하며 궁극적으로 웹사이트로 더 많은 트래픽을 유도할 수 있습니다. 이러한 혁신적인 도구가 당신의 글쓰기 과정을 어떻게 변화시키고 온라인 존재감을 확대할 수 있는지 탐구해보세요.

Find AI tools in YBX

Related Articles

Refresh Articles