챗봇 허위정보 대응: 구글 딥마인드와 스탠포드 대학, AI 사실 확인 도구 출시

Most people like

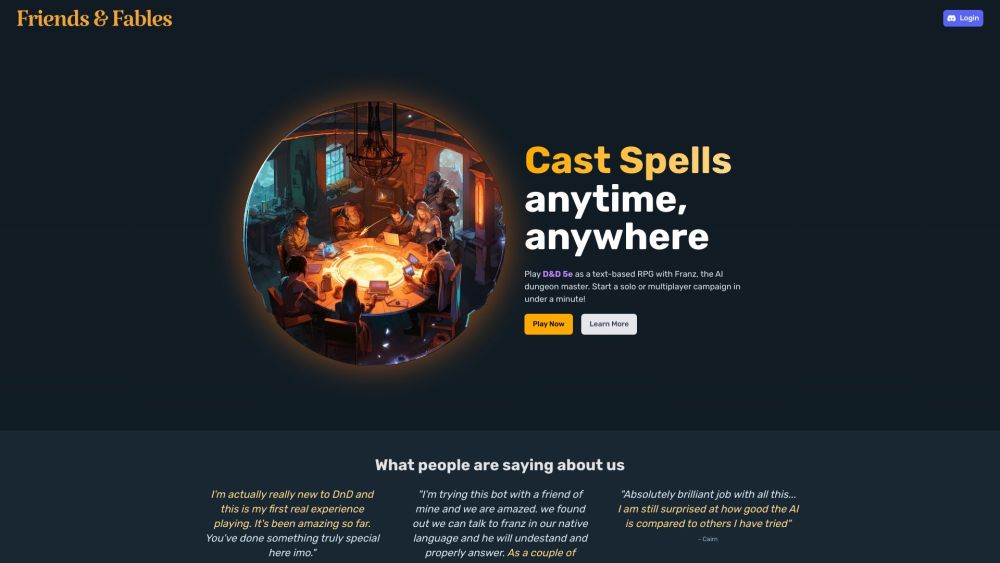

AI 던전 마스터와 함께 D&D 5e를 전혀 새로운 방식으로 경험하세요. 혼자서의 모험을 즐기거나 다인용 캠페인에 참여할 수 있으며, 언제 어디서나 편리하게 가능합니다. AI의 힘으로 테이블탑 게임의 무한한 가능성을 발견해 보세요!

Find AI tools in YBX

Related Articles

Refresh Articles