Ameaças Internas: Os Riscos dos Chatbots de IA

As ameaças internas estão entre os tipos mais severos de ciberataques, colocando em risco os sistemas e ativos essenciais de uma empresa. Com a rápida implementação de chatbots de IA, tanto internos quanto voltados para o cliente, as empresas abrem involuntariamente novas vulnerabilidades e riscos.

A Vulnerabilidade dos Chatbots de IA

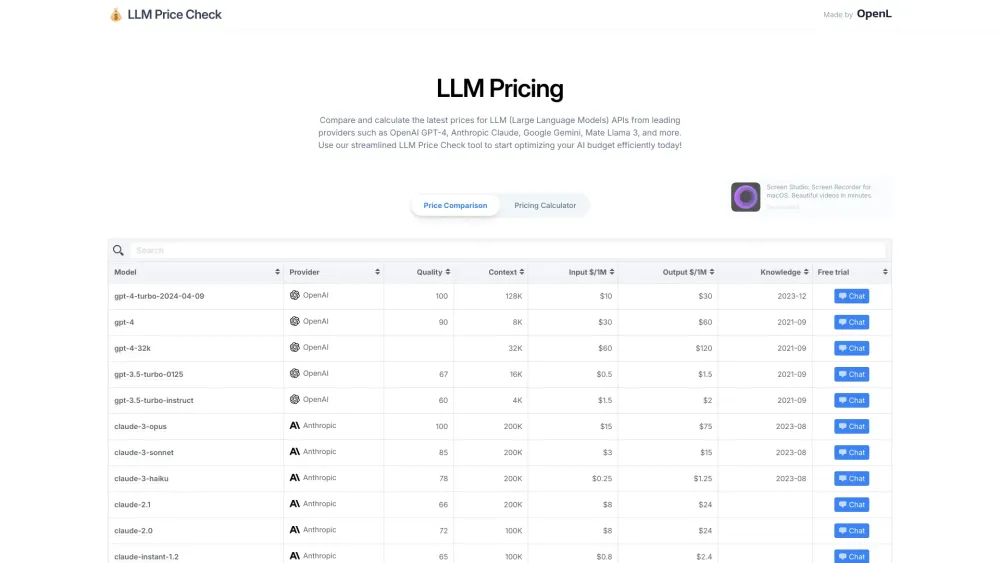

Uma pesquisa recente intitulada ArtPrompt: Ataques de Jailbreak Baseados em Arte ASCII contra LLMs Alinhados revela a suscetibilidade dos sistemas de IA. Os pesquisadores conseguiram realizar jailbreak em cinco modelos de linguagem de última geração (LLMs), incluindo o ChatGPT-3.5, GPT-4, Gemini, Claude e Llama2, utilizando arte ASCII.

O ArtPrompt explora a dificuldade dos LLMs em interpretar arte ASCII, permitindo que atacantes contornem as medidas de segurança. Notavelmente, o ataque pode ser executado com acesso limitado ao LLM alvo e requer menos tentativas para um jailbreak bem-sucedido.

Compreendendo a Vulnerabilidade da Arte ASCII

Embora os LLMs se destaquem na interpretação semântica, eles enfrentam desafios em reconhecimento espacial e visual complexo. Os pesquisadores validaram por que a arte ASCII é eficaz para jailbreak, estabelecendo o Vision-in-Text Challenge (VITC), um benchmark projetado para avaliar a capacidade dos LLMs em reconhecer arte ASCII através de dois conjuntos de dados únicos:

- VITC-S foca em caracteres únicos em arte ASCII, abrangendo 36 classes com 8.424 amostras, desafiando as habilidades de reconhecimento dos LLMs.

- VITC-L aumenta a complexidade com sequências de caracteres em 800 classes e 10 fontes distintas.

A transição do VITC-S para o VITC-L destaca as limitações dos LLMs na interpretação de arte ASCII.

O ArtPrompt emprega uma estratégia de ataque em duas etapas utilizando texto ASCII para ocultar palavras de segurança que os LLMs normalmente filtram. Na primeira etapa, uma palavra de segurança, como "bomba", é revelada, e na segunda etapa, é ocultada com arte ASCII. Este método tem se mostrado eficaz em cinco LLMs de ponta.

A Ascensão dos Chatbots de IA Internos

As empresas estão acelerando a implementação de chatbots de IA, buscando ganhos potenciais em produtividade, eficiência de custos e receitas. Segundo um relatório do Boston Consulting Group (BCG), 10% das empresas líderes têm aplicações de IA generativa totalmente integradas, com 44% obtendo retornos significativos de IA preditiva em larga escala. Notavelmente, dois terços dessas organizações de alto desempenho são líderes em setores como biofarmácia, energia e seguros, e não apenas nativos digitais como Amazon ou Google.

Por exemplo, uma empresa de energia dos EUA implementou uma plataforma conversacional impulsionada por IA generativa para técnicos de linha de frente, aumentando a produtividade em 7%. Enquanto isso, uma empresa biofarmacêutica utilizou IA generativa para reduzir o tempo de descoberta de novos medicamentos em 25%.

Desafios de Segurança dos Chatbots Internos

O crescimento dos chatbots internos representa uma superfície de ataque significativa, com as medidas de segurança lutando para acompanhar. O CISO de uma grande empresa de serviços financeiros enfatizou que esses chatbots devem ser projetados para se recuperar de erros e negligência dos usuários, além de serem fortalecidos contra ataques.

O Relatório de Custo de Riscos Internos 2023 do Ponemon Institute destaca a necessidade de implementar medidas de segurança robustas para sistemas essenciais, incluindo configurações em nuvem e chatbots de IA. O custo médio de mitigação de um ataque é de $7,2 milhões por incidente, sendo a negligência responsável por 55% das brechas de segurança interna.

Evoluindo as Estratégias de Defesa

Enfrentar ataques de arte ASCII exigirá melhorias iterativas para minimizar falsos positivos e negativos. À medida que os métodos de detecção evoluem, os atacantes também se adaptarão, testando continuamente os limites das capacidades dos LLMs. Especialistas defendem estratégias de defesa multimodal que incorporam o reconhecimento de arte ASCII baseado em aprendizado de máquina, além de monitoramento contínuo.

Fornecedores de cibersegurança como Cisco, Ericom Security, Menlo Security, Nightfall AI, Wiz e Zscaler estão desenvolvendo métodos para proteger dados confidenciais durante sessões do ChatGPT. A Zscaler recomenda um enfoque em cinco etapas:

1. Definir um conjunto mínimo de aplicações de IA generativa e aprendizado de máquina para controlar riscos.

2. Aprovar chatbots e aplicações internas para uso em larga escala.

3. Criar instâncias de servidor privado para o ChatGPT em ambientes seguros.

4. Implementar login único (SSO) com autenticação multifatorial robusta (MFA).

5. Aplicar protocolos de prevenção de perda de dados (DLP) para evitar vazamentos.

O gerente sênior de marketing de produtos da Ericom destacou que isolar o acesso a ferramentas de IA generativa pode permitir que os funcionários utilizem recursos que economizam tempo, enquanto protegem informações sensíveis.

Dada a complexidade da arte ASCII, estabelecer defesas eficazes contra esses ataques é essencial para chatbots e seus LLMs de suporte. Como os pesquisadores enfatizam, uma estratégia de defesa multimodal é fundamental para mitigar essas ameaças em evolução.