A Técnica Inovadora do Google Proporciona Compreensão Contextual Ilimitada para LLMs

Most people like

Apresentamos um modelo de linguagem de ponta projetado para uma geração de texto excepcional. Esta ferramenta poderosa utiliza tecnologia de IA avançada para produzir conteúdo escrito de alta qualidade sob medida para suas necessidades. Seja na criação de artigos envolventes, textos de marketing impactantes ou relatórios perspicazes, nosso modelo de última geração oferece resultados que cativam e informam. Desbloqueie o potencial da escrita impulsionada por IA hoje mesmo!

No panorama digital em rápida evolução de hoje, a interseção entre inteligência artificial (IA) e experiências imersivas está cativando um público cada vez maior. À medida que a tecnologia avança, a comunidade de IA está aproveitando ferramentas inovadoras para transformar a maneira como interagimos com nosso ambiente, aprimorando tanto o entretenimento quanto o aprendizado. Explorar essa fusão dinâmica não apenas destaca o potencial da IA, mas também revela seu papel na criação de experiências envolventes e imersivas que ressoam com os usuários. Junte-se a nós enquanto exploramos as maneiras pelas quais a IA está revolucionando nossa compreensão e interação com o mundo ao nosso redor.

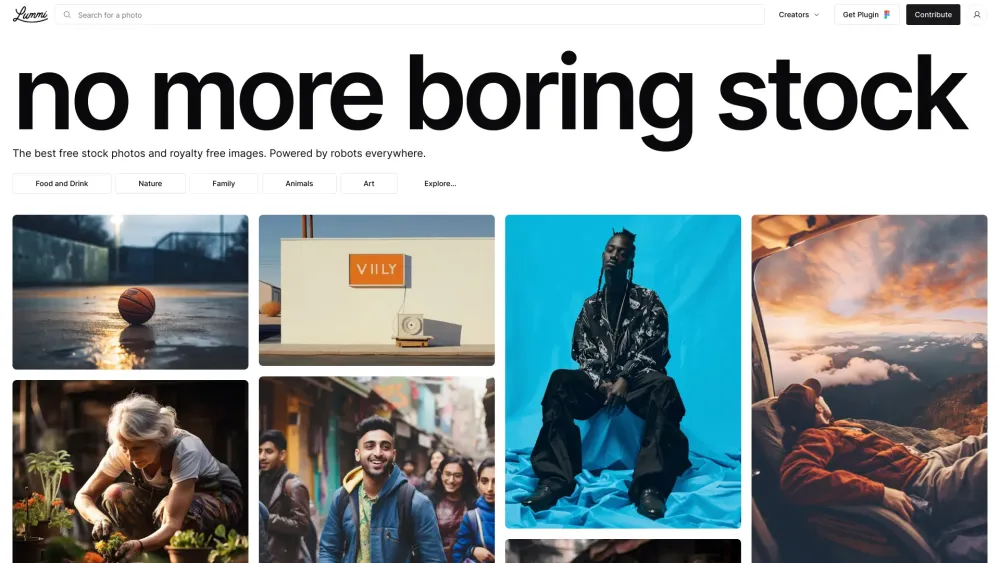

Descubra o mundo das fotos de estoque selecionadas por IA, onde tecnologia de ponta encontra visuais impressionantes. Explore uma coleção extensa de imagens de alta qualidade, cuidadosamente escolhidas por inteligência artificial para atender às suas necessidades criativas. Seja para campanhas de marketing, mídias sociais ou projetos pessoais, nossa plataforma impulsionada por IA garante que você encontre as fotos de estoque perfeitas que ressoam com seu público. Mergulhe em uma nova era de imagens e eleve seus projetos com visuais marcantes hoje!

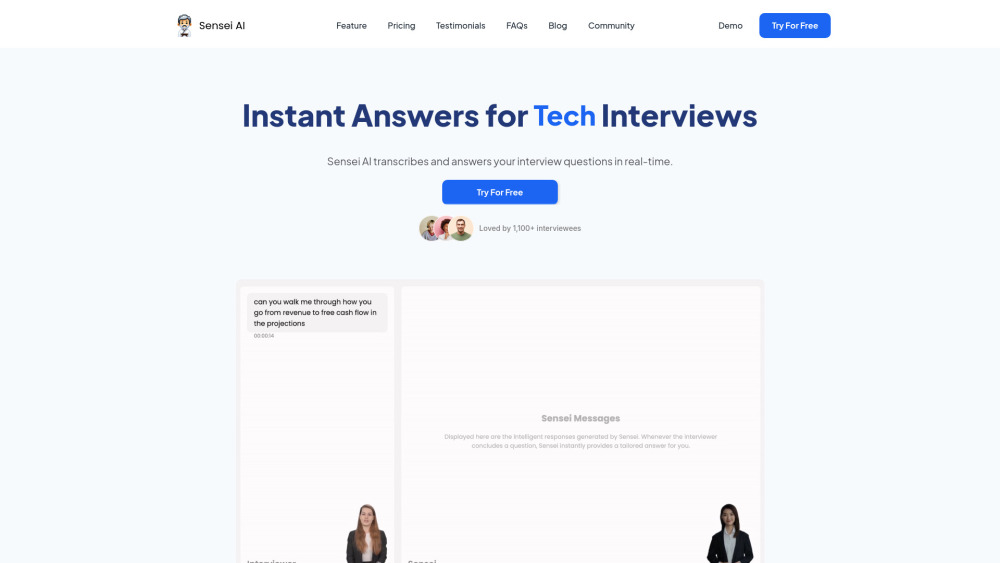

No competitivo mercado de trabalho atual, destacar-se em entrevistas é crucial para conseguir a posição dos seus sonhos. Apresentamos o Copiloto de Entrevista com Inteligência Artificial—uma ferramenta revolucionária projetada para aprimorar suas habilidades em entrevistas e aumentar sua confiança. Com treinamentos personalizados, feedback em tempo real e perguntas de prática sob medida, essa solução inovadora ajuda os candidatos a se destacarem. Descubra como essa tecnologia pode transformar sua preparação para entrevistas e abrir caminho para o sucesso na carreira.

Find AI tools in YBX

Related Articles

Refresh Articles