Google Lança PaliGemma: Seu Primeiro Modelo Multimodal de Visão-Linguagem Aberto para Aprimorar as Capacidades de IA

Most people like

Descubra um serviço acessível de conversão de texto em fala e de fala em texto que transforma conteúdo escrito em áudio realista e converte palavras faladas em texto preciso. Perfeito para empresas, educadores e indivíduos, nossa solução inovadora aprimora a acessibilidade e a eficiência. Seja para criar áudio para apresentações ou transcrever reuniões, nosso serviço versátil atende a todas as suas necessidades de transcrição e síntese de voz. Experimente uma comunicação fluida e produtividade aprimorada hoje!

Aproveitando Simulações de Voz em IA para Aprimorar o Treinamento de Habilidades Profissionais

No ambiente de trabalho em rápida evolução de hoje, a comunicação eficaz e habilidades especializadas são fundamentais. As simulações de voz em IA estão revolucionando o treinamento de habilidades profissionais ao oferecer experiências de prática imersivas e realísticas. Essas ferramentas avançadas têm como objetivo melhorar os resultados de aprendizado, aumentar a confiança e promover o desenvolvimento de competências essenciais em diversas indústrias. Descubra como as simulações de voz em IA podem transformar suas iniciativas de treinamento profissional e prepará-lo para o sucesso em um mercado de trabalho competitivo.

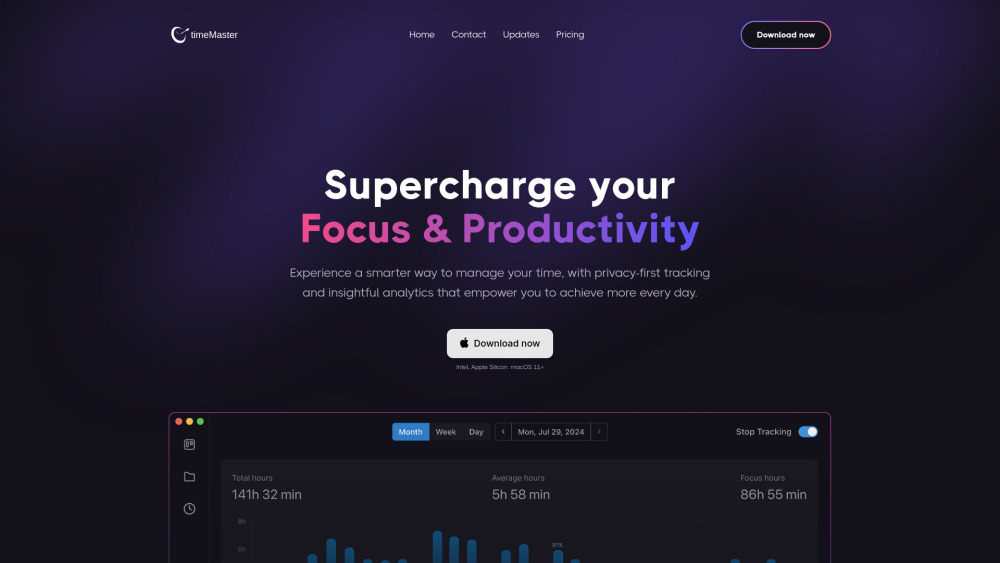

Descubra o poder de uma ferramenta de rastreamento de tempo automatizada, projetada para aumentar a produtividade e melhorar a gestão do foco.

Find AI tools in YBX

Related Articles

Refresh Articles