Meta Lança Modelo de Compilador LLM: Aprimorando Habilidades de Programação em IA para Otimização Eficiente de Código

Most people like

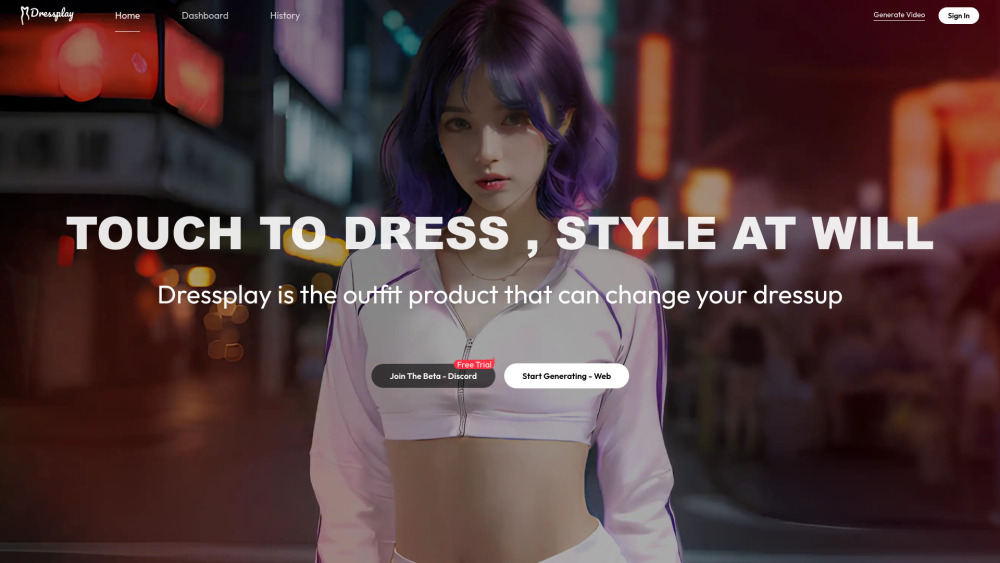

Apresentamos o DressPlay – um aplicativo inovador de troca de roupas com IA, criado para entusiastas da moda e empresas de e-commerce. Se você está ansioso para experimentar novos estilos ou deseja aprimorar sua experiência de varejo online, o DressPlay oferece uma maneira simples de transformar seu guarda-roupa com apenas um clique.

Apresentamos uma plataforma impulsionada por IA, projetada para respostas instantâneas e conversas envolventes. Vivencie o futuro do diálogo, onde a inteligência artificial facilita interações em tempo real e fornece respostas precisas ao seu alcance.

Find AI tools in YBX

Related Articles

Refresh Articles