OpenAI Lança o Modo de Voz Avançado do ChatGPT com Interação Humana para Usuários dos EUA e da Equipe!

Most people like

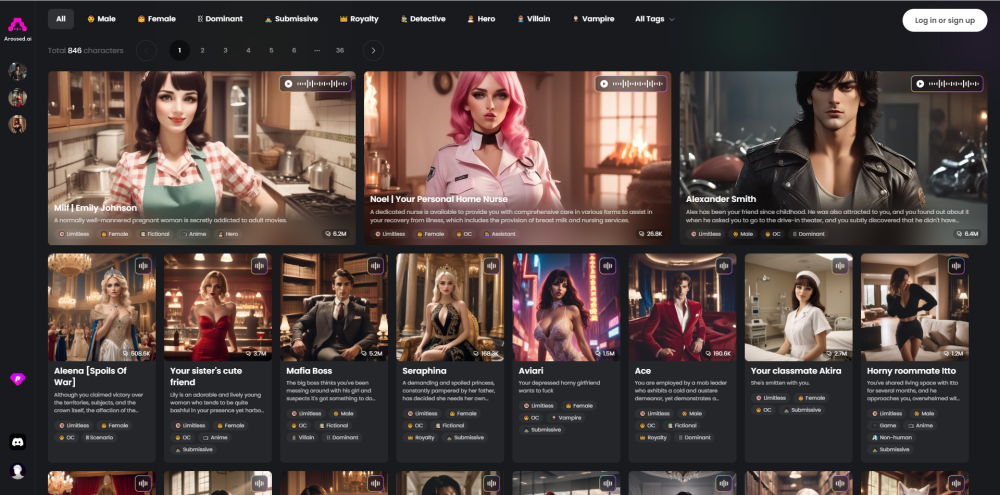

Nos últimos anos, o cenário do entretenimento adulto foi transformado pela chegada da tecnologia de IA imersiva. Essa inovação oferece uma experiência inovadora que combina arte, narrativa e interatividade, ampliando os limites do conteúdo adulto tradicional. À medida que o público busca experiências mais personalizadas e envolventes, a IA imersiva está redefinindo o entretenimento ao criar cenários realistas e narrativas cativantes. Descubra como essa tecnologia de ponta está moldando o futuro do entretenimento adulto e o que isso significa para criadores e consumidores.

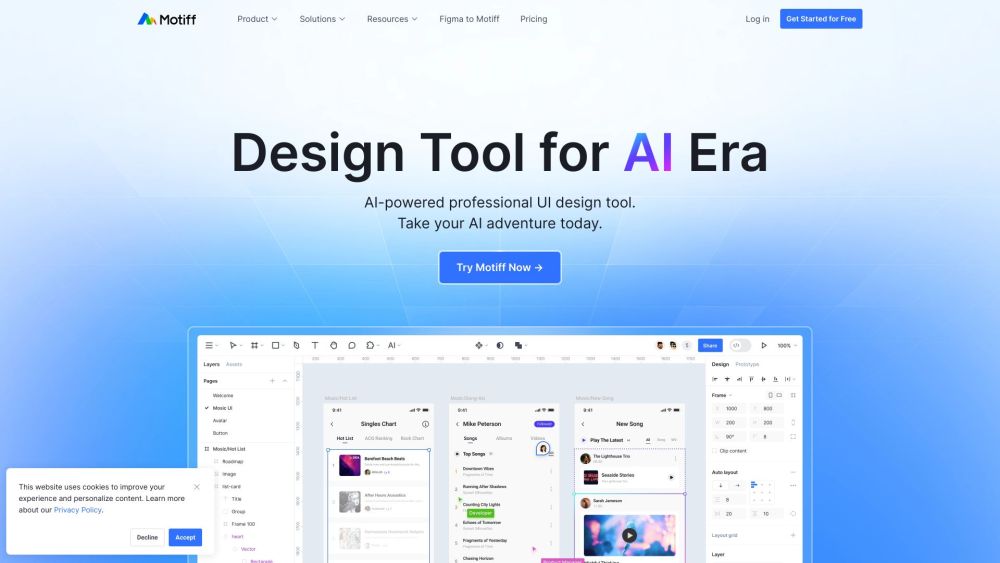

Desperte o potencial dos seus projetos criativos com nossa ferramenta de design impulsionada por IA, especialmente desenvolvida para prototipagem fluida e completa. Experimente uma abordagem inovadora que otimiza seu processo de design e eleva seus protótipos a um novo patamar.

Apresentamos uma poderosa ferramenta online gratuita que utiliza tecnologia de IA para resumir e condensar textos em pontos-chave essenciais. Perfeita para aumentar a produtividade e a compreensão!

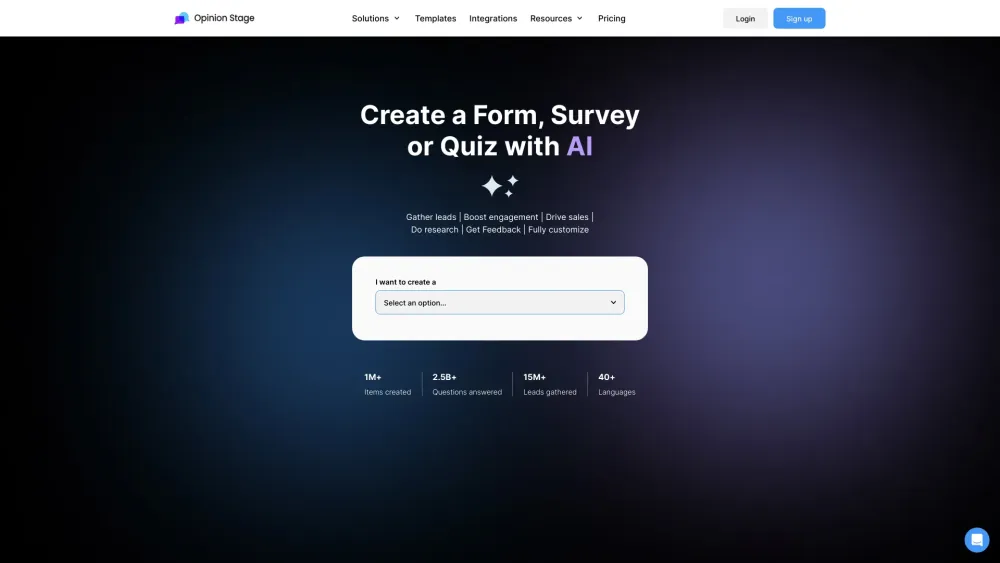

Impulsione sua estratégia de geração de leads com quizzes interativos. Essas ferramentas envolventes não apenas capturam a atenção, mas também coletam informações valiosas sobre seu público. Descubra como a incorporação de quizzes em seus esforços de marketing pode aumentar o envolvimento do usuário e converter prospects em clientes fiéis.

Find AI tools in YBX