A empresa de governança de IA Credo AI lançou uma nova plataforma com o intuito de aprimorar a visibilidade e a conformidade em torno de políticas de IA responsável, integrando operações de IA de terceiros e ferramentas de negócios.

O recém-lançado Credo AI Integrations Hub permite que clientes corporativos conectem plataformas de desenvolvimento de IA generativa, como Amazon SageMaker, MLFlow e Microsoft Dynamics 365, a uma plataforma de governança centralizada. Além disso, plataformas frequentemente utilizadas para implantar essas aplicações—como Asana, ServiceNow e Jira—também podem ser integradas ao Hub.

A proposta do Integrations Hub é simplificar a conexão entre aplicações de IA e a plataforma de governança da Credo AI. As empresas não precisarão mais fazer upload de documentos para validar normas de segurança; em vez disso, o Hub coletará automaticamente os metadados relevantes contendo essas métricas.

De acordo com Navrina Singh, fundadora e CEO da Credo AI, o Integrations Hub foi desenvolvido para incorporar a governança de IA—abrangendo regras de divulgação de dados e políticas internas de uso da IA—nos estágios iniciais do processo de desenvolvimento.

“À medida que organizações globais se adaptam à rápida adoção de ferramentas de IA, nosso objetivo é ajudá-las a maximizar seus investimentos em IA simplificando a governança e eliminando a complexidade”, afirmou Singh.

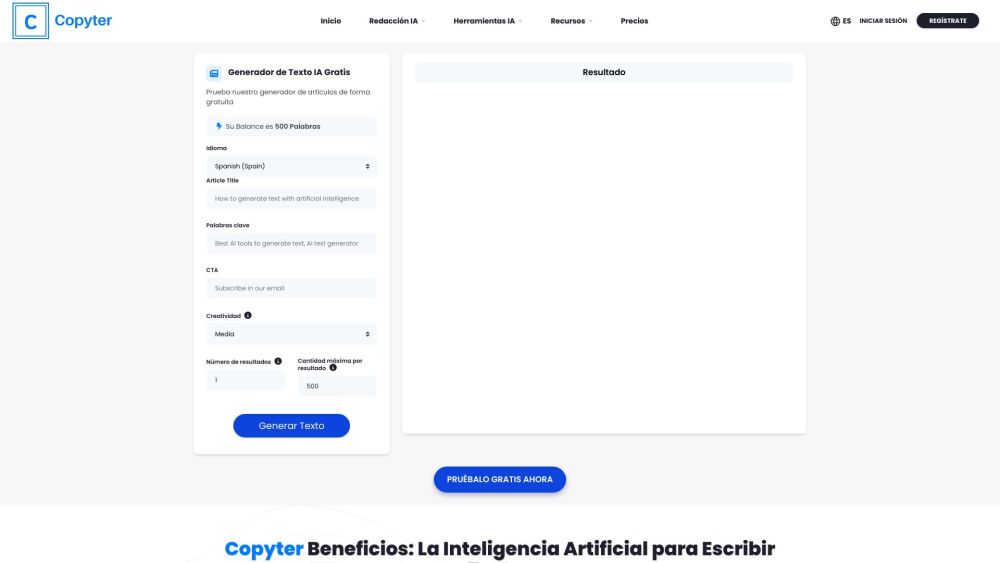

O Integrations Hub oferece conexões pré-configuradas com plataformas populares, como Jira, ServiceNow, SageMaker e Bedrock da Amazon, Salesforce, MLFlow, Asana, Databricks, Microsoft Dynamics 365, Azure Machine Learning, Weights & Biases, Hugging Face e Collibra. Integrações personalizadas também podem ser desenvolvidas mediante taxa adicional.

Governança Desde o Início

Pesquisas indicam que a IA responsável e a governança—avaliando a conformidade com regulamentos, considerações éticas e privacidade—tornam-se cada vez mais críticas para as empresas. No entanto, poucas organizações atualmente conseguem avaliar esses riscos de forma eficaz.

Conforme os negócios exploram práticas responsáveis na IA generativa, ferramentas que simplificam a avaliação de riscos e conformidade estão ganhando destaque. A Credo AI é uma das várias empresas que buscam tornar práticas de IA responsável mais acessíveis.

O conjunto de produtos Watsonx da IBM inclui uma plataforma de governança para avaliar modelos quanto à precisão, viés e conformidade, enquanto a Collibra oferece ferramentas de governança de IA que criam fluxos de trabalho para monitoramento de programas de IA.

Enquanto a Credo AI verifica aplicações em busca de riscos potenciais à marca, seu foco principal é garantir que as organizações cumpram as regulamentações existentes e futuras relacionadas a sistemas automatizados.

Atualmente, as regulamentações sobre IA generativa são escassas, embora as empresas tenham seguido políticas de privacidade e retenção de dados estabelecidas por meio de regras de aprendizado de máquina e dados.

Singh observou que algumas regiões exigem relatórios sobre governança de IA, destacando a Lei 144 da Cidade de Nova York, que proíbe ferramentas automatizadas em decisões de emprego.

“Métricas específicas, como a razão de paridade demográfica, são necessárias para conformidade. A Credo AI traduz essa lei em insights acionáveis para suas operações de IA, permitindo a coleta de metadados necessários para cumprir obrigações legais”, explicou Singh.