Por que você deve evitar confiar em chatbots de IA para suas fontes de notícias

Most people like

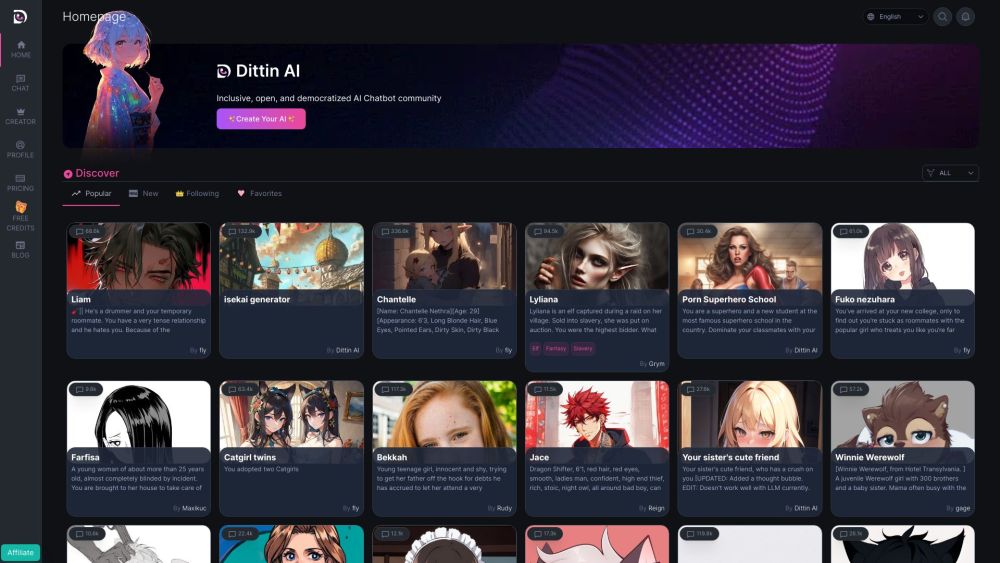

Bem-vindo à Comunidade de Chatbots de IA Inclusivos, onde unimos inovadores, desenvolvedores e entusiastas dedicados a criar chatbots de IA acessíveis e fáceis de usar. Nossa missão é fomentar a colaboração, compartilhar conhecimentos e promover as melhores práticas que garantem que a tecnologia sirva a todos, independentemente de sua origem ou capacidade. Junte-se a nós enquanto exploramos o futuro dos chatbots de IA, enfatizando a inclusão e construindo um mundo digital mais equitativo para todos.

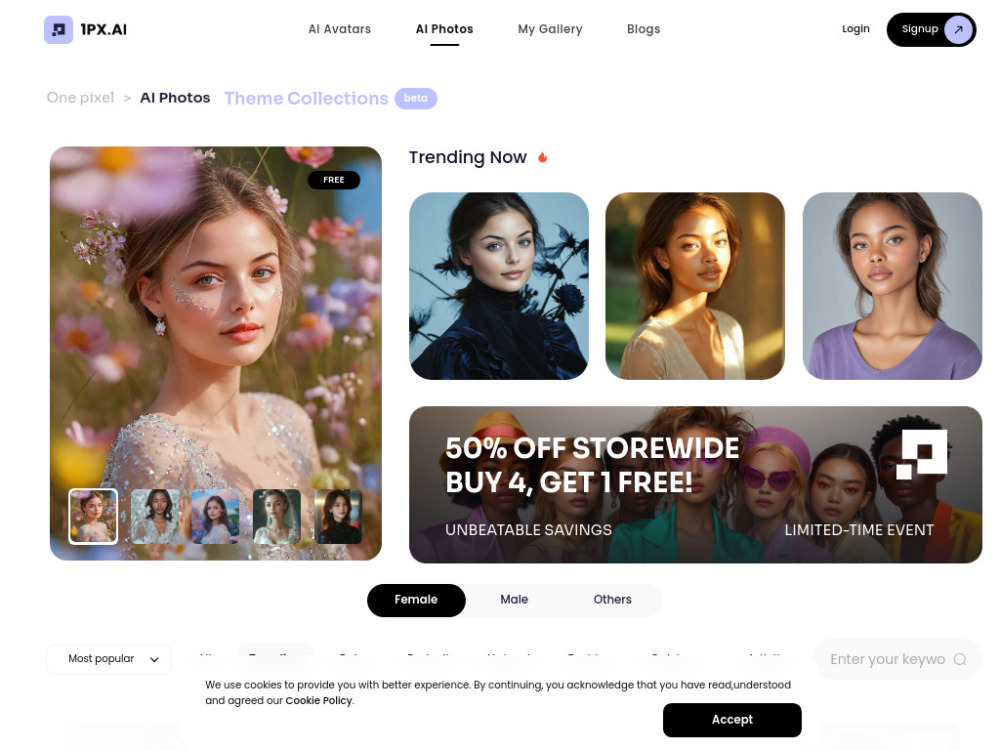

No mundo digital de hoje, criar avatares ou transformações de fotos únicos e personalizados nunca foi tão simples. Com tecnologia de IA de ponta, nosso gerador de avatares e fotos permite que os usuários desenhem representações digitais impactantes de maneira fácil. Seja para aprimorar sua presença online ou expressar sua criatividade, essa ferramenta inovadora facilita a geração de imagens de alta qualidade adaptadas às suas especificações. Transforme suas ideias em visuais e experimente o poder da IA na criação de avatares hoje mesmo!

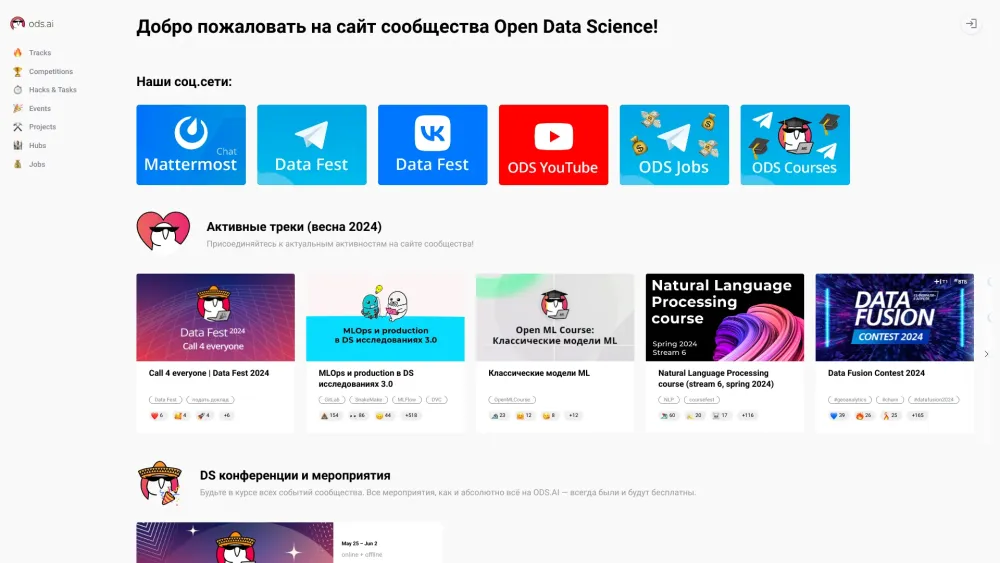

Junte-se ao nosso vibrante site comunitário, projetado especificamente para cientistas de dados e entusiastas de IA. Aqui, você encontrará recursos valiosos, discussões perspicazes e uma rede de apoio para ajudá-lo a prosperar no mundo em constante evolução da ciência de dados e da inteligência artificial. Interaja com pessoas que pensam como você, compartilhe seu conhecimento e mantenha-se atualizado sobre as últimas tendências e tecnologias que moldam o futuro da IA e da análise de dados.

Find AI tools in YBX

Related Articles

Refresh Articles