Проблемы безопасности генеративного ИИ побуждают компании улучшать протоколы аудита ИИ.

Most people like

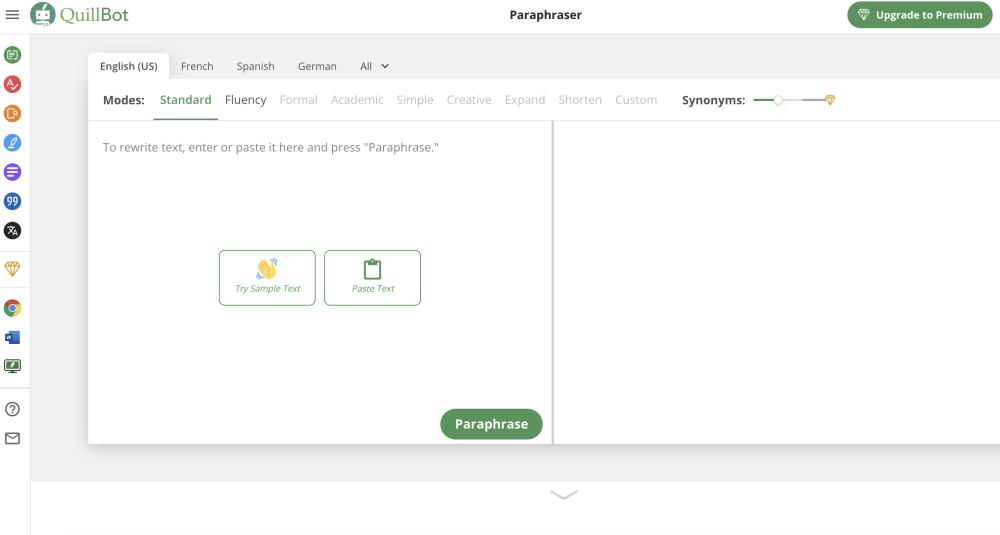

Превратите своё письмо без esfuerzo с этим мощным онлайн инструментом для переписывания текста. Независимо от того, нужно ли вам переформулировать статью, улучшить ясность или создать новый контент, наша удобная платформа делает переписывание лёгким. Идеально подходит для студентов, профессионалов и создателей контента, этот инструмент поднимает качество вашего письма, сохраняя оригинальное значение. Узнайте, как просто улучшить свой текст уже сегодня!

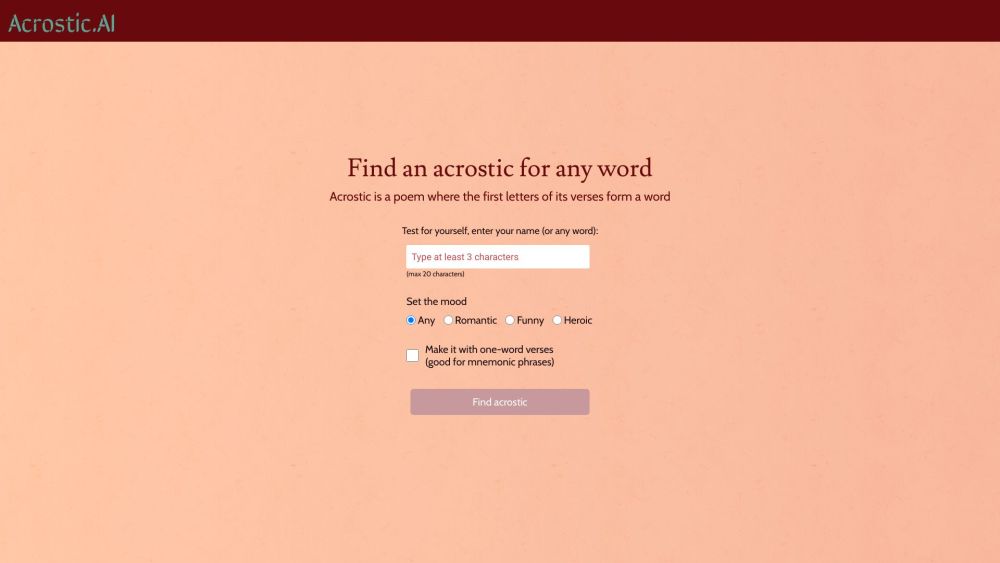

Откройте для себя творческий мир генератора акростихов, работающего на основе ИИ, где каждая буква вдохновляет на создание уникальной строки поэмы. Развивайте свою фантазию и позвольте искусственному интеллекту создавать персонализированные акростихи, которые отражают ваши темы и эмоции. Идеально подходит для любителей поэзии, педагогов и всех, кто хочет добавить лирический оттенок в свои записи, этот инновационный инструмент превращает простые слова в прекрасные выражения. Испытайте магию создания поэзии на кончиках ваших пальцев!

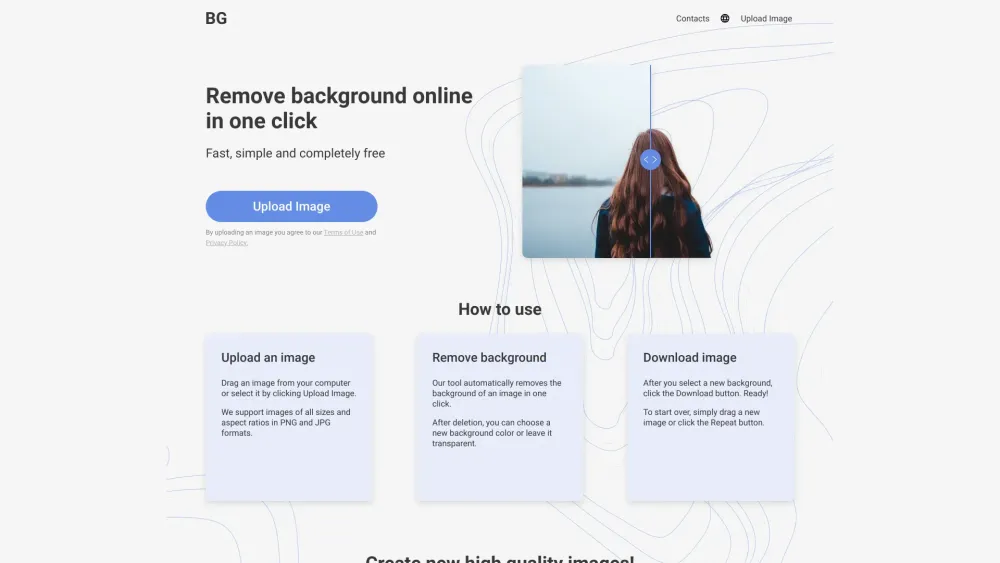

Легко удаляйте фон из изображений всего одним кликом! Независимо от того, улучшаете ли вы фотографии для личных проектов или профессиональных презентаций, наш удобный инструмент упрощает процесс редактирования, позволяя вам добиться потрясающих результатов за короткое время. Прощайте, сложные программы, и здравствуйте, простое редактирование изображений!

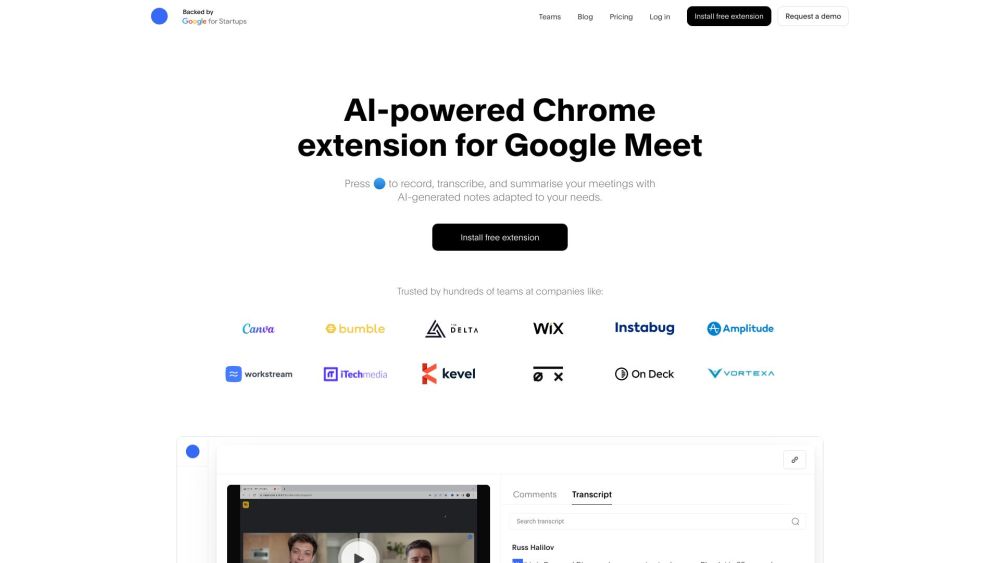

Представляем расширение Chrome на базе ИИ, разработанное для автоматического создания заметок с собраний. Измените подход к записи и организации ваших обсуждений с помощью этого усовершенствованного инструмента, который гарантирует, что вы не упустите ни одной важной детали. Увеличьте свою продуктивность и оптимизируйте рабочий процесс с легким созданием заметок прямо у вас под рукой.

Find AI tools in YBX

Related Articles

Refresh Articles