要充分利用大型语言模型(LLMs),网页应用通常依赖于连接云服务器。然而,前谷歌工程师雅各布·李(Jacob Lee)提出了一种创新的方法,使AI能够在本地运行,从而显著降低与云解决方案相关的成本和隐私问题。李曾参与开发谷歌照片功能,目前他在流行的LangChain框架中贡献力量,并在Ollama的博客上分享了他的思路。

在他的文章中,李解释了开发者如何创建能够直接与用户设备上的文档进行对话的网页应用,从而消除了对昂贵云连接的需求。通过结合开源工具,他设计了一个网页应用,使用户可以用自然语言与报告或论文进行互动。感兴趣的用户只需安装Ollama桌面应用,执行几个本地设置命令,即可访问演示并与任何上传的文档进行对话。

在演示中,用户需要在Ollama上运行一个本地的Mistral实例,李的博客中详细列出了设置说明。

过程概述

李的实施过程涉及简化的五个步骤:

1. 数据导入:用户将PDF等文档加载到系统中。李利用LangChain将这些文档分割成可管理的小块,并使用Transformers.js生成每个小块的向量嵌入。这些小块随后组织在Voy向量存储数据库中。

2. 检索:当用户输入问题时,系统会搜索向量存储,找到与查询最相关的小块。

3. 生成:问题和已识别的小块被发送到本地运行的Ollama AI,后者使用Mistral模型根据检索到的信息生成响应。

4. 再引用:对于后续查询,系统会在重复检索和生成步骤之前重新构造问题。

5. 暴露本地AI:Ollama工具为网页应用提供了访问本地运行的Mistral模型的能力,从而实现生成功能的无缝集成。

本质上,李开发的网页应用能够离线讨论文档,完全依赖于用户个人计算机上运行的智能软件。

对企业和开发者的优势

这种以本地为主的方法对企业和企业开发者有着显著影响。通过减少对云的依赖,转向本地部署,组织可以降低运营成本,特别是在扩展操作时。此外,这种方法还允许高度定制,用户可以使用公司内部数据创建精细调优的模型。

在本地处理数据还解决了隐私问题,确保敏感信息保留在内部,降低潜在的泄露风险。李预计,随着新兴模型设计变得更小更高效,这种系统将变得越来越普遍,提高与本地设备的兼容性。

为促进更广泛的访问,李设想了一个浏览器API,允许网页应用请求访问本地运行的LLM,类似于Chrome扩展。“我对LLM驱动的网页应用的未来感到非常兴奋,Ollama和LangChain等技术将如何促进全新的用户互动,”他表示。

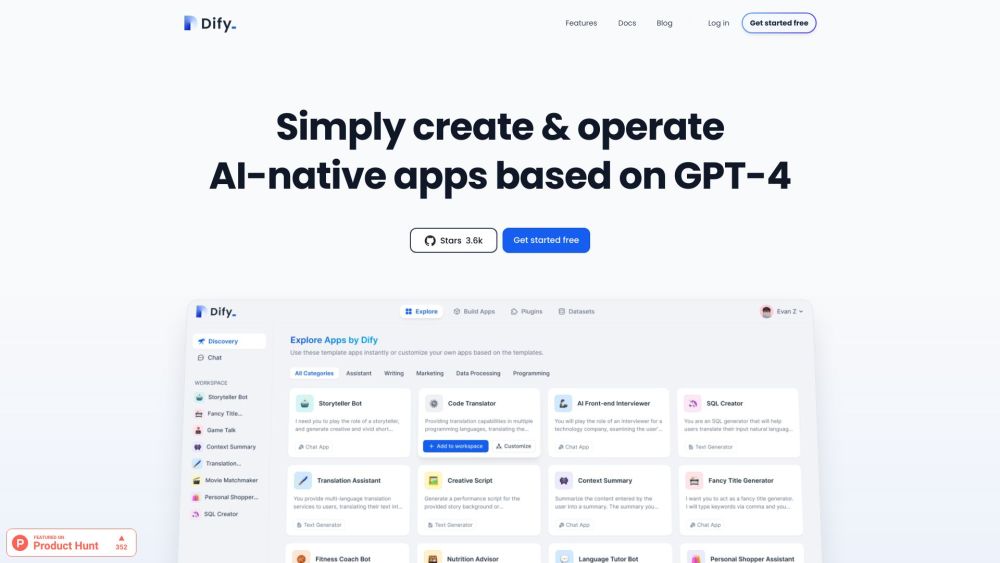

李的理念与AI驱动网页开发日益增长的趋势相吻合。像MetaGPT这样的平台允许用户使用自然语言命令构建应用,而CodeWP.ai等工具则为网站生成HTML。此外,开发环境如GitHub Copilot和Replit AI简化了编码过程,而谷歌的Project IDX等倡议为开发者提供了探索AI资源的机会。

总而言之,雅各布·李对本地LLM集成的创新方法不仅为成本效益高且注重隐私的应用铺平了道路,还改变了用户在日益由先进AI能力驱动的数字环境中与技术互动的方式。