帝国理工学院与DeepMind联合推出能够以最少数据学习的实体智能体

Most people like

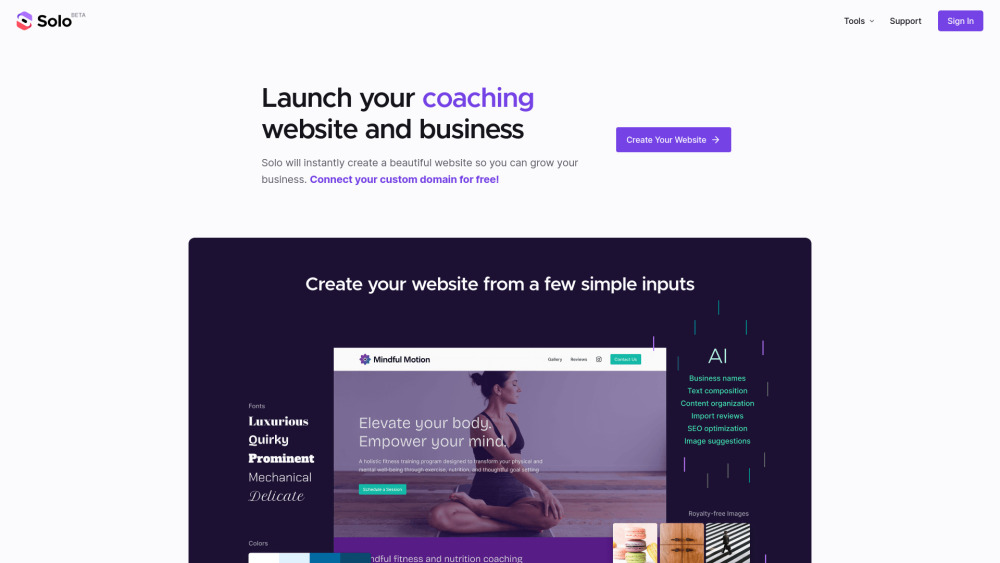

企业级AI网站创建器:简化在线业务建设

随着数字化转型的加速,企业越来越依赖高效、用户友好的网站。面向企业的AI网站创建器应运而生,旨在降低网站建设的复杂性,提高企业在线存在感。通过智能设计和自动化工具,这种创建器能够帮助企业快速搭建专业网站,提升用户体验,同时节约时间和成本。无论您是中小型企业还是大型公司,借助AI技术,打造您的企业网站再也不是一项艰巨的任务。

AI图像增强技术是现代摄影和图像处理的游戏规则改变者,专注于去噪、去模糊和提升图像分辨率。借助先进的人工智能算法,这些工具可以显著改善图像质量,提升视觉效果,非常适合专业摄影师和爱好者。探索这些技术如何在不同应用场景中发挥关键作用,让你的作品焕然一新。

全球企业正在越来越多地采用人工智能解决方案,以提升效率和创新能力。这些解决方案不仅能够改变企业的运营方式,还能帮助它们在激烈的市场竞争中脱颖而出。无论是数据分析、客户互动还是流程自动化,人工智能技术正成为企业发展的关键驱动力。获取最新的人工智能发展动态,了解全球企业如何利用这些先进技术,实现转型与增长。

Find AI tools in YBX

Related Articles

Refresh Articles