نموذج AI2 الجديد الفعّال من حيث التكلفة: حلول مفتوحة وقوية للجميع

Most people like

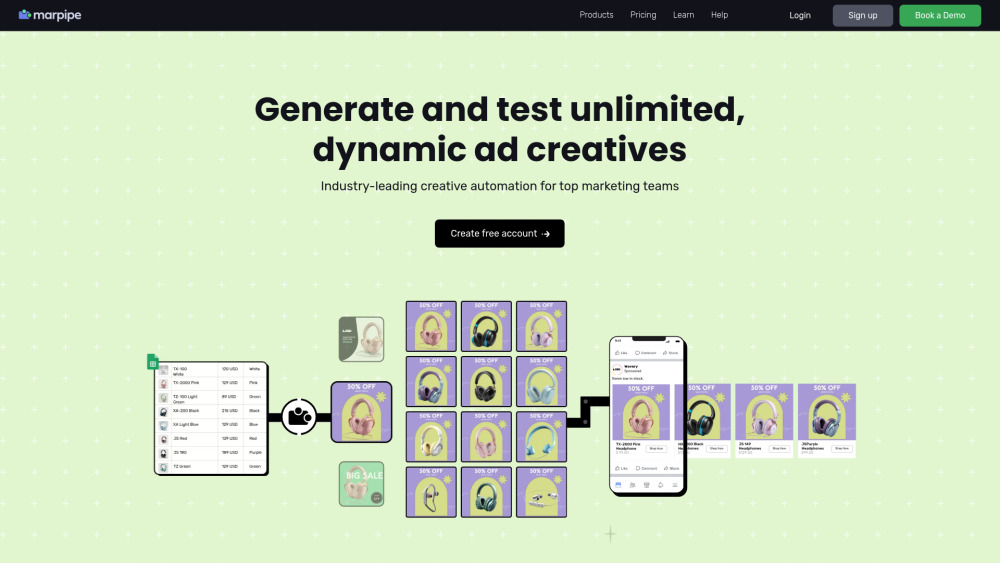

تقديم منصة مؤتمتة مصممة لإنشاء واختبار إعلانات المنتجات الديناميكية. قم بتبسيط جهودك الإعلانية ورفع مستوى التفاعل من خلال حلول مخصصة تعزز استراتيجيتك التسويقية بكفاءة.

ثورة محتوى الفيديو بتقنية الذكاء الاصطناعي: فتح آفاق جديدة

في عالمنا الرقمي اليوم، يوفر استخدام الذكاء الاصطناعي في تحويل محتوى الفيديو فرصاً غير مسبوقة للمبدعين والشركات على حد سواء. تعزز هذه التقنية المبتكرة السرد القصصي، وتزيد من التفاعل، وتبسط عمليات الإنتاج، مما يجعلها نقطة تحوّل في عالم الوسائط المتعددة. اكتشف كيف يشكل الذكاء الاصطناعي مستقبل إنشاء محتوى الفيديو ويساعد العلامات التجارية على التواصل بشكل أكثر فعالية مع جمهورها.

كلاپ هو مساحة عمل فيديو مبتكرة مصممة لتعزيز التعاون وتسهيل مشاركة المعرفة. مع ميزات قوية مثل تسجيل الشاشة والملاحظات المولّدة بواسطة الذكاء الاصطناعي، يجعل كلاپ العمل الجماعي أكثر كفاءة وإنتاجية.

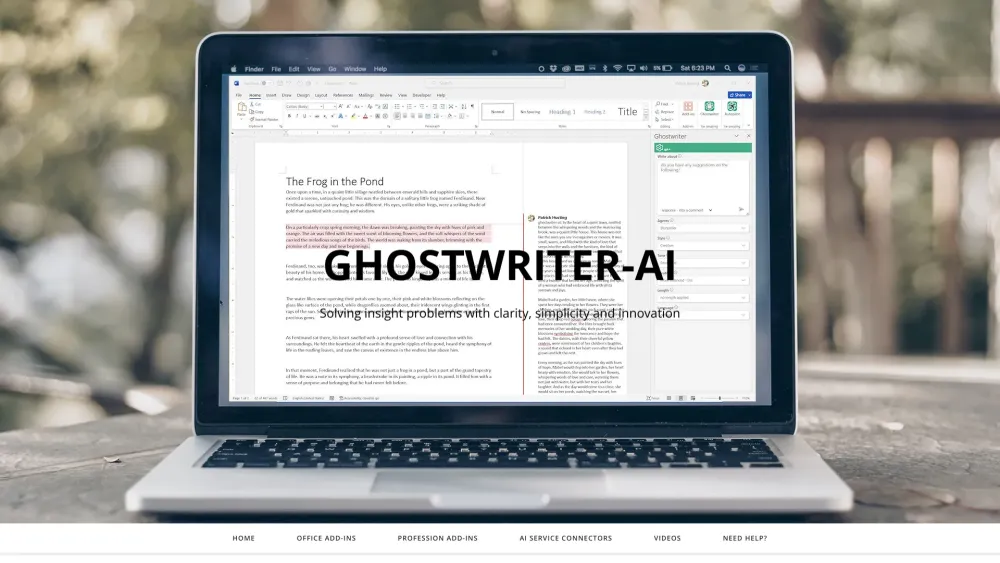

حوّل تجربة Microsoft Office الخاصة بك مع حلول الذكاء الاصطناعي الثورية

افتح إمكانيات Microsoft Office الكاملة من خلال ابتكارات الذكاء الاصطناعي الرائدة التي تهدف إلى تعزيز الإنتاجية وتبسيط سير العمل. اكتشف كيف يمكن لهذه الأدوات المتطورة أن تحدث ثورة في الطريقة التي تنشئ بها، وتتعاون، وتواصل ضمن تطبيقات Office المفضلة لديك. سواء كنت تبحث عن أتمتة المهام المملة أو تعزيز عملية إنشاء المستندات، فإن حلول الذكاء الاصطناعي لدينا هنا لإعادة تعريف تجربتك مع Microsoft Office.

Find AI tools in YBX

Related Articles

Refresh Articles