Anthropic Presenta Prompts para Sistemas de IA, Recibiendo Reconocimientos por su Transparencia e Innovación

Most people like

Mejora tu vocabulario en inglés con técnicas de aprendizaje inteligentes

Desbloquea el poder de un aprendizaje efectivo del vocabulario en inglés con estrategias innovadoras diseñadas para potenciar tus habilidades lingüísticas. Al emplear técnicas inteligentes, podrás ampliar tu vocabulario de manera eficiente y con confianza. Descubre cómo optimizar tu experiencia de aprendizaje mientras dominas las sutilezas del idioma inglés.

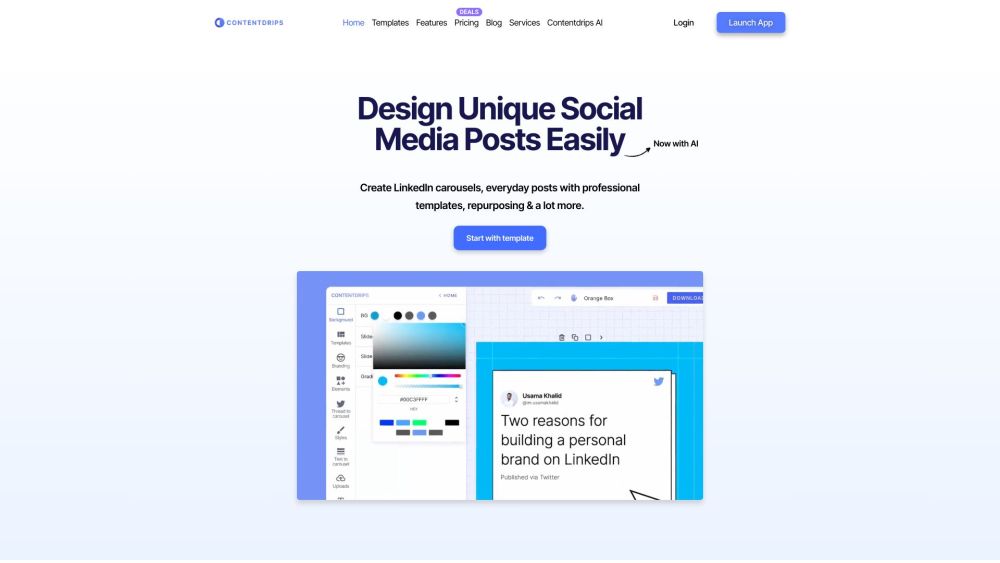

Crea publicaciones impactantes en redes sociales en minutos utilizando plantillas personalizables, herramientas de edición inteligentes y asistencia de IA. ¡Potencia tu presencia en línea sin esfuerzo!

Presentando una Plataforma Potenciada por IA para Mejorar la Accesibilidad de Video

En el mundo digital actual, garantizar la accesibilidad de los videos es fundamental para involucrar a diversas audiencias. Nuestra innovadora plataforma impulsada por IA transforma el contenido audiovisual al generar automáticamente subtítulos, transcripciones y traducciones, haciéndolo accesible para todos, incluyendo personas con discapacidad auditiva y hablantes no nativos. Únete a nosotros para hacer que el contenido de video sea universalmente accesible, desbloqueando todo el potencial de tus medios para todos los espectadores.

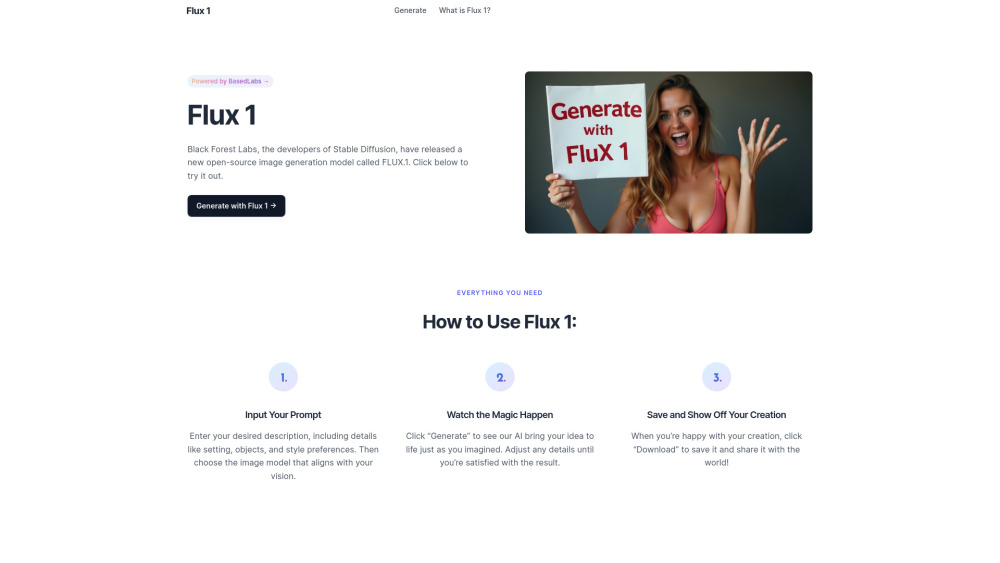

Generador de Imágenes AI: Crea Visuales Impresionantes Rápida y Fácilmente

Descubre nuestro avanzado generador de imágenes AI diseñado para producir visuales rápidos y de alta calidad adaptados a tus necesidades. Ya seas un comercializador, diseñador o creador de contenido, esta herramienta te permite generar imágenes cautivadoras en segundos, mejorando tus proyectos sin comprometer la calidad. Desbloquea tu potencial creativo y optimiza tu flujo de trabajo con nuestra solución innovadora.

Find AI tools in YBX

Related Articles

Refresh Articles