Análisis de la IA Copilot de Microsoft: Comprendiendo las Respuestas Erráticas y el Fenómeno de los Usuarios PUA

Most people like

WellSaid Labs es una plataforma de voz de IA líder, reconocida por ofrecer locuciones en tiempo real de alta calidad, con una claridad y naturalidad excepcionales.

Explora nuestro sitio web, tu recurso definitivo para prompts públicos, modelos innovadores y herramientas esenciales diseñadas para tus proyectos creativos. ¡Descubre inspiración infinita y soluciones prácticas para liberar tu creatividad hoy mismo!

Descubre los secretos para dominar las matemáticas resolviendo problemas paso a paso. Esta guía te llevará a través de las técnicas y estrategias esenciales necesarias para enfrentar desafíos matemáticos con confianza. Ya seas un estudiante que busca mejorar sus habilidades o un adulto que desea refrescar sus conocimientos, nuestro enfoque estructurado te guiará en cada proceso, garantizando claridad y comprensión en cada etapa. ¡Sumérgete y descubre cómo descomponer problemas complejos puede conducir a soluciones efectivas!

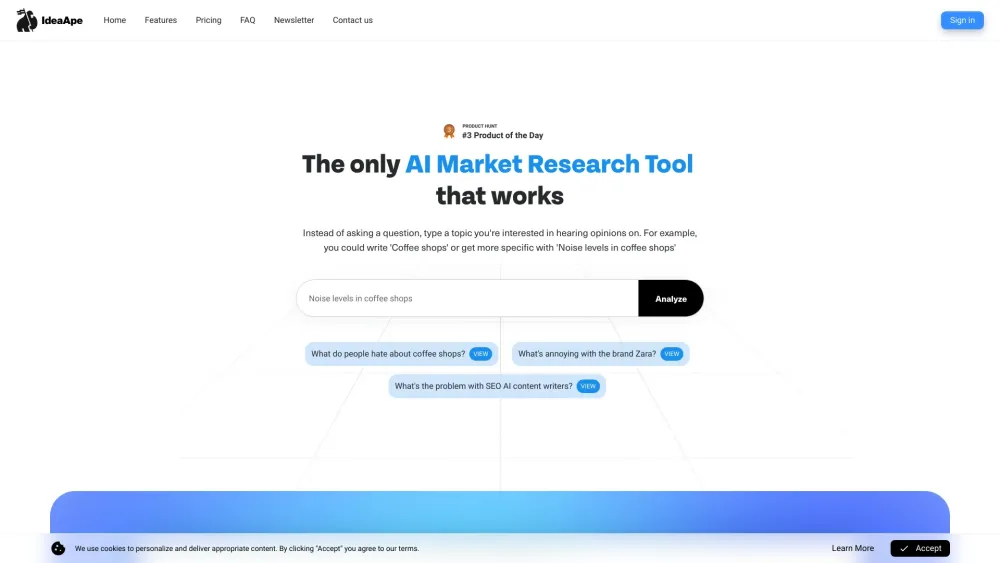

Descubre la herramienta definitiva de investigación de mercado con IA, diseñada tanto para usuarios avanzados como principiantes. Nuestra plataforma innovadora combina tecnología de vanguardia con características intuitivas, facilitando la recopilación de información y el análisis de tendencias del mercado. Experimenta el poder de la investigación impulsada por IA y mejora tu proceso de toma de decisiones hoy mismo.

Find AI tools in YBX