Arize lanza la supervisión de variable de entrada para identificar cuándo fallan los modelos de IA.

Most people like

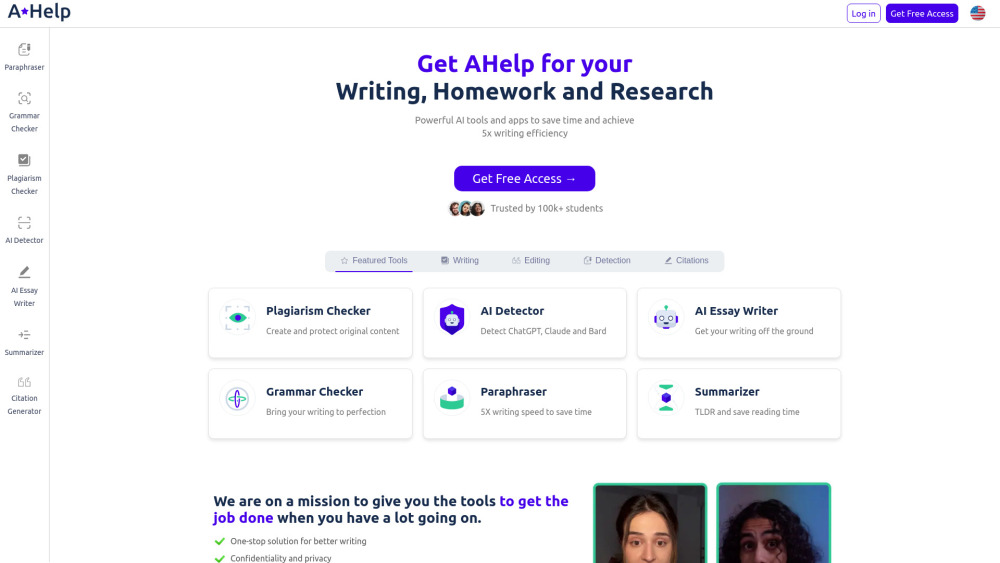

Mejora tu eficiencia en la escritura y alcanza la excelencia académica con herramientas de IA.

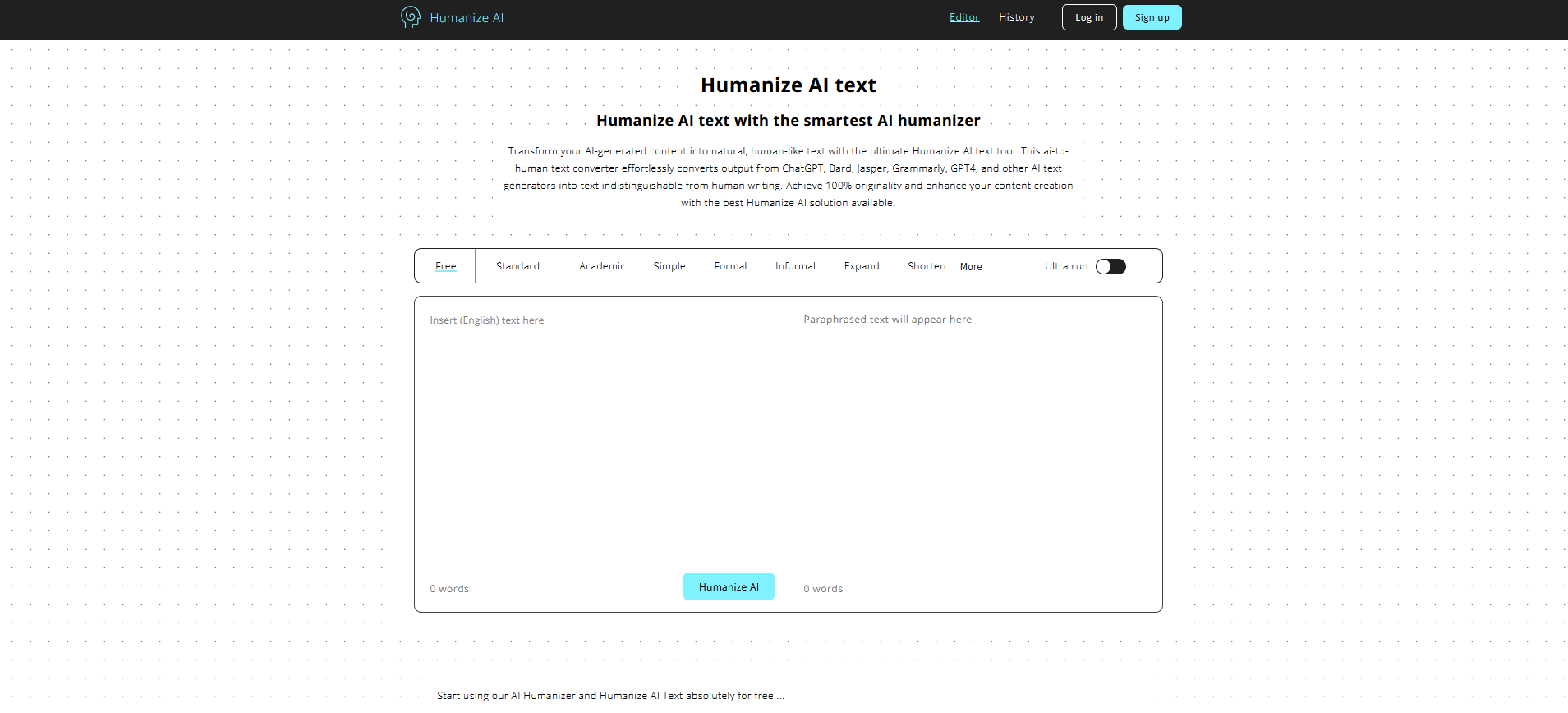

Transforma tu contenido generado por IA en texto natural y humano con la herramienta definitiva de Humanize AI. Este convertidor de texto de IA a humano transforma sin esfuerzo la salida de ChatGPT, Bard, Jasper, Grammarly, GPT-4 y otros generadores de texto en IA en un texto indistinguible de la escritura humana. Logra un 100% de originalidad y mejora tu creación de contenido con la mejor solución de Humanize AI disponible.

Crea resúmenes concisos de cualquier texto de manera fácil con nuestro generador de resúmenes gratuito. Ya sea que necesites resumir artículos largos, trabajos de investigación o ensayos, esta herramienta simplifica el proceso, ofreciendo resúmenes claros e informativos en segundos. Mejora tu productividad y comprensión aprovechando nuestra solución fácil de usar para todas tus necesidades de resumen.

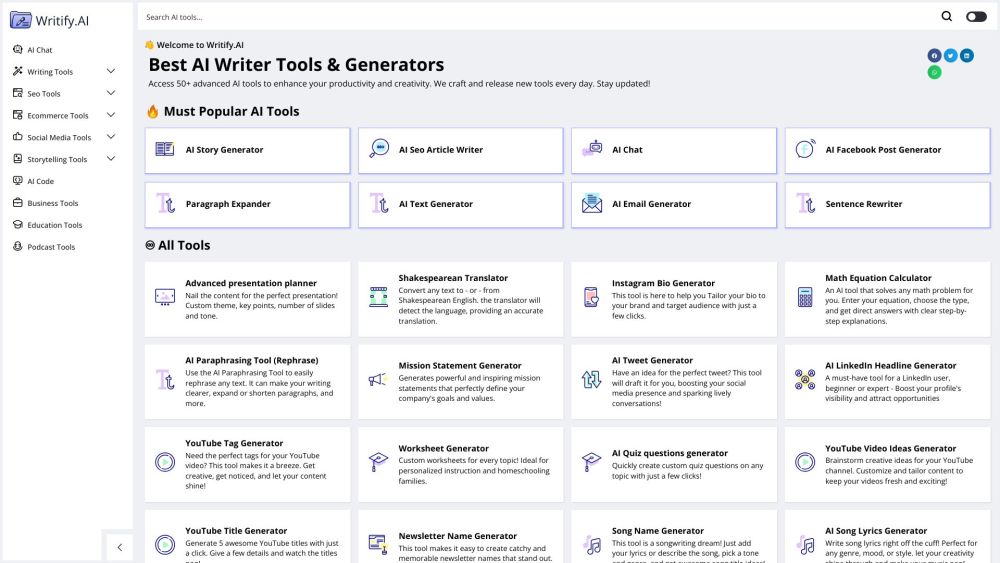

Desbloquea tu Potencial con Nuestro Conjunto de Herramientas de IA para Potenciar Productividad y Creatividad

Descubre cómo nuestro potente conjunto de herramientas de IA puede transformar tu flujo de trabajo, aumentar la productividad y encender tu chispa creativa. Diseñadas para individuos y equipos, estas soluciones innovadoras agilizan tareas, mejoran la colaboración e inspiran ideas originales. Explora el futuro del trabajo con tecnologías de IA de vanguardia diseñadas para maximizar tu eficiencia y fomentar la creatividad en cada proyecto. ¡Adopta hoy una forma más inteligente de alcanzar tus objetivos!

Find AI tools in YBX