De Google a IBM: Cómo los Gigantes Tecnológicos Están Aprovechando las Últimas Soluciones de Hardware y Software de Nvidia

Most people like

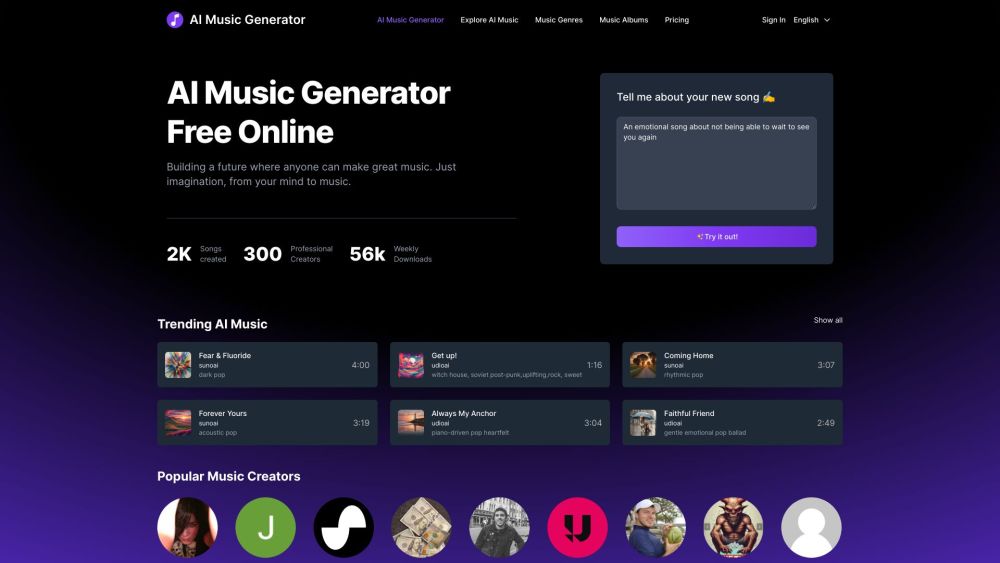

Desbloquea tu creatividad musical con nuestra innovadora plataforma que te permite generar canciones únicas utilizando tecnología de IA—¡totalmente gratis! Ya seas un músico en ciernes o simplemente estés interesado en explorar el arte de componer, nuestra herramienta ofrece una forma fácil y divertida de crear música personalizada adaptada a tu estilo. ¡Comienza tu viaje musical hoy y descubre las infinitas posibilidades de la composición impulsada por IA!

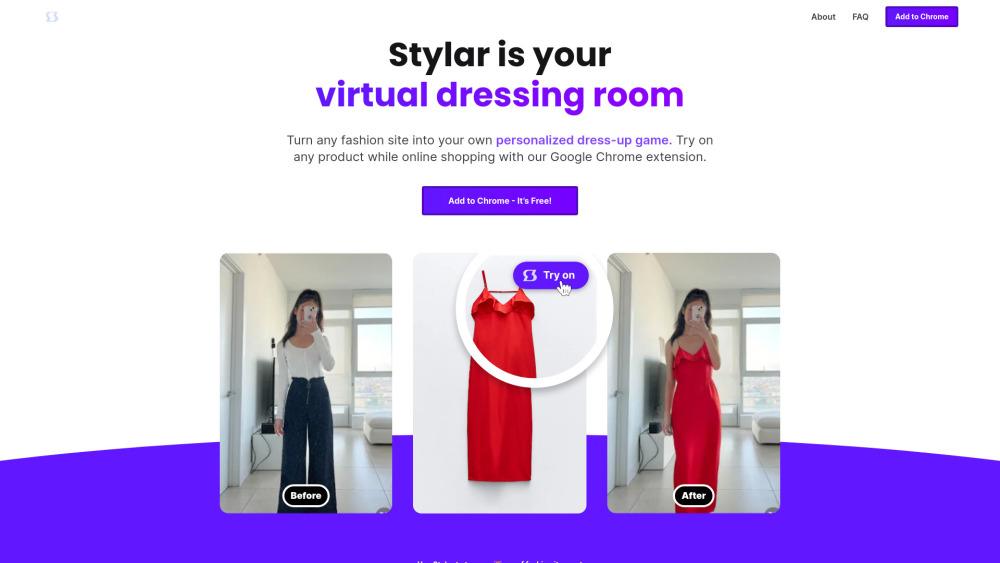

En el acelerado mundo digital de hoy, el auge de la inteligencia artificial (IA) ha transformado nuestra forma de comprar en línea, especialmente en lo que respecta a la ropa. La tecnología de prueba virtual permite a los consumidores visualizar cómo les quedarían las prendas sin salir de casa, mejorando la experiencia de compra. Esta solución innovadora está cambiando la manera en que las personas abordan la moda, facilitando y haciendo más placentera la búsqueda del atuendo perfecto. Con los avances en IA, los probadores virtuales se están convirtiendo en herramientas esenciales tanto para los minoristas como para los clientes, cerrando la brecha entre las compras físicas y las en línea.

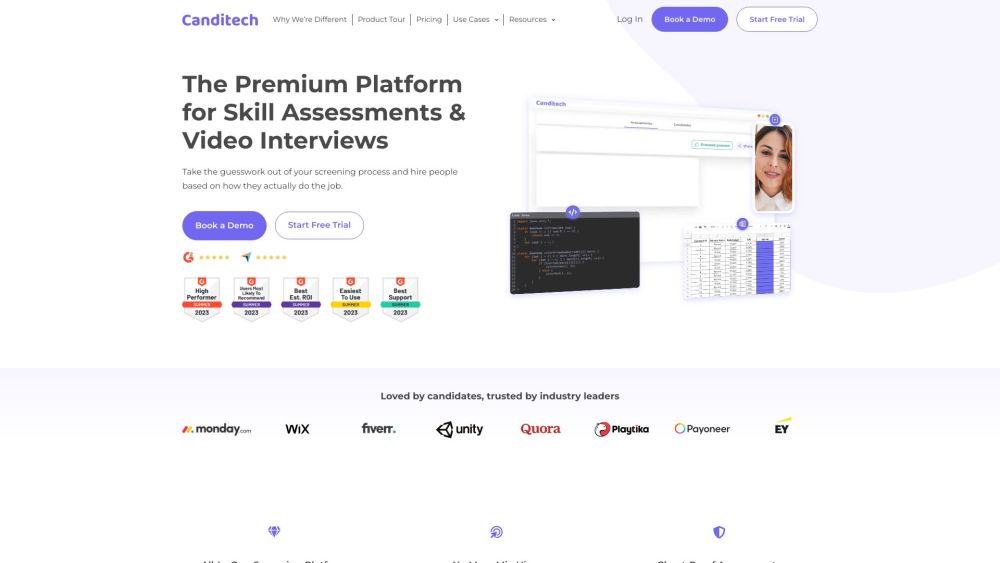

Prevenga costosos errores de contratación utilizando evaluaciones de habilidades automatizadas. Estas herramientas le aseguran evaluar con precisión a los candidatos, alineando sus habilidades con las necesidades de su organización. Al incorporar evaluaciones automatizadas en su proceso de contratación, puede mejorar significativamente la selección de candidatos, agilizar el reclutamiento y potenciar el rendimiento general del equipo.

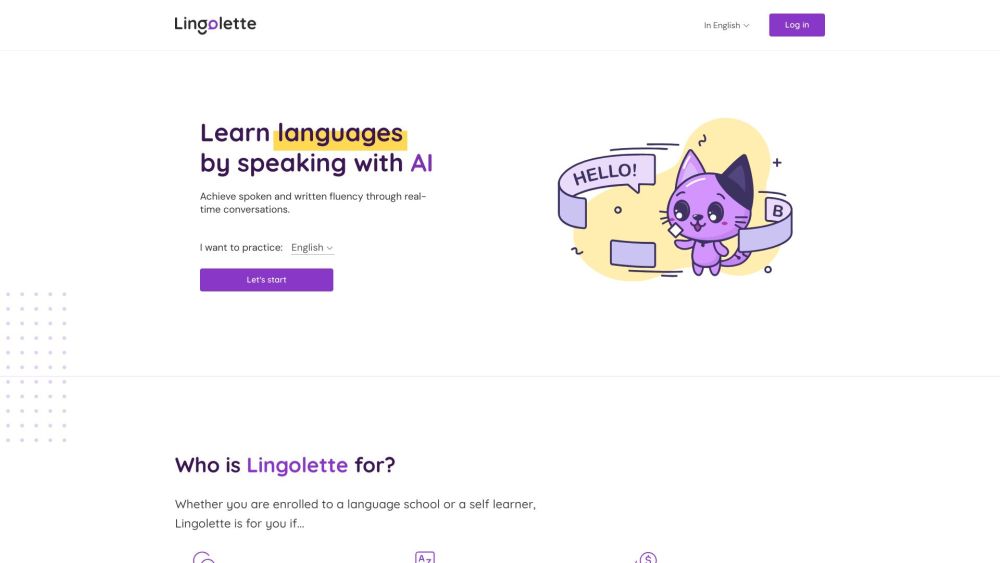

En el mundo acelerado de hoy, la comunicación efectiva es esencial, haciendo de la fluidez oral una habilidad crítica para los estudiantes. Una máquina de enseñanza de idiomas diseñada específicamente para mejorar la fluidez oral puede revolucionar la forma en que las personas practican y perfeccionan sus habilidades de habla. Al combinar tecnología avanzada con técnicas de aprendizaje personalizadas, esta herramienta innovadora ayuda a los usuarios a ganar confianza y competencia en su idioma hablado, convirtiéndola en un recurso invaluable tanto para educadores como para estudiantes. Descubre cómo esta máquina de vanguardia puede transformar tu aprendizaje de idiomas y elevar tus habilidades conversacionales a nuevas alturas.

Find AI tools in YBX

Related Articles

Refresh Articles