Desbloquea el Potencial del Aprendizaje Automático de Alto Rendimiento: Alquila GPUs de AWS para Entrenar Tu Modelo

Most people like

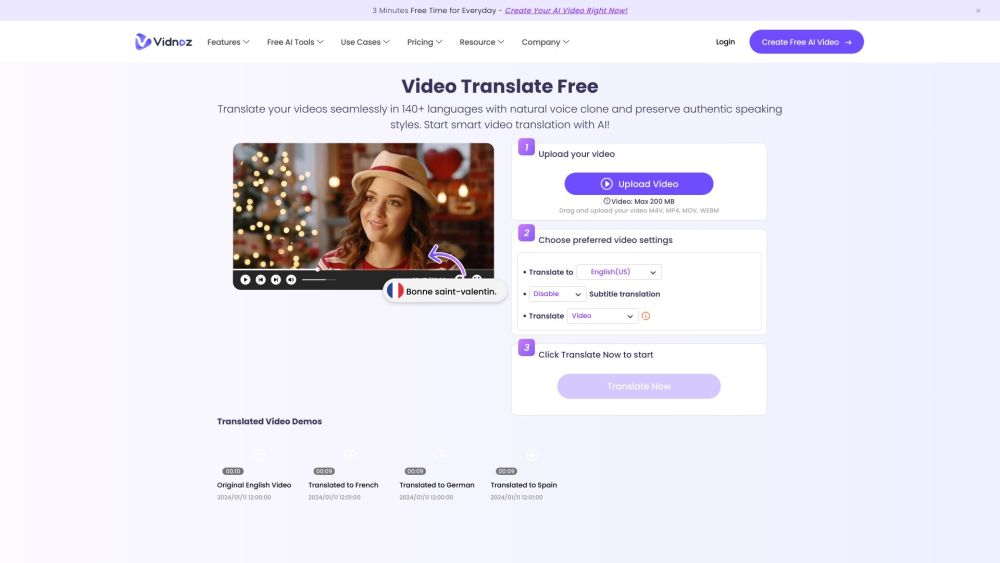

¡Traduce videos a más de 140 idiomas en solo 3 sencillos pasos!

Descubre el potencial global de tu contenido con nuestro proceso fácil de seguir para traducir videos a más de 140 idiomas. Ya sea que busques alcanzar una audiencia más amplia o mejorar la participación del público, nuestro enfoque optimizado garantiza que tus mensajes resuenen con los espectadores de todo el mundo. ¡Dile adiós a las barreras lingüísticas y da la bienvenida a una audiencia más conectada y multilingüe!

Presentamos una innovadora plataforma de creación musical impulsada por inteligencia artificial, diseñada para revolucionar la forma en que compones y produces música. Esta herramienta de vanguardia aprovecha el poder de la inteligencia artificial para agilizar el proceso creativo, brindando a músicos de todos los niveles inspiración instantánea y composiciones únicas. Desbloquea tu potencial musical y explora posibilidades infinitas con nuestra plataforma fácil de usar que combina tecnología y arte de manera perfecta. Ya seas un profesional experimentado o un principiante, nuestro creador musical de IA elevará tu sonido y mejorará tu flujo de trabajo. ¡Únete al futuro de la creación musical hoy!

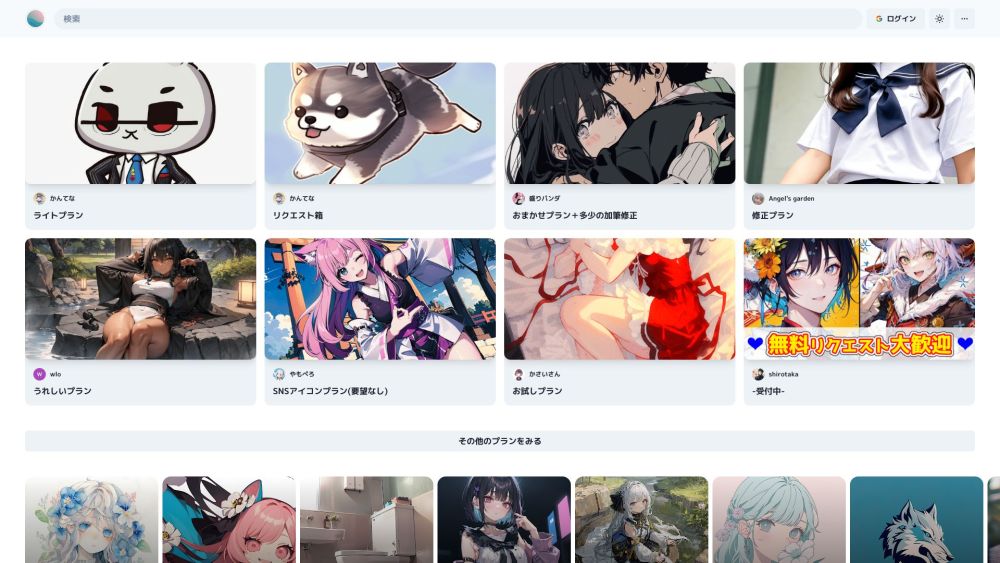

Descubre Prompton, una innovadora plataforma de ilustración mediante IA que ofrece una amplia variedad de servicios de diseño adaptados a tus necesidades creativas.

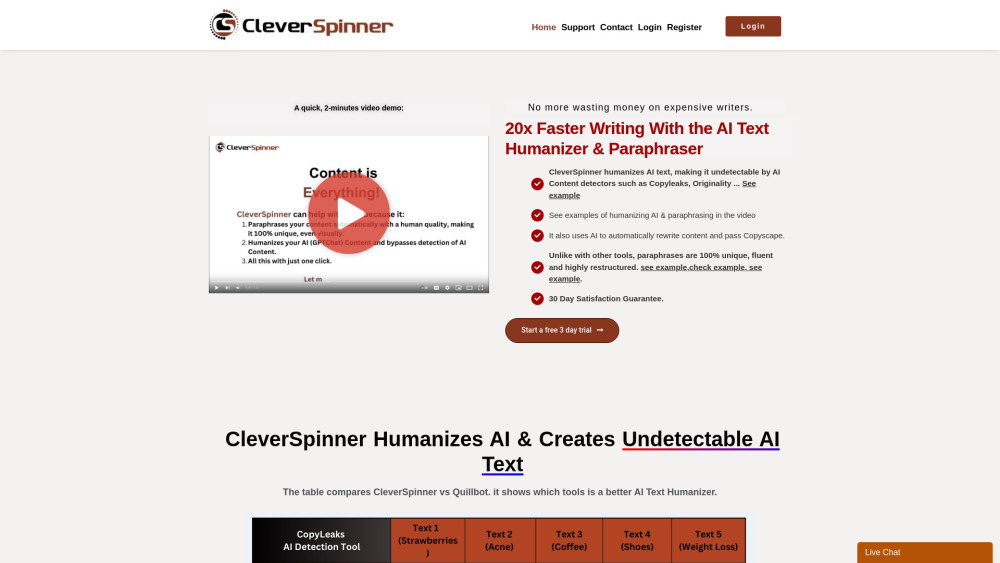

En la era digital, crear contenido único y atractivo es fundamental para destacar en línea. Un reescritor de contenido de IA, generador de variantes y humanizador puede transformar artículos existentes en piezas frescas y cautivadoras. Al mejorar la legibilidad e infundir un toque humano, estas herramientas no solo incrementan la originalidad de tu contenido, sino que también mejoran su visibilidad en motores de búsqueda (SEO). Ya seas blogger, marketero o propietario de un negocio, aprovechar soluciones de contenido impulsadas por IA puede optimizar tu proceso de escritura mientras capta eficazmente la atención de tu audiencia.

Find AI tools in YBX