Dominando Llama 3: Consejos prácticos para ajustar sin esfuerzo tu experiencia personalizada con GPT

Most people like

Presentamos una herramienta excepcional gratuita diseñada para transformar texto generado por IA en una escritura auténtica y similar a la humana. Ideal para creadores de contenido, especialistas en marketing y cualquiera que busque mejorar la legibilidad y conexión de su contenido generado por IA. ¡Descubre cómo esta herramienta puede elevar tu escritura hoy mismo!

Mejora tu experiencia en IA con cursos en línea seleccionados cuidadosamente, diseñados para potenciar tus habilidades y conocimientos en inteligencia artificial.

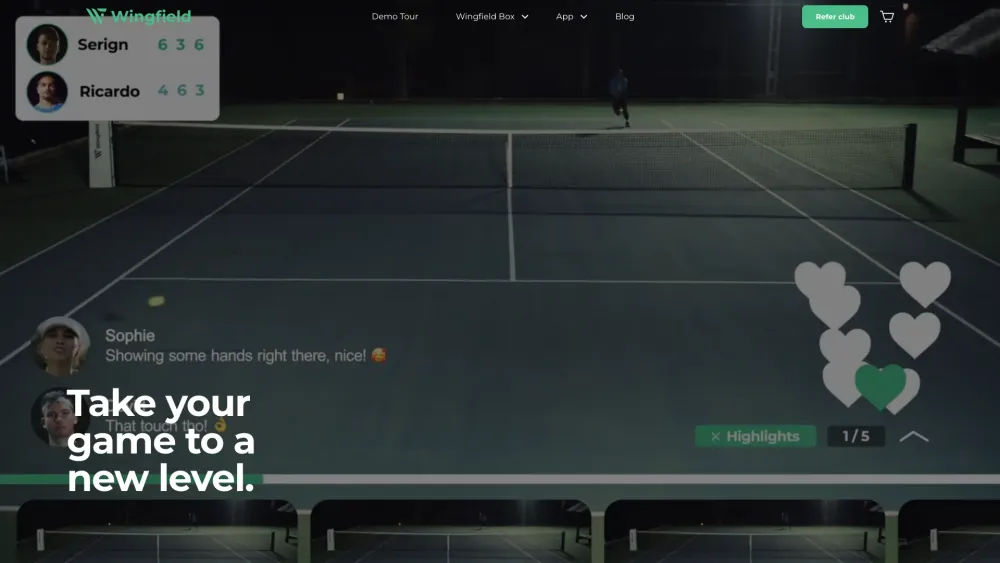

¿Estás listo para elevar tu juego de tenis desde la comodidad de tu hogar? Nuestra innovadora experiencia de tenis virtual combina tecnología de vanguardia con un juego realista, permitiéndote sumergirte en el deporte que amas. Ya seas un principiante que busca aprender lo básico o un jugador avanzado perfeccionando tus habilidades, esta plataforma interactiva ofrece sesiones de entrenamiento personalizadas, partidos competitivos y desafíos atractivos diseñados para todos los niveles. ¡Únete a una vibrante comunidad de entusiastas del tenis y transforma tu juego hoy!

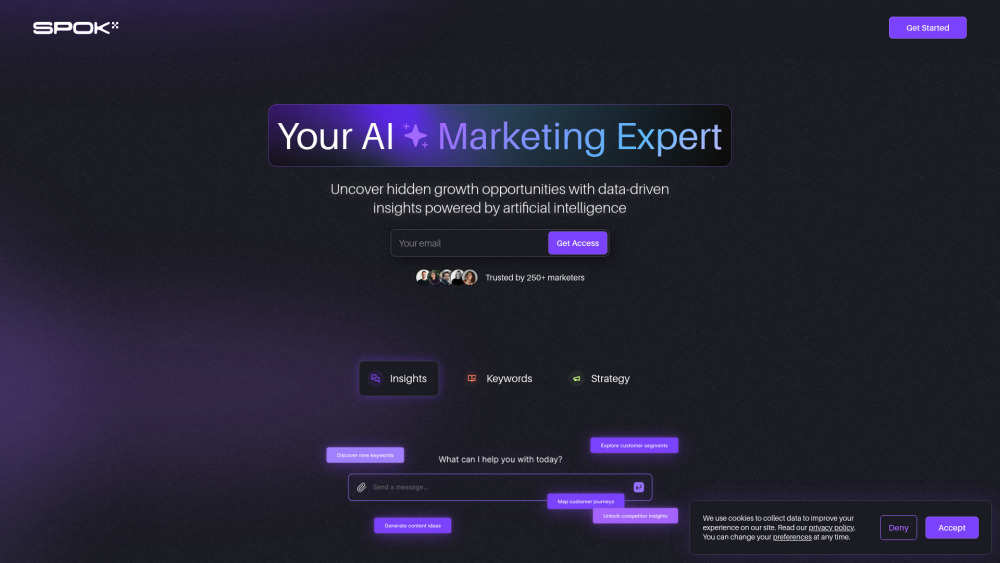

Desbloquea el Poder de las Herramientas de Marketing con IA para Obtener Insights Accionables

En el vertiginoso panorama digital actual, aprovechar el potencial de las herramientas de marketing con IA es fundamental para las empresas que buscan obtener insights accionables. Estas soluciones innovadoras utilizan analítica de datos y aprendizaje automático para ayudar a los marketers a entender el comportamiento del cliente, optimizar campañas y tomar mejores decisiones. Al incorporar la IA en tu estrategia de marketing, puedes transformar datos en crudo en insights valiosos que mejoren tu rendimiento general y aumenten el retorno de la inversión. Descubre cómo las herramientas de marketing con IA pueden revolucionar tu enfoque y mantenerte por delante de la competencia.

Find AI tools in YBX

Related Articles

Refresh Articles