El Instituto Allen para la IA presenta un LLM 'Verdaderamente de Código Abierto' para impulsar un 'Cambio Crítico' en el Desarrollo de la IA.

Most people like

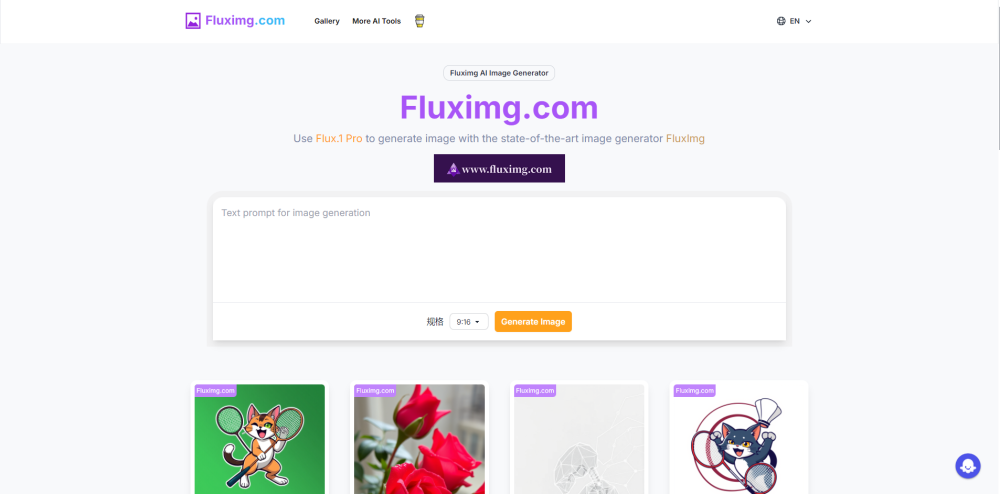

Generador de Imágenes AI: Crea fácilmente imágenes impresionantes y de alta calidad a partir de descripciones de texto.

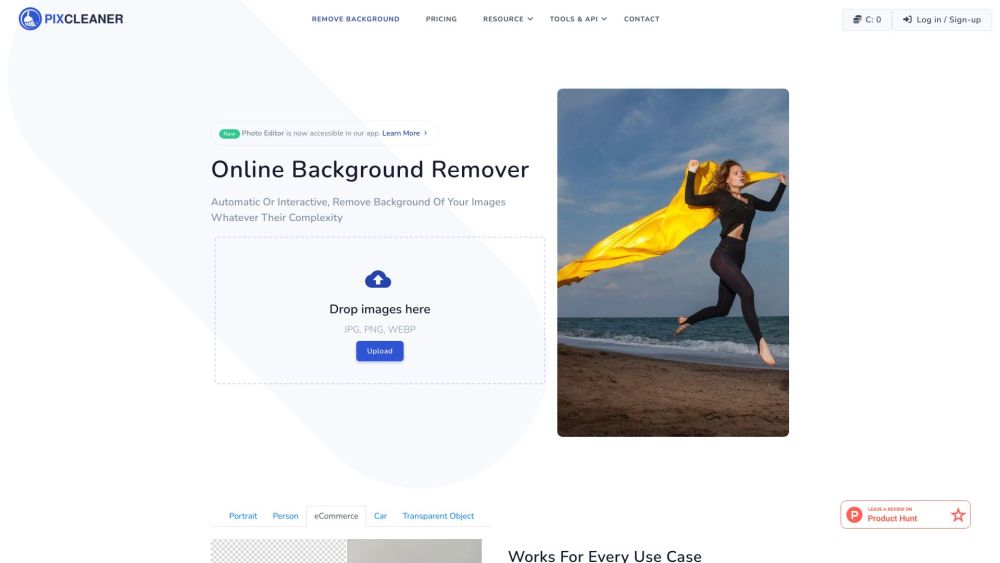

PixCleaner es una herramienta gratuita en línea impulsada por inteligencia artificial, diseñada para eliminar fondos de imágenes de manera sencilla y mejorar tus fotos de productos. Con su interfaz fácil de usar, PixCleaner simplifica la edición de imágenes, asegurando que tus visuales se destaquen.

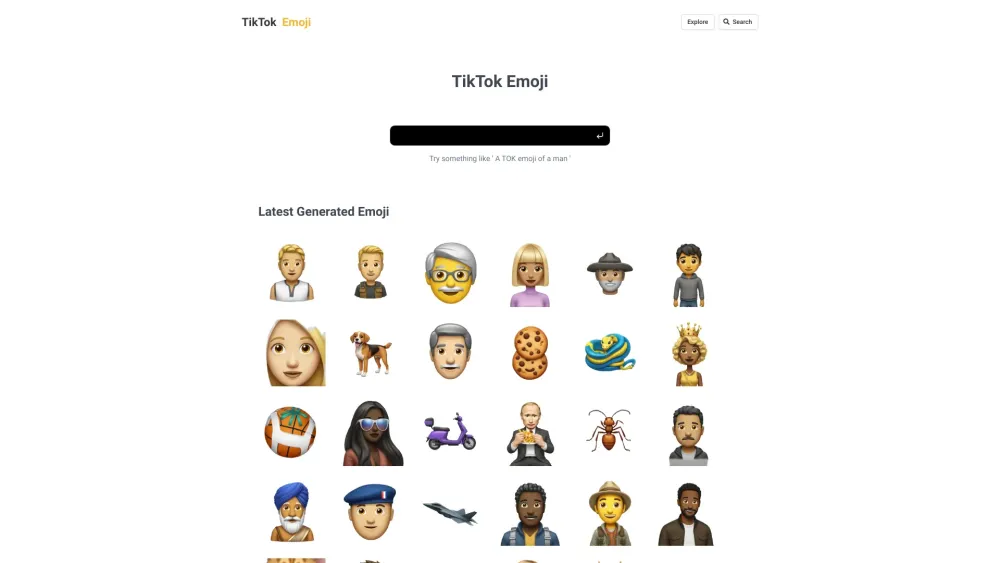

Desbloquea tu potencial creativo diseñando emojis únicos para TikTok. En esta guía, exploraremos cómo crear emojis expresivos que realcen tu contenido y capten la atención de tu audiencia. Ya sea para añadir un toque personal o para la identidad de tu marca, los emojis únicos pueden hacer que tus publicaciones de TikTok se destaquen. ¡Sumérgete con nosotros y descubre el arte de crear emojis para el éxito en las redes sociales!

Aprovecha el poder de la redacción impulsada por IA para elevar tu negocio de comercio electrónico. Descubre cómo la automatización inteligente puede generar descripciones de productos atractivas, contenido de marketing cautivador y mensajes personalizados para los clientes, todo pensado para aumentar la interacción y las ventas. ¡Explora hoy el impacto transformador de la IA en tu tienda en línea!

Find AI tools in YBX

Related Articles

Refresh Articles