El presidente de OpenAI presenta la primera imagen creada por GPT-4o.

Most people like

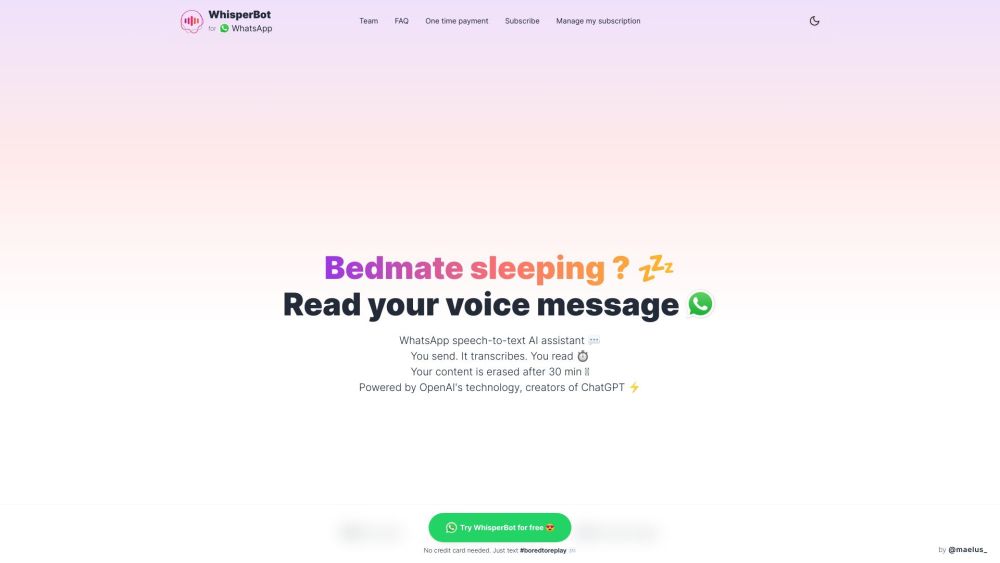

Presentamos WhisperBot, tu asistente inteligente de IA para WhatsApp que transforma sin esfuerzo los mensajes de voz en transcripciones textuales precisas. Disfruta de la comodidad de leer mensajes fácilmente en lugar de escucharlos, todo con el poder de la tecnología de IA más avanzada.

Smodin es una plataforma innovadora diseñada para mejorar las habilidades de escritura mediante una variedad de herramientas adaptadas para estudiantes, profesionales y creadores de contenido en todo el mundo.

Esta aplicación en línea crea vídeos deepfake intercambiando caras y garantizando la privacidad del usuario.

Desbloquea el poder de nuestra innovadora herramienta de IA, diseñada para optimizar el análisis de documentos y videos con una eficiencia inigualable. Mejora tu productividad y tus conocimientos mientras navegas de manera fluida a través de grandes volúmenes de contenido, transformando datos complejos en conocimiento accesible sin esfuerzo. Perfecta para empresas e investigadores, esta solución de vanguardia revoluciona la forma en que interactúas con la información.

Find AI tools in YBX