Los Retos de la IA en la Investigación Legal: Un Estudio sobre las Alucinaciones en Herramientas de IA Legal

Los modelos de lenguaje grandes (LLMs) se utilizan cada vez más en tareas que requieren un procesamiento de información extenso. Varias empresas han desarrollado herramientas especializadas que aprovechan los LLMs y sistemas de recuperación de información para la investigación legal. Sin embargo, un reciente estudio de investigadores de la Universidad de Stanford revela que, a pesar de las afirmaciones de los proveedores, estas herramientas aún presentan una tasa considerable de "alucinaciones", es decir, resultados que son incorrectos desde el punto de vista factual.

Resumen del Estudio

Esta investigación pionera es la primera "evaluación empírica preregistrada de herramientas de investigación legal impulsadas por IA", que compara las ofertas de importantes proveedores de investigación legal con el GPT-4 de OpenAI en más de 200 consultas legales elaboradas. Aunque se encontró que las alucinaciones se redujeron en comparación con chatbots de propósito general, las herramientas de IA legal aún presentaron alucinaciones en el 17-33% de los casos, indicando una prevalencia preocupante.

Comprendiendo la Generación Aumentada por Recuperación en Contextos Legales

Muchas herramientas de IA legal emplean técnicas de generación aumentada por recuperación (RAG) para mitigar las alucinaciones. A diferencia de los LLMs estándar, los sistemas RAG recuperan documentos relevantes de una base de conocimiento y los contextualizan para las respuestas del modelo. Aunque RAG es un estándar de oro para reducir alucinaciones en varios dominios, las consultas legales a menudo carecen de respuestas sencillas, lo que complica la recuperación de información.

Los investigadores apuntan que determinar qué recuperar puede ser problemático, especialmente en consultas novedosas o legalmente ambiguas. Definen las alucinaciones como respuestas incorrectas o mal fundamentadas, ya sean factualmente inexactas o contextualmente irrelevantes. Además, la relevancia de los documentos en el ámbito legal va más allá de la mera similitud textual, lo que significa que recuperar documentos que parecen similares pero son irrelevantes podría afectar la efectividad del sistema.

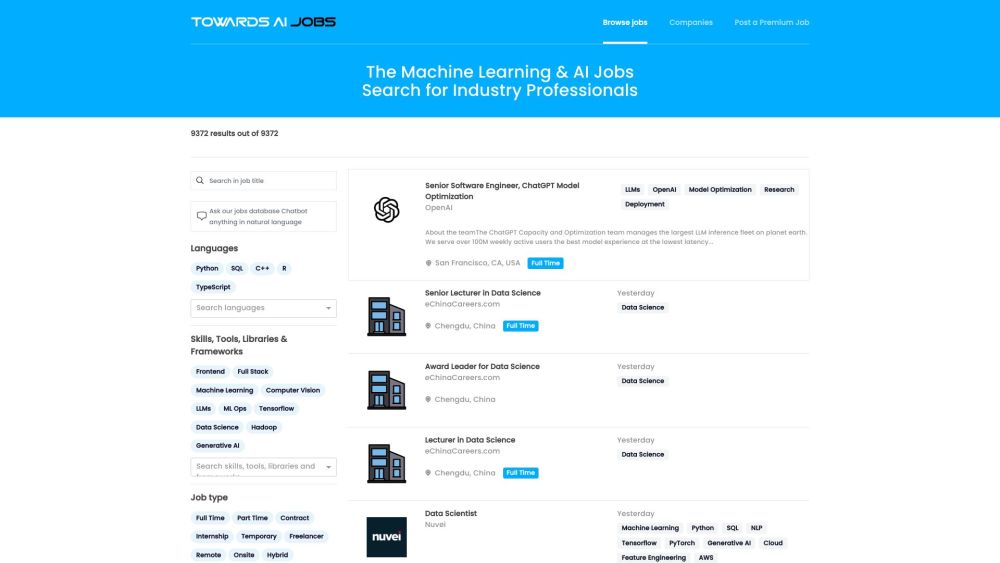

Evaluando Herramientas de IA para la Investigación Legal

Los investigadores diseñaron una variedad de consultas legales que reflejan escenarios reales de investigación, probando tres prominentes herramientas de investigación legal impulsadas por IA: Lexis+ AI de LexisNexis, Westlaw AI-Assisted Research y Ask Practical Law AI de Thomson Reuters. Aunque estas herramientas utilizan RAG, el estudio encontró que su rendimiento no estaba exento de fallos, ya que aún presentaron un número significativo de alucinaciones.

El estudio destacó las dificultades que enfrentan estos sistemas en tareas fundamentales de comprensión legal, lo que genera preocupaciones sobre la naturaleza cerrada de las herramientas de IA legal, que limita la transparencia para los profesionales del derecho.

Avances y Limitaciones de la IA en la Investigación Legal

A pesar de sus limitaciones, la investigación legal asistida por IA proporciona valor en comparación con los métodos de búsqueda por palabras clave tradicionales, especialmente cuando se utiliza como punto de partida en lugar de la autoridad definitiva. Según el coautor Daniel E. Ho, RAG reduce las alucinaciones legales en comparación con la IA general, aunque los errores aún pueden surgir de la recuperación inapropiada de documentos, lo que enfatiza que la recuperación legal sigue siendo particularmente compleja.

La Importancia de la Transparencia

Ho subrayó la urgente necesidad de transparencia y de estándares en la IA legal. A diferencia de la investigación en IA general, el sector de tecnología legal ha mantenido un enfoque cerrado, proporcionando poca información técnica o evidencia de rendimiento. Esta falta de transparencia presenta riesgos para los abogados que dependen de estas herramientas.

En respuesta al estudio, Mike Dahn, jefe de Gestión de Productos de Westlaw, enfatizó el compromiso de la empresa con pruebas exhaustivas y la complejidad de las preguntas legales, sugiriendo que los hallazgos de la investigación podrían reflejar cuestiones poco frecuentes en la investigación asistida por IA. Por su parte, LexisNexis reconoció que, aunque ninguna herramienta de IA puede garantizar la perfección, su enfoque se centra en mejorar y no sustituir el juicio del abogado. Jeff Pfeifer, Director de Producto en LexisNexis, indicó que los criterios utilizados por los investigadores pueden no reflejar adecuadamente las tasas de alucinación y destacó las mejoras en curso.

De cara al futuro, LexisNexis y la Universidad de Stanford están en conversaciones para establecer estándares y marcos de reporte de rendimiento en la aplicación de la IA a la investigación legal, buscando mejoras que sirvan mejor a los profesionales del derecho y reduzcan la incidencia de alucinaciones.

En conclusión, aunque la IA en la investigación legal muestra un gran potencial, los desafíos de las alucinaciones y la necesidad de transparencia siguen siendo cuestiones críticas que la industria debe abordar.