GPT-4 Demuestra Habilidades de Hackeo: Descubriendo y Explotando Vulnerabilidades de Seguridad en el Mundo Real

Most people like

Resumen: AIPRM es una poderosa herramienta de gestión de prompts acompañada de una biblioteca de prompts colaborativa, diseñada específicamente para inteligencia artificial generativa. Únete a nuestra comunidad para mejorar tus proyectos de IA con prompts elaborados por expertos.

Presentamos Gamma.AI: una solución avanzada impulsada por inteligencia artificial, diseñada para monitorear las actividades de los empleados y alertarlo de inmediato sobre errores de seguridad. Con su tecnología de vanguardia, Gamma.AI ayuda a proteger su organización al garantizar el cumplimiento y minimizar riesgos.

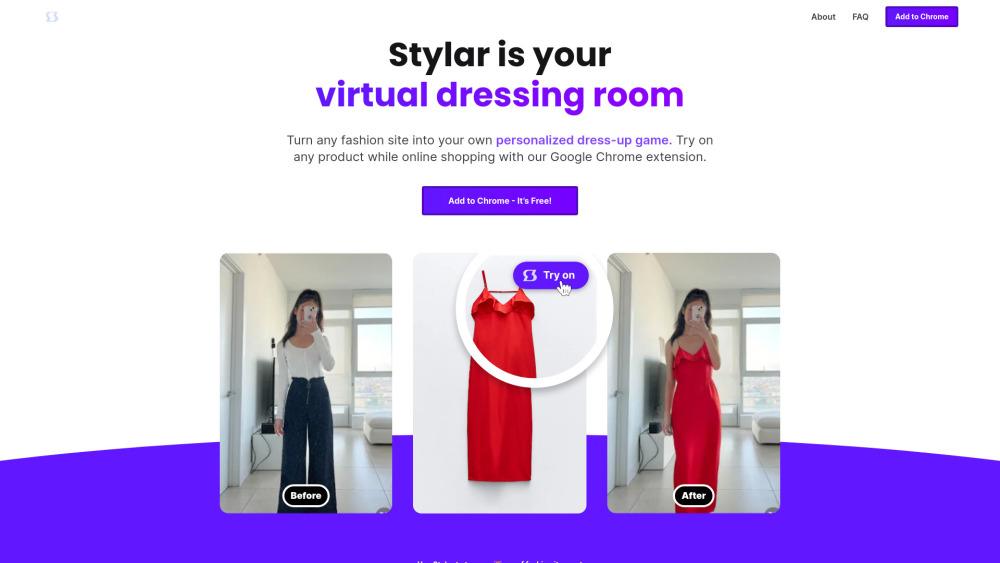

En el acelerado mundo digital de hoy, el auge de la inteligencia artificial (IA) ha transformado nuestra forma de comprar en línea, especialmente en lo que respecta a la ropa. La tecnología de prueba virtual permite a los consumidores visualizar cómo les quedarían las prendas sin salir de casa, mejorando la experiencia de compra. Esta solución innovadora está cambiando la manera en que las personas abordan la moda, facilitando y haciendo más placentera la búsqueda del atuendo perfecto. Con los avances en IA, los probadores virtuales se están convirtiendo en herramientas esenciales tanto para los minoristas como para los clientes, cerrando la brecha entre las compras físicas y las en línea.

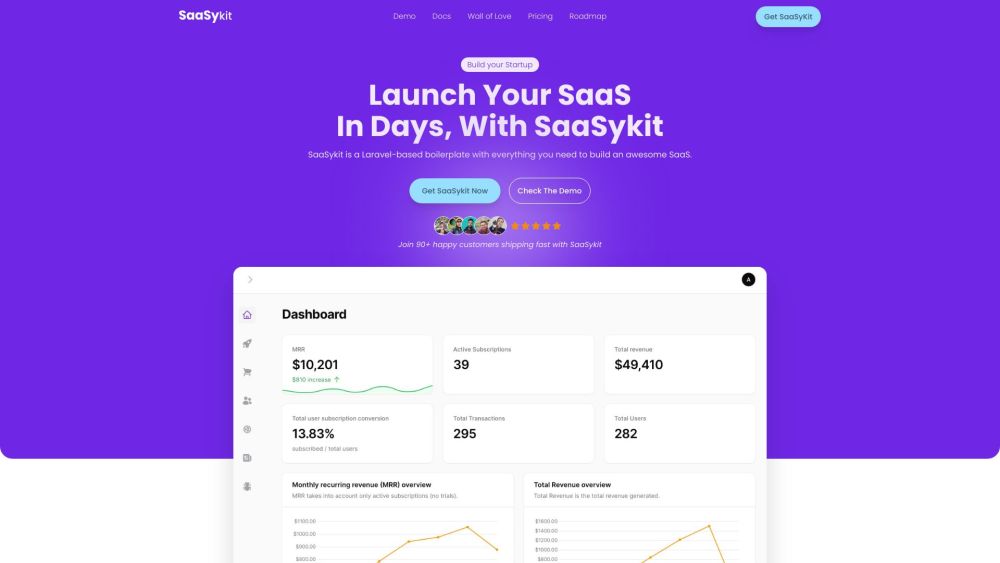

En el vertiginoso panorama digital actual, acelerar el desarrollo de Software como Servicio (SaaS) es crucial para las empresas que buscan mantenerse competitivas. Con las estrategias y herramientas adecuadas, las organizaciones pueden optimizar sus procesos de desarrollo, mejorar la colaboración y ofrecer soluciones de software innovadoras más rápidamente. Esta guía explora técnicas efectivas para acelerar el desarrollo de SaaS, asegurando que puedas satisfacer la creciente demanda de los clientes y alcanzar tus objetivos empresariales más rápido que nunca. Descubre cómo optimizar tu ciclo de desarrollo y impulsar el crecimiento en la industria del SaaS.

Find AI tools in YBX

Related Articles

Refresh Articles