Google Cloud Run se integra con las GPU de Nvidia para mejorar la inferencia de IA sin servidor.

Most people like

FeedHive es una plataforma innovadora impulsada por inteligencia artificial, diseñada para crear y gestionar de manera sencilla contenido atractivo para redes sociales. Ya seas propietario de un pequeño negocio o un gestor de redes sociales, FeedHive simplifica tu estrategia de contenido y mejora tu presencia en línea, facilitando más que nunca la conexión con tu audiencia.

Descubre el innovador mundo de la generación musical con IA, donde puedes transformar tus palabras escritas en cautivadoras melodías. Nuestro generador de música con IA gratuito te permite convertir fácilmente texto en composiciones musicales originales, empoderando a artistas, aficionados y a quienes son apasionados de la música para explorar nuevos horizontes creativos. Sumérgete en la experiencia fluida de crear bandas sonoras únicas que resuenen con tus ideas y emociones, ¡todo sin costo alguno!

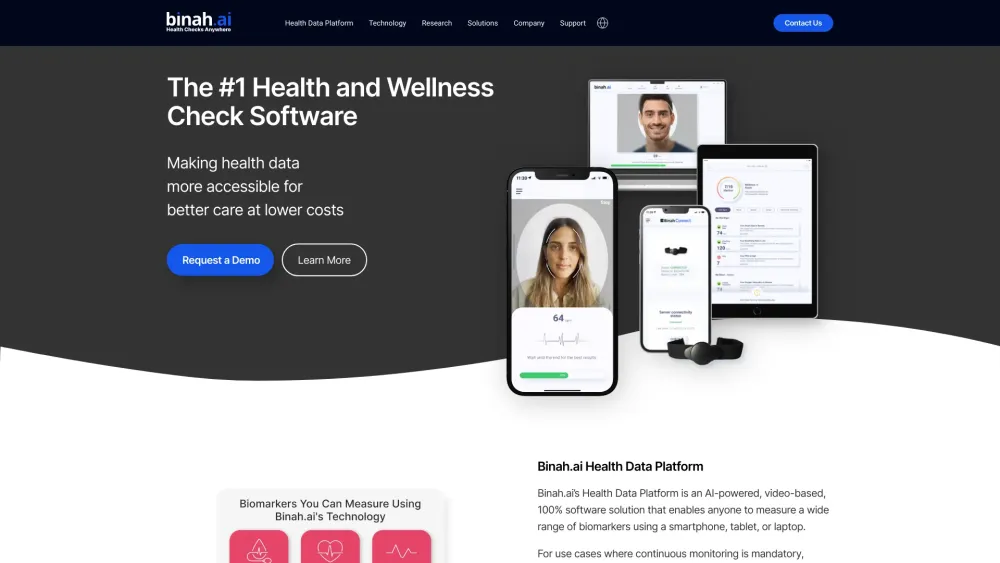

Revolucionando la Salud: Monitoreo en Tiempo Real a través de Tecnología de Video

Descubre cómo la tecnología basada en video está transformando el monitoreo de salud en tiempo real, ofreciendo soluciones innovadoras para seguir métricas de salud de manera eficiente. Este enfoque vanguardista no solo mejora la atención al paciente, sino que también empodera a las personas para que tomen el control de su bienestar. Explora el potencial de esta tecnología para revolucionar el panorama de la atención médica.

Revolucionando el Contenido de Video con IA: Abriendo Nuevas Posibilidades

En el panorama digital actual, aprovechar la IA para transformar el contenido de video ofrece oportunidades sin precedentes para creadores y empresas. Esta tecnología innovadora mejora la narrativa, aumenta el compromiso y optimiza los procesos de producción, convirtiéndola en un factor determinante en el mundo multimedia. Descubre cómo la IA está dando forma al futuro de la creación de contenido de video y ayudando a las marcas a conectar de manera más efectiva con sus audiencias.

Find AI tools in YBX

Related Articles

Refresh Articles