Informe de Menlo Security: Aumento de Amenazas Cibernéticas Asociadas a la Adopción de IA

Most people like

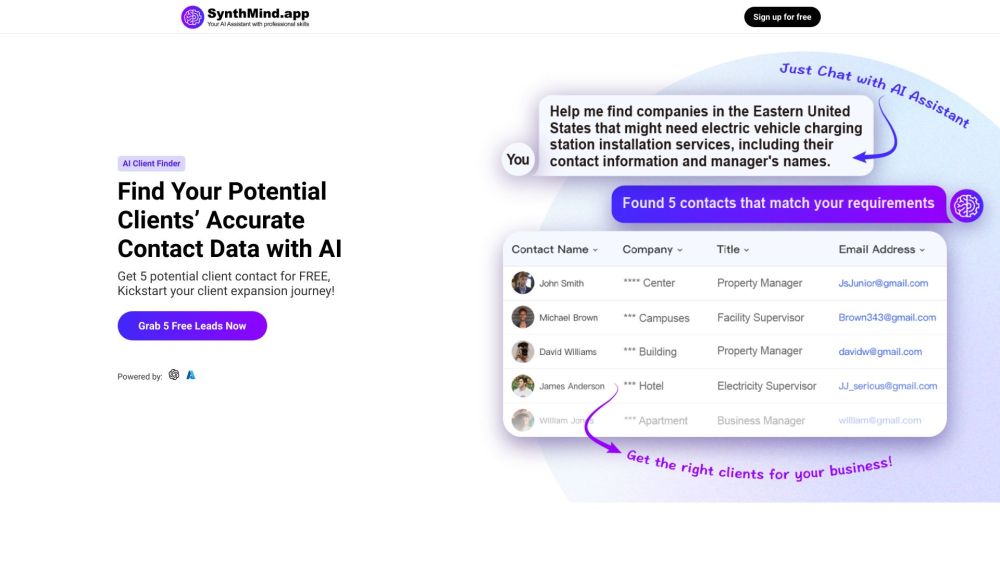

Descubre nuestra herramienta de generación de leads impulsada por IA, diseñada para identificar sin esfuerzo a posibles clientes y proporcionar su información de contacto. Esta solución innovadora optimiza tu proceso de acercamiento, ayudándote a conectar con prospectos de manera más efectiva que nunca.

Descubre el potencial transformador de una plataforma de redacción de contenido impulsada por inteligencia artificial, diseñada para mejorar tu proceso de escritura. Al aprovechar una avanzada inteligencia artificial, esta innovadora herramienta simplifica la creación de contenido, permitiéndote producir artículos, publicaciones de blog y copias publicitarias de alta calidad sin esfuerzo. Ya seas un escritor experimentado o un profesional ocupado, esta plataforma te capacita para generar contenido atractivo rápidamente, manteniendo tu voz única. ¡Eleva tu experiencia de escritura hoy con lo último en tecnología de IA!

En el paisaje digital actual, captar la atención es más crucial que nunca. Un generador de video por IA para texto y fotos te permite convertir fácilmente contenido escrito e imágenes en videos cautivadores. Esta herramienta innovadora simplifica el proceso creativo, permitiéndote involucrar a tu audiencia con narrativas visuales impactantes. Ya seas creador de contenido, comercializador o propietario de un negocio, aprovechar un generador de video por IA puede elevar tu narración y mejorar tu presencia en línea. Descubre cómo transformar tu texto y fotos en videos atractivos que resuenen con los espectadores y aumenten el compromiso.

Presentamos el escritor de ensayos Fast & Smart AI: tu solución ideal para crear ensayos de alta calidad de manera rápida y sencilla. Ya seas un estudiante con plazos ajustados o un profesional que busca mejorar su escritura, nuestra herramienta impulsada por IA está diseñada para generar contenido atractivo en un abrir y cerrar de ojos. Descubre tu potencial de escritura y transforma tus ideas en ensayos bien estructurados sin esfuerzo.

Find AI tools in YBX

Related Articles

Refresh Articles