Los equipos de seguridad están considerando cada vez más herramientas innovadoras como ChatGPT para mejorar sus estrategias de detección de amenazas. Según Dennis Xu, director senior y analista en Gartner, aunque herramientas de IA generativa como ChatGPT tienen un gran potencial para los profesionales de seguridad, especialmente en áreas como la ingeniería de detección y formación, los costos de las versiones premium pueden ser un obstáculo.

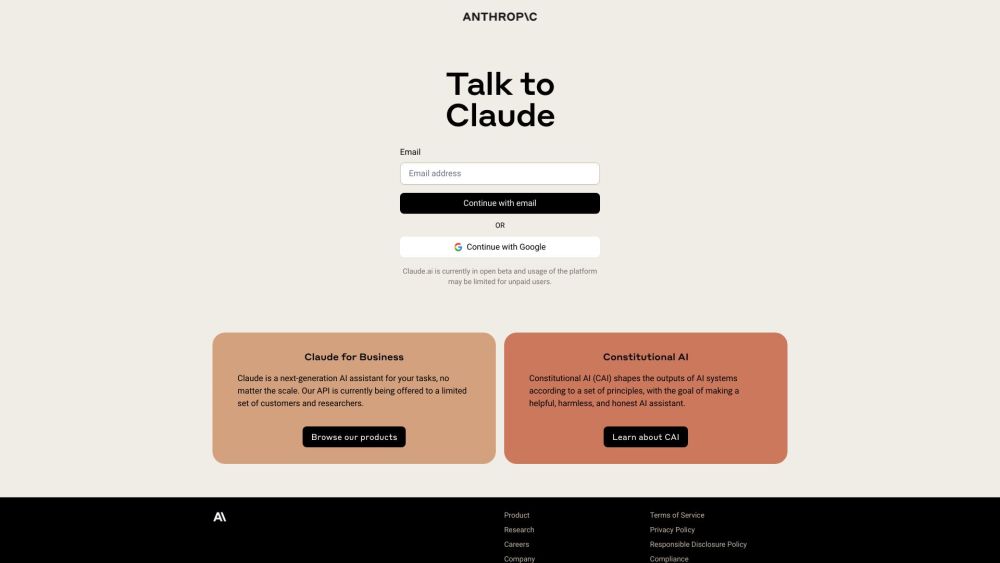

En la Cumbre de Seguridad y Gestión de Riesgos de Gartner en Londres, Xu destacó que la versión básica y gratuita de ChatGPT, basada en el modelo GP-3.5 Turbo, tiene dificultades con la retención de contexto y las tareas de codificación. Por lo tanto, los profesionales de seguridad pueden necesitar optar por ChatGPT Plus, que cuesta $20 al mes, o la nueva versión ChatGPT Enterprise para cumplir con los requisitos de sus funciones. A medida que las organizaciones crecen, estos costos pueden aumentar significativamente según la cantidad de usuarios.

Xu señaló que la versión Enterprise ofrece un mejor control de datos en comparación con las versiones básica y Plus, pero advirtió que aún puede no estar completamente lista para su implementación. A pesar de esta limitación, numerosos importantes proveedores de seguridad están desarrollando activamente funciones de IA generativa. Por ejemplo, la adquisición de Splunk por parte de Cisco tiene como objetivo reforzar las capacidades de análisis de datos, mientras que Privacera lanzó una solución de IA generativa en junio. Nvidia también presentó su biblioteca de software de seguridad de aprendizaje profundo, Morpheus, como parte de su suite AI Enterprise 3.0. Xu observó una tendencia en las empresas que integran la interfaz de lenguaje natural de ChatGPT en productos existentes para optimizar funcionalidades.

Aunque herramientas de seguridad innovadoras como WormGPT y FraudGPT han surgido con el objetivo de "estafar al estafador", Xu advirtió que acceder a estas soluciones también requiere inversión. Señaló que modelos disponibles ampliamente como ChatGPT pueden desempeñar funciones similares, como generar correos electrónicos de phishing. Esta situación ha creado lo que Xu denominó una "carrera armamentista" en el ámbito de la seguridad en IA, donde los actores maliciosos a menudo tienen ventajas. “Por solo $20 al mes, un usuario malicioso puede desarrollar malware o crear correos electrónicos de phishing, mientras que los defensores enfrentan costos significativamente mayores para lograr eficiencias similares,” enfatizó.

Es crucial entender las limitaciones de las herramientas de IA. Xu comparó a ChatGPT con un niño de cinco años entrenado en un extenso conjunto de datos: puede ser útil para ciertas tareas de seguridad, pero carece de preparación para otras. “Hay preguntas que simplemente no le harías a un niño de cinco años,” bromeó, subrayando la importancia de tener expectativas realistas y validación. En el ámbito de las Operaciones de Seguridad (SecOps), determinar la precisión de los insights generados por IA puede ser un desafío.

Xu también señaló la falta de casos de uso sólidos para aplicar sistemas de IA en la gestión de vulnerabilidades o la gestión de superficies de ataque, mencionando a Google's Sec-PaLM como el único modelo de lenguaje de detección de amenazas establecido capaz de reconocer scripts maliciosos. Sin embargo, indicó que aún se encuentra en las primeras etapas, sin benchmarks publicados.

Para los equipos de seguridad que buscan implementar herramientas de IA como ChatGPT, establecer reglas de gobernanza y manuales claros es vital. “Comprendan cuándo y cómo aprovechar las herramientas de IA, y especifiquen casos de uso claros en SecOps,” aconsejó Xu. Destacó la importancia de evitar casos sensibles al tiempo y escenarios que involucren datos corporativos confidenciales, recomendando que las organizaciones ofrezcan formación sobre interacciones con IA e implementen protocolos de monitoreo.

La conciencia sobre la deriva de la IA también es crítica. Las herramientas de IA generativa pueden no ofrecer respuestas consistentes a la misma consulta. Adicionalmente, Xu alentó a los equipos a mantenerse informados sobre las actualizaciones de la tecnología. Por ejemplo, OpenAI ha introducido recientemente nuevas capacidades para ChatGPT con GPT-4V, lo que permite interacciones de voz e imagen. Xu expresó entusiasmo por este potencial, imaginando escenarios donde los equipos podrían interactuar con sus sistemas de manera más intuitiva, simplemente tomando una foto y solicitando diagnósticos.

En última instancia, aunque las herramientas de IA como ChatGPT están listas para ayudar a los profesionales de seguridad a optimizar sus cargas de trabajo, no están destinadas a reemplazar la experiencia humana. Xu advirtió que “esta tecnología sigue siendo como un niño de cinco años” con mucho por aprender, lo que refuerza la importancia de usar estas herramientas de manera juiciosa y efectiva a medida que evolucionan.