OpenAI Presenta una Nueva Generación de Modelos de Embedding y Actualizaciones Esenciales de API

Most people like

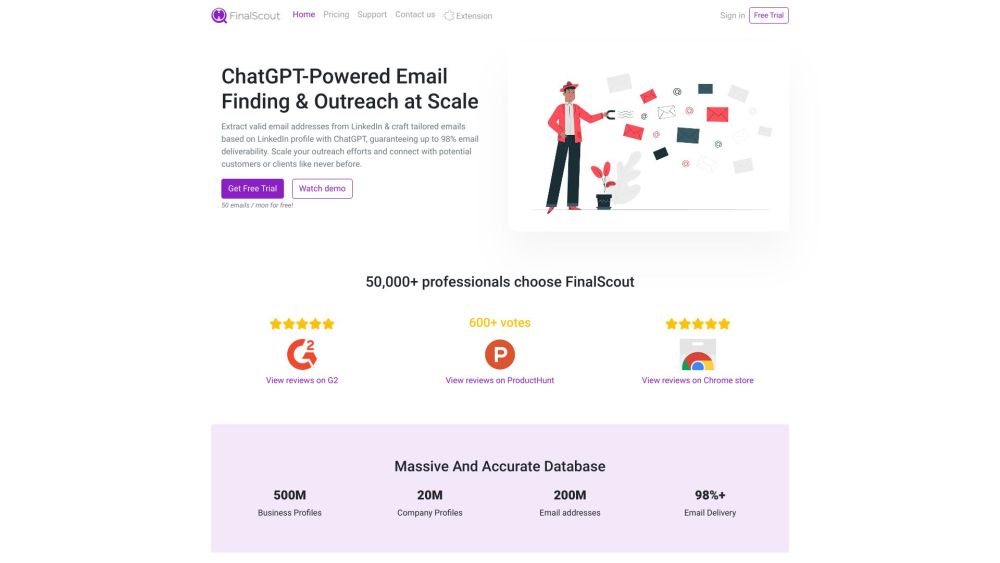

Descubre el poder de la extracción de correos electrónicos en LinkedIn y aprovecha estrategias de contacto personalizadas con ChatGPT. Mejora tu red de contactos y conéctate de manera efectiva con tu público objetivo.

Supernormal es una potente herramienta de IA diseñada para optimizar el proceso de documentación de notas de reuniones, ahorrándote un tiempo valioso mediante una automatización eficiente.

En el vertiginoso panorama digital actual, optimizar el rendimiento es esencial para las aplicaciones que dependen de la inteligencia artificial. Un cargador de modelos de IA agiliza el proceso de inicialización, lo que resulta en tiempos de arranque en frío significativamente más rápidos. Esta herramienta innovadora garantiza una experiencia fluida, permitiendo a los desarrolladores maximizar la eficiencia y mejorar la satisfacción del usuario. Descubre cómo un cargador de modelos de IA efectivo puede transformar la capacidad de respuesta y el rendimiento de tu aplicación.

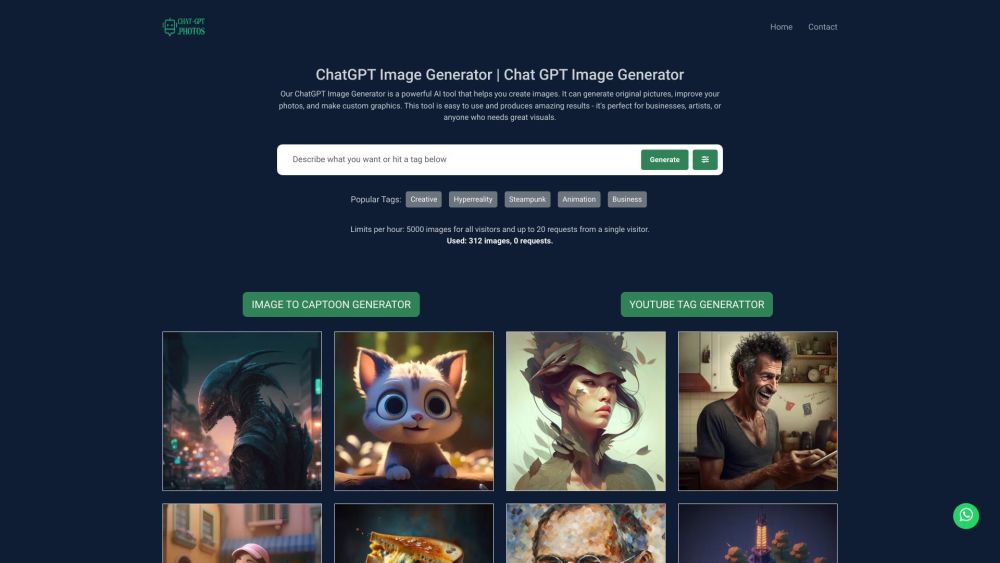

¡Desata tu creatividad con el generador de imágenes de ChatGPT! Explora infinitas posibilidades y transforma tus ideas en visuales deslumbrantes utilizando nuestra poderosa herramienta. Ya seas un artista, diseñador o simplemente alguien con pasión por la creatividad, el generador de imágenes de ChatGPT puede dar vida a tus visiones como nunca antes.

Find AI tools in YBX

Related Articles

Refresh Articles